$美国超微公司(AMD.US)$于2024年7月30日,在美股市场收盘后,正式发布了其截至2024年6月29日的第二财季财报。

CEO苏姿丰在业绩发布会上透露,与 $英伟达(NVDA.US)$AI芯片H100竞争的MI300季度收入首次超过10亿美元,一下子让华尔街沸腾起来,AMD的股价迎来久违的大涨,盘后交易时段大涨超9%。

实际上,不考虑盘后交易时段的大涨,AMD今年以来的股价累计跌幅达6.09%,远远落后于英伟达的累计涨幅109.49%,亦落后于纳斯达克指数的累计涨幅14.23%。

按每股138.44美元计,AMD当前总市值为2,237.6亿美元,仅相当于英伟达市值2.55万亿美元的8.6%,差距仍很大。

盘后股价的大幅上涨,无疑为AMD的投资者带来了期待已久的利好消息,仿佛久旱之地终逢甘霖,来之不易。

AI业务强劲增长

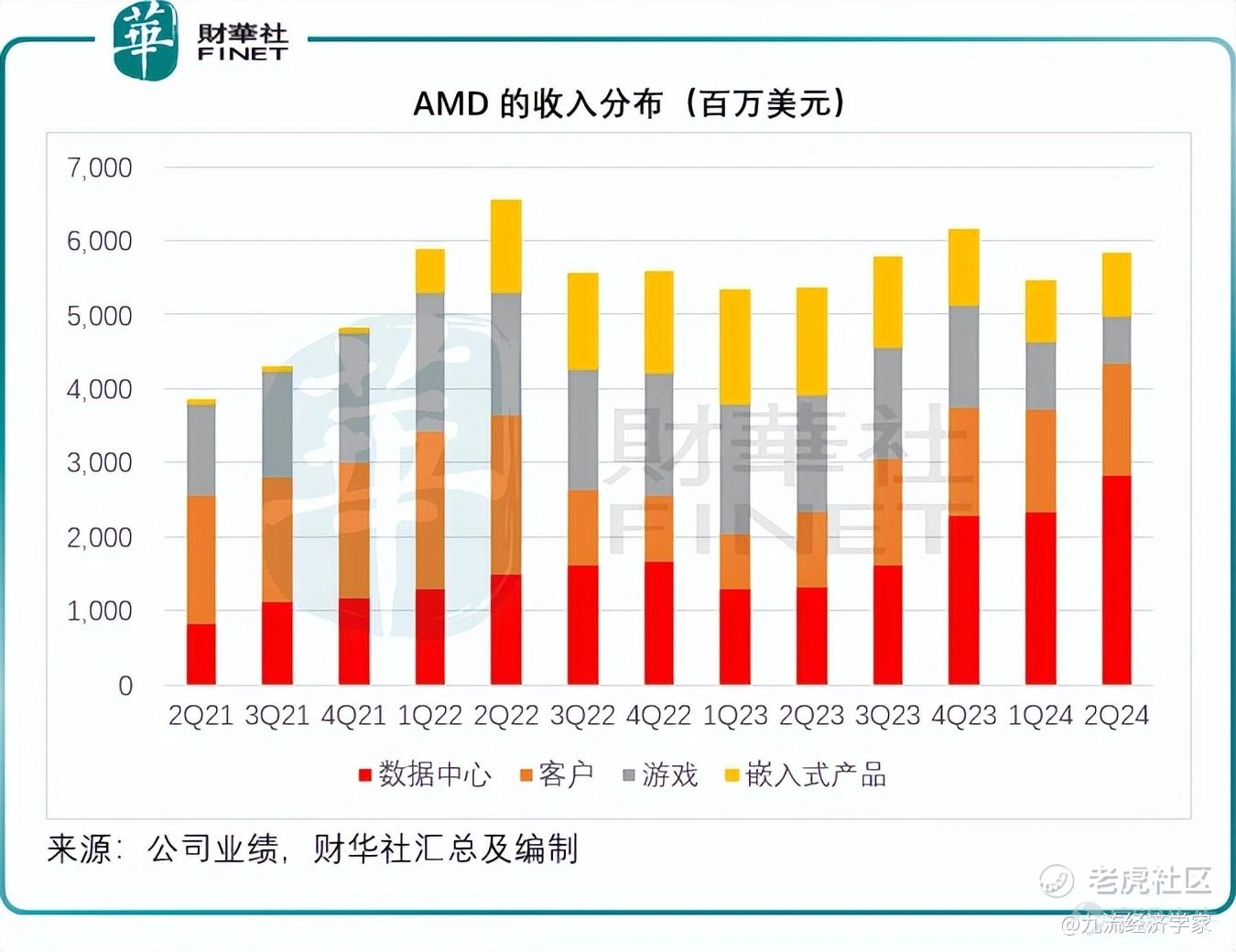

2024年第2季,AMD录得收入58亿美元,按年增长9%,按季增长7%,因数据中心和客户分部收入的强劲增长,抵消了游戏和内嵌业务分部收入的下降。非会计准则(下同)毛利率为53%,按年提高340个基点,主要受到数据中心收入增加的带动。

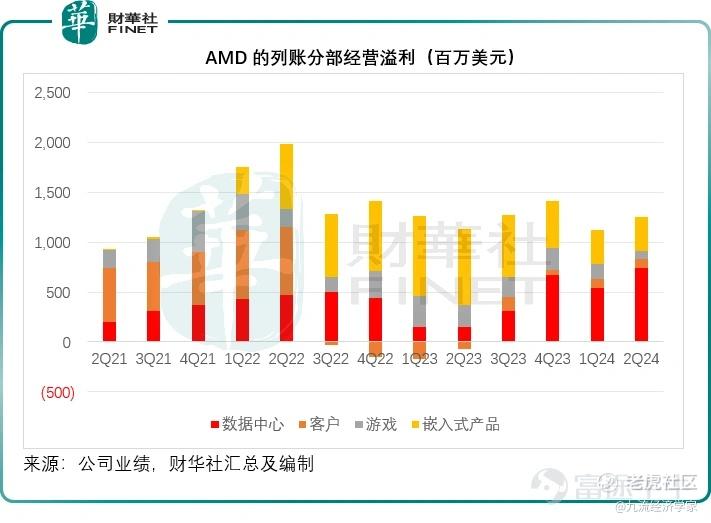

经营开支按年上升15%,至18亿美元,因其持续投资于研发以把握AI增长所带来的重大机遇。非会计准则经营溢利为13亿美元,按年增长18%,经营利润率达到22%,而上年同期为20%,上个季度为21%。摊薄后每股盈利为0.69美元,按年增长19%。

其AI业务所属的数据中心分部季度收入增长115%(或15亿美元),至26亿美元,数据中心大约占了其总收入的50%,主要受到Instinct MI300 GPU交付量大幅爬升,以及霄龙CPU销售额实现双位数强劲增长所带动。

见下图,在AI的加持下,AMD的数据中心分部收入大幅提升,到2024年第2季,占总收入的比重已达到49%,而上个季度为43%,上年同期为25%。

同时,数据中心的经营利润也大幅提升,第2季的分部经营溢利为7.43亿美元,按年增长四倍以上,分部经营利润率达到26%,而上年同期仅11%,上个季度为23%,主要得益于收入增长以及经营杠杆的改善,抵消了其对研发投入增加的负面影响。

客户分部季度收入为15亿美元,按年增长49%,和按季增长9%,主要受到AMD锐龙加速器销售增长带动,经营利润为8900万美元,经营利润率为6%,而上年同期为经营亏损6900万美元。

游戏分部季度收入为6.48亿美元,按年下降59%,按季下降30%,收入下降主要因为收入的减少主要因为半定制库存消化和低端市场需求。分部经营溢利为7700万美元,分部经营利润率为12%,而去年同期的经营溢利高达2.25亿美元,经营利润率达到14%。

嵌入式产品的季度分部收入为8.61亿美元,同比下降41%,客户的库存水平继续正常化。从环比来看,嵌入式部门的收入增长了2%,分部经营溢利为3.45亿美元,分部经营利润率为40%,显著低于去年同期的经营溢利7.57亿美元和经营利润率52%。

第2季,AMD的经营活动产生净现金流入5.93亿美元,自由现金流为4.39亿美元,存货按季增加3.39亿美元至50亿美元,因数据中心GPU产品的持续攀升。期内,AND向股东回馈3.52亿美元,回购了230万股,还剩下52亿美元的回购授权额度。

AMD人工智能业务的最新进展

AMD的数据中心GPU收入连续第三季创纪录,其中MI300季度收入首次超过10亿美元,远超市场预期。

在业绩发布会上,苏姿丰透露,AMD的“AI朋友圈”和业务规模正不断扩大。

MI300收入大增背后,正是得益于“AI朋友圈”中的Meta和 $微软(MSFT.US)$等大型科技公司。

微软也成为第一家在季度内宣布MI300X实例全面可用的超大规模企业。

据悉,微软扩大了MI300X加速器的使用范围,赋能GPT-4 Turbo和多项Copilot服务,包括Microsoft 365 Chat、Word和Teams。

此外,戴尔、惠普、联想和超微电脑(SMCI.US)都在构建Instinct平台,多家超大规模二级云供应商也将在本季度推出MI300实例。

在本月初,AMD宣布计划收购欧洲最大的私人AI实验室Silo AI,为多家企业和客户开发定制AI解决方案。

据悉,Silo团队展现出了为大型企业客户提供可扩展服务的能力,能够增强他们在大模型开发领域的专业知识储备。此举有望进一步促进AMD推理和训练解决方案的优化进程,加快其发展速度。

除了收购Silo AI、Mipsology和Nod,AMD在过去的12个月还向12家人工智能公司投资了超过1.25亿美元,以扩展AMD人工智能生态系统,为合作伙伴提供支持。

展望未来,从路线图的角度来看,AMD正在加速和扩展其Instinct路线图,每年都会推出新的AI芯片,而今年稍后将推出MI325X。

MI325X使用与MI300相同的基础架构,通过提供比竞争产品高两倍的内存和高1.3倍的峰值计算性能,提升其生成式AI性能。

此外,AMD计划在2025年推出基于新CDNA 4结构的MI350系列,与CDNA 3相比,CDNA 4架构的性能有望提高35倍。这些新产品将直接与英伟达的AI芯片进行竞争。

基于CDNA Next架构的MI400系列正在取得重大进展,AMD计划于2026年推出。

人工智能解决方案方面,博通、思科、惠普、英特尔、谷歌、Meta和微软,加入了Ultra Accelerator Link(超级链),这是一项行业标准技术,可连接数百个基于AMD经验证之Infinity Fabric技术的人工智能加速器,因此也被业界戏称为“复仇者联盟”,对撼英伟达的NVLink。

苏姿丰表示,通过将UALink与广泛支持的超以太网联盟规范相结合,他们正在建立一种标准化方法,用于大规模构建下一代高性能数据中心人工智能解决方案。

鉴于如此乐观的AI新发展,苏姿丰预计,2024年的数据中心GPU收入将超过45亿美元,比4月时AMD提供的指引40亿美元高出5亿美元。

AMD追赶英伟达

去年8月时,英国《金融时报》曾预计H100或可在2024年为英伟达带来500亿美元的收入,若按此计算,平均每个季度的收入或超100亿美元,AMD的MI300 GPU营收规模与此相比仍有很大差距,其于2024年第2季营收超10亿美元。

在AMD持续更新AI发展路线图的时候,英伟达也没闲着,今年年初发布了H100的升级版B100和B200 GPU,预计在今年稍后时间交付。3月时,英伟达发布了“Blackwell”模型,可能在今年稍后或2025年交付。

值得留意的是,英伟达之前曾表示按“每年”一枚新“芯”的速度发布新产品,而在此之前英伟达的发布时间长达两年,但在今年6月的台北电脑展开幕前夕,英伟达CEO黄仁勋发布了新一代人工智能平台“Rubin”,将接替即将推出的Blackwell平台。该平台将配备新GPU、基于Arm的新CPU—Vera,以及采用NVLink 6、CX9 SuperNIC和X1600、并融合InfiniBand/以太网交换机的高级网络平台。

据外媒wccftech报道,Blackwell GPU的第一代(B100/B200)将在今年稍后进入数据中心,而英伟达还计划发布一个增压版本,该版本将具有8个站点的12Hi内存堆栈,而不是现有产品的8个站点的8Hi内存堆栈。该芯片预计将于2025年推出。

而新一代的Rubin R100 GPU将组成R系列产品线,预计会在2025年第4季量产,DGX和HGX解决方案等系统预计会在2026年上半年量产。据英伟达的说法,Rubin GPU和相应的平台将在2026年上半年推出,而Ultra版则会在2027年推出。英伟达还确认Rubin GPU将使用HBM4内存。

黄仁勋还宣布,每年推出新的Spectrum-X产品的计划,以满足AI对高性能以太网网络平台日益增长的需求。此外,英伟达还推出AI模型推理微服务NVIDIA NIM,通过已经优化的容器的形式提供模型,部署在云、数据中心或工作站上。

尽管面对AMD和英特尔(INTC.US)的前后夹击,还有终端客户如特斯拉(TSLA.US)自研芯片以降低对其依赖的挑战,英伟达在AI芯片市场仍一枝独秀,占据超过八成的市场份额,AMD在短期内恐怕仍难以赶上,但若未来的AI发展所带来的回报未如预期,英伟达的前途也将面临考验。

精彩评论