耳朵被虐哭?正义老师傅怒搓 AI 为“听感”报仇!

耳朵被虐哭?

正义老师傅怒搓 AI 为“听感”报仇!

文 | 史中

(零)红烧肉引发的血案

铁柱不顾旁人劝阻,找了一位黑客女友。

然而命运的馈赠早就暗中标好了价格。

今天,他和女票吵架,女票不知施了神马法术,把铁柱的手机网速封印在了 6kbps,然后夺门而出消失在夕阳下。

这个网速简直是诅咒,短视频刷不开,游戏打不了。手机唯一的作用就剩下给女友发信息道歉了。。。。

但铁柱不打算屈服。

事已至此,先吃饭吧。他决定自己做一道红烧肉。

切好了肉,烧热了油,诶,后面该咋弄嘞?

铁柱掏出手机,搜索红烧肉的菜谱。然后,网络像体弱的邮差一样,艰难地搬运远方的消息。

等了足足一分钟,才看完介绍:“红烧肉是一道很普通的家常菜,一锅浓油赤酱,肥而不腻,放在桌子上一拍抖三抖。”

又等一分钟,加载出一张红烧肉成品的图片。。。

又等了半分钟,才出现第一步操作:准备新鲜的五花肉。

铁柱心态崩了,一怒之下关掉网页,嘴角流下了不争气的泪水。

就在这时,他突然想到另一个女人——妈妈。

他打开手机QQ,试着给妈妈拨了语音电话。

网页都打不开,语音他也没抱希望。

但老妈的声音传过来时,铁柱惊呆了,居然清晰流畅。

千里之外,老妈挥斥方遒,一边跳着广场舞,一边指挥灶台前的铁柱做好了红烧肉。

那一刻,铁柱突然被老妈的厨艺治愈,决定把女友召唤回来一起吃饭,两人冰释前嫌,从此没羞没臊地生活在一起。。。

浅友们,故事当然是我编的,但其中的硬核技术却是千真万确的:

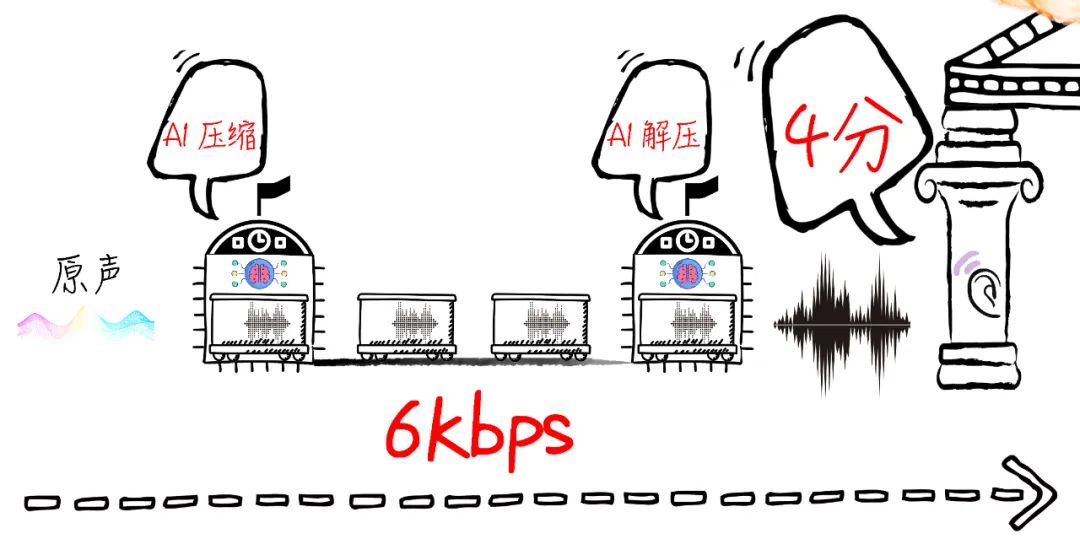

如今的腾讯老师傅,真的能够在打开网页都费劲的 6kbps 的极限弱网下实现“通话自由”。

这个技术得来不易,背后还藏着一串动人的故事,且听中哥慢慢道来。

(一)只有耳朵负重前行的世界

“啪!”

肖玮突然打了一个响指,我一激灵。

“你有没有发现,人对于声音事件是非常敏感的?”他说。

作为研究音频信号传输十几年的腾讯老师傅,肖玮对音频熟悉到了“从声波里都能看出梦娜丽莎”的程度。

腾讯的技术老师傅

他告诉我一件很委屈的事情:

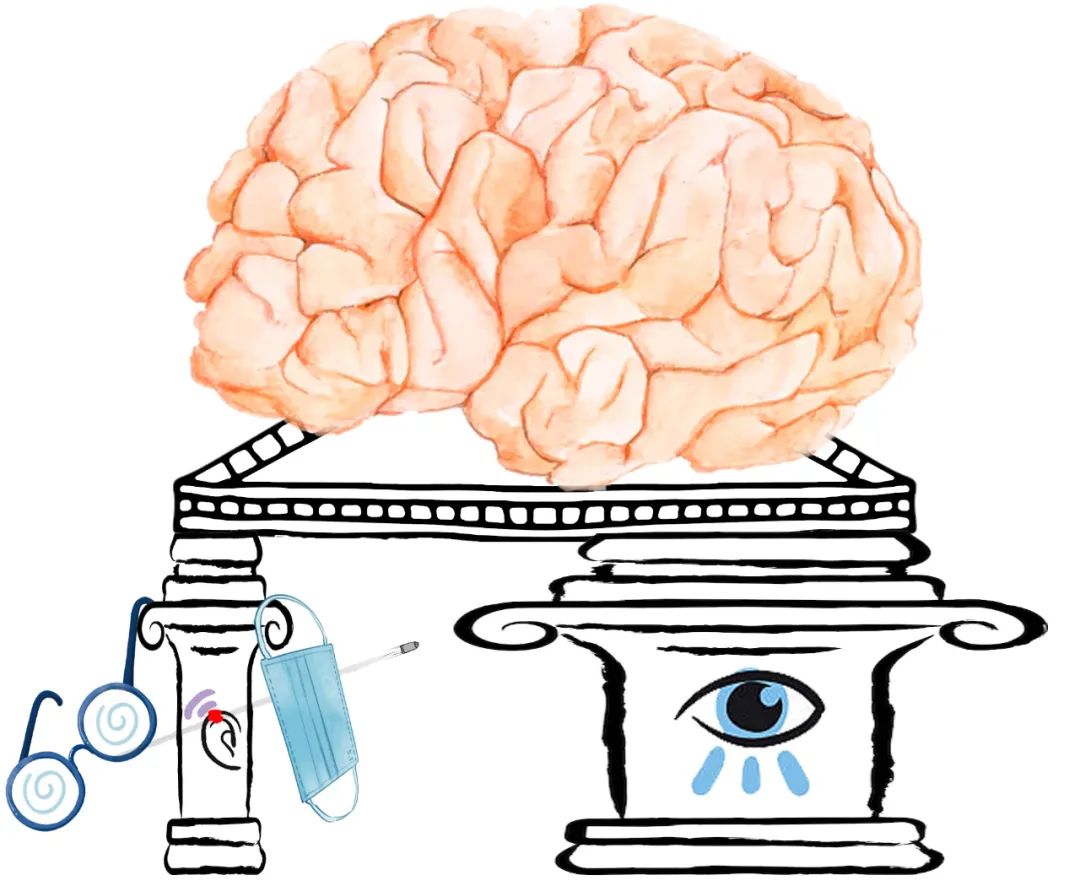

千万年来,听觉都在用极小的“带宽”承担着极大的“信息量”。

啥意思呢?

人的脑袋上,有700万个视觉细胞,却只有2万个听觉细胞。

要是把它俩比作公司,那眼睛是个有 700 万员工的“大厂”,耳朵则是只有 2 万人的“创业公司”。

可是凭胸而论,人做决策所使用的视觉信息和听觉信息的比例,绝对不会是 700:2 这么夸张。

科学家们研究,根据场合的不同,视听信息在人们决策中的比例大概在 8:1 ~ 3:1 之间。

可以说,听觉用极其有限的数据量,托起了我们对于环境感知的半壁江山——贡献可谓杠杠的!

这还没有算把口罩带眼镜腿都勒耳朵上(甚至有时候还得挨一枪)的贡献。。。

耳朵负重前行。。。

话说回来,这科学吗?

音频是怎么用这么窄的带宽,贡献了这么丰富的信息量呢?

原因就在于,人脑对音频信号的处理极其精细:

环境里的噪音突然变化,人立马会感觉哪里不对劲;

说话声音有瑕疵、失真、微弱的颤动,人都能分辨出来。(甚至有时人们不愿承认声音的贡献,把它归功于第六感。。。)

说到这,我提醒你注意:日常服务各个感官的资源也不是平均分配的——分配给视频的资源一般是大头,分配给音频的资源一般是零头。

先说硬件:

就拿 iPhone 15 Pro max 来说,总共558美元的硬件成本,屏幕占了 110 美元,摄像头 90 美元;而扬声器和麦克风各自只有10美元左右。。。

再说软件:

就拿“腾讯会议”来说,一般要给高清视频预留的带宽是 4Mbps(每秒400万个比特),传输音频一般只给留 100kbps(每秒10万个比特)。

耳朵没人疼爱。。。

所以说,音频工程师玩儿的都是高端局:要用极其有限的软硬件资源,来硬控敏感且挑剔的耳朵。

他们面前的游戏是酱的:

如果用 100kbps 的网速楞传原始的音频,就是把大象塞冰箱,纯纯 Mission Impossible!

于是,前面只有两条路。

1、降低音频采样率。

你弱水三千我只传一瓢还不行?比如上世纪90年代的电话机,听筒里的声音听起来非常闷,这就是采样率低的结果。

2、降低音频采样率,再用某种算法处理,尽量往原声音“找补”一下。

没错,这个操作就是我们都听说过的“压缩”。从早期的 ADPCM 到上世纪90年代出现的 MP3 格式,也算是抚慰了一代人的耳朵。

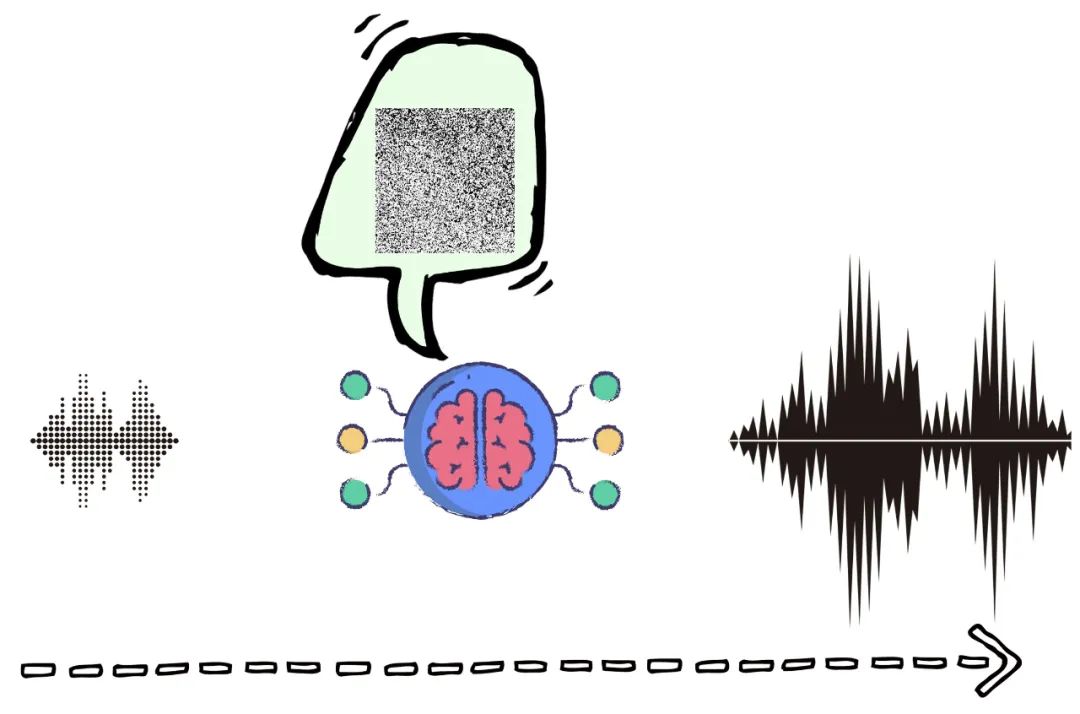

压缩的原理大概是这样↓↓↓

敲黑板!一涉及到“压缩算法”,这个事儿就考验技术了!

因为算法和算法之间的差异,就像是“张华考上了北京大学,李萍进了中等技术学校,我在百货公司当售货员”这么大。

而且你知道吗?生命体的智能水平差异,本质上就是压缩能力的差异。不久前我写了一篇文章《当 AI 活成了你的样子》,就是在探讨这个道理,强烈建议浅友去看看。

虽说人类对于音频的压缩算法一直在进步,但最近十几年,已经一度慢到了“挤牙膏”的程度。

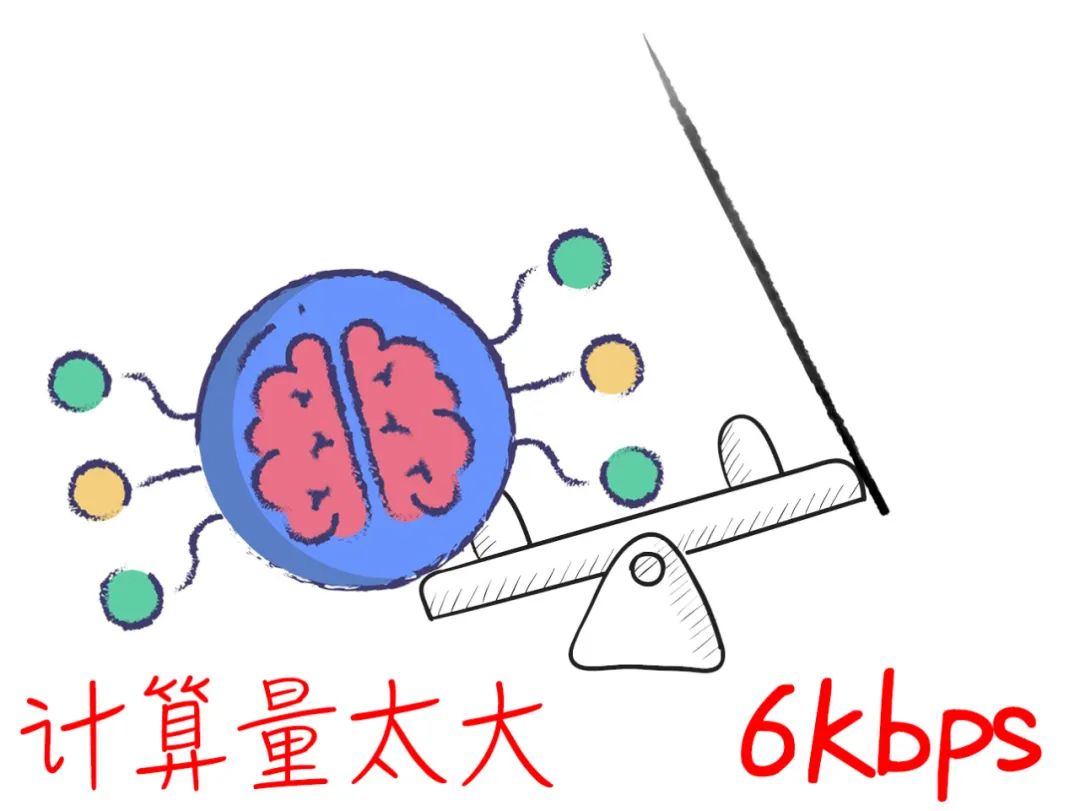

老师傅把能想的辙都想了,但把已有技术发挥到极限后,压缩就变成一个纯跷跷板:

1、要想省带宽,就得费算力。

2、要想省算力,就得费带宽。

这很好理解。既然传输的原始数据少,那很多结果都得靠大量计算得到嘛!反之,你要不想做这么多计算,原始数据还不给多些?

不过,漫长的黑夜总会过去。

2019 年左右,一丝不易察觉的曙光开始洒落。

(二)以假乱真术:我们时代独有的光芒

我们来打一个比方。

现在,你是 A 国博物馆的馆长。

B 国对 A 国发动了战争,眼看就要攻下首都。总统决定撤离,撤离前给你派来一列火车,让你挑选一些最能代表 A 国文明的文物。

总统凝重地说:这一去,也许世世代代都无法再回来了。我们的后人就要靠这一列车的文物来理解我们的文化,重建我们的文明。

你眼泪下来了:“总统,我们的文化博大精深,别说一车皮,就是一百车皮也拉不下啊!”

总统说:“为了给你挤出这一列火车,已经有无数前线将士失去了弹药补给,不可能再多了!”

请问,这时你会怎么办?

你能想到的办法,肯定是召集博物馆的专家讨论,选出你们认为最能代表 A 国文明的文物,然后反复尝试用最紧凑的方式打包,把这一火车皮塞到爆!

没错,不知不觉中,你已经在研发压缩技术了。

1)为了能最大程度重建 A 国文明,不同专家选出的代表文物肯定不同,这就是使用的“采样方案”不同;

2)同样是塞满一车皮,好的专家确实能选出维度更丰富,更适合重建文明的文物组合,也就是说,他们的压缩方案更优。

但是!无论怎么挑选文物,这些方法最终都归为“经典压缩技术”的范畴。

难道。。。还有什么更逆天的,降维打击的骚操作??!!

没错,现在换中哥来当博物馆馆长。

中哥把专家们都叫来,让他们四步走:

1、找到最有代表性的文物,然后只留关键部分。把霓裳剪开,只留最精美的纹饰;把瓷瓶打碎,只留最核心的图案。

2、然后再从不同领域挑选一些最有代表性的完整器物,不用太多;

3、把这些”零件“用最紧凑的方法打包,同样一车皮,我们当然可以携带更多东西。

4、到了新家园,我们依靠少量的完整器物加上众多的精美残片,再加上文物专家的经验和智慧,利用当地找来的辅助材料,就能复原这些文物。

用这种方法复建的博物馆,最终拥有的文物数量可能比只带完整文物的方法多三倍以上,完全突破了经典方法的上限↓↓↓

看到这,你可能皱眉:咋还破坏文物呢?那最后复原出来不是赝品了么?

这就说到了精髓。

我们的目标是“对文明负责”,而不是“对某个文物负责”。你可以说最后复原出来的文物是赝品,但它是根据科学严谨的方法复原的,“赝”得有道理!在传续文明的意义上,它可以达到和真实文物几乎一样的效果。

而且你想想,在传统方案中,我们可是把更多的“文物”给整个丢弃了,这难道不是更大的罪过吗?

看完这个比喻,我想你已经猜到了这种新一代的音频压缩方案,那就是——“人工智能加持的编解码”,简称 AI Codec。

它可以只用过去三分之一的数据量,复原出和传统压缩算法一样,甚至更好的音质。

肖玮所在的腾讯会议天籁实验室,前后花了五年时间磨出这支宝剑—— Penguins AI 语音引擎。

少废话,先看东西,哦不,先听东西!

第一段是原始音频:

第二段是用经典算法 OPUS 适配正常的 20kbps 码率时压缩的音频:

第三段是腾讯老师傅用 Penguins 压缩后,用不到三分之一码率,也就是 6kbps 传输的音频:

第四段是用经典算法 OPUS 在 6kbps 码率下的压缩音频:

人的耳朵很敏感的,我保证你听到“第四段”时,已经不能忍它的全损音质了。

明确告诉你,这第三段音频就是使用“声音残片”借助 AI 恢复后的“赝品声音”。

现在只有 6kbps 的网速,只能在“三”和“四”中间选一个,你会选哪个?

反正就算是天王老子来了,我也会选第三个。

说到这儿,我插一句。并不是说以前的音频老师傅有什么道德洁癖,死活不愿意用 AI 生成赝品声音,而是因为之前的 AI 技术根本达不到“以假乱真”的效果。

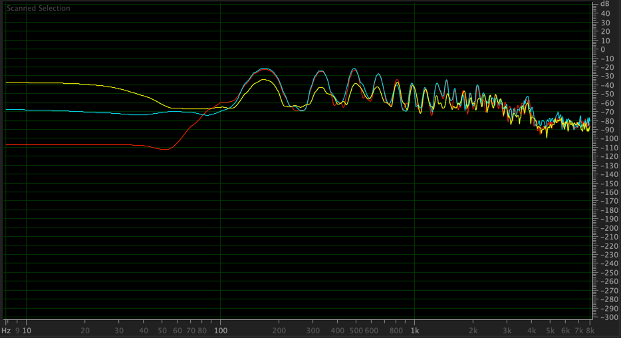

不同码率传输,恢复后的频谱对比(红色:原始语音 / 蓝色:Penguins@6kbps / 黄色:OPUS@6kbps)可见蓝线与红线非常接近。

我们有幸能听到这第三段声音,需要感谢“生成式人工智能”(AIGC)在最近几年的突飞猛进。

话说,腾讯师傅是怎么用人工智能把这些声音残片修复到和真的声音一毛一样嘞?

接下来看中哥徒手劈砖,给你掰开来讲讲其中的道理。

(三)从“二刺猿美少女”说起

先给你推荐一个网址(链接放文末)。你点进去,啥也不用干,它就会给你自动生成图片。

啥图片嘞?二次元美少女头像。

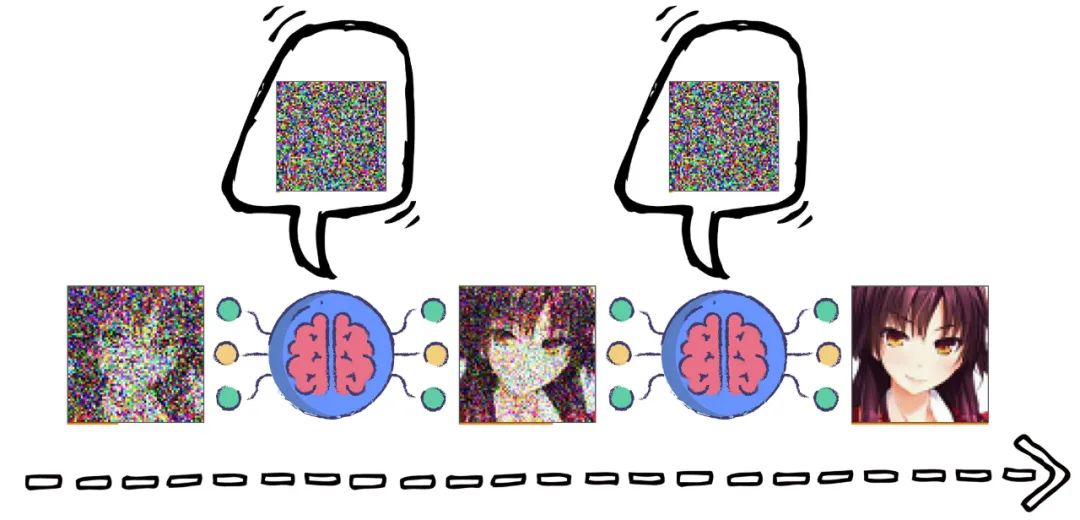

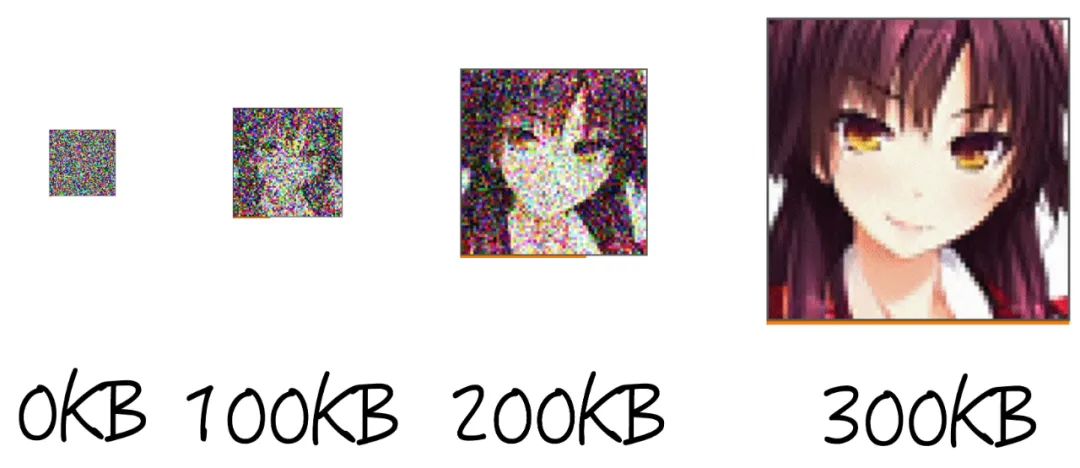

你盯着一张图片的生成过程,会觉得匪夷所思。因为它最初就是一堆“雪花”,然后每隔半秒就刷新一次,每刷一次就清晰一点儿,直到最后,少女定格在屏幕上。

我 50x 加速给你看下:

没错,这张图片就是这堆“雪花”通过 AI 模型算出来的。

具体来说,这个 AI 模型预测的是“噪声”↓↓↓

每一次它都会根据现有图片预测哪些点位是噪声,然后从图片中把噪声去掉;

再在这张新图的基础上重新计算噪声,去掉;

如此迭代300次,就出现了一张少女图。

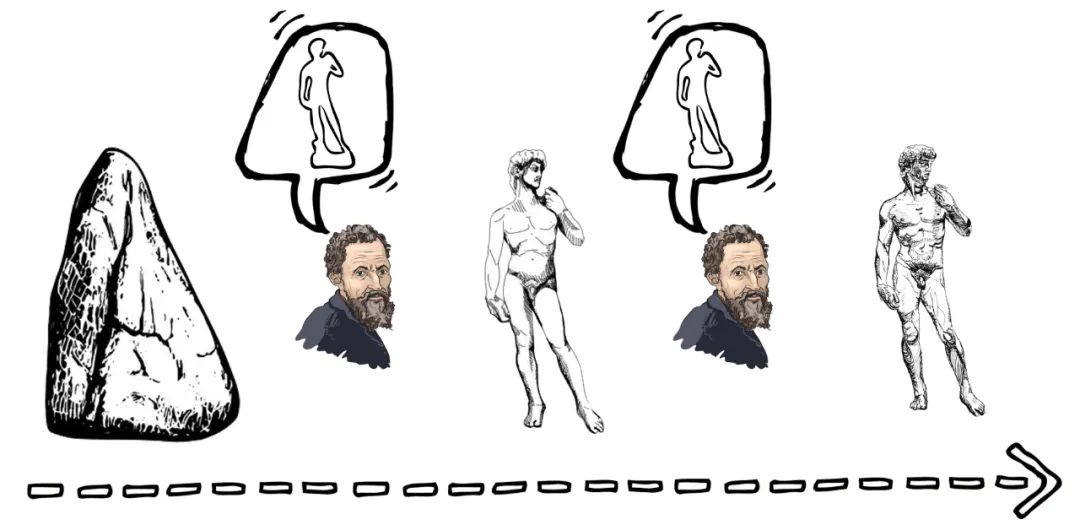

这个过程就像米开朗基罗从一块里石头里反复敲掉碎屑,一直敲掉 300 层,每一层敲掉的都是“噪声”。最后剩下的部分,就是“大卫”。

你可能会问:为啥这个 AI 模型不断去掉噪声,最后剩下的就是美少女呢?为啥不是老爷们、皮卡丘?

因为这个 AI 模型当初就是用无数美少女的图片训练出来的。其中饱含着对全世界美少女头像特征的理解,它只会画美少女。

就像米开朗基罗刚动手的时候,虽然脑海里不能确切描摹出大卫成型后的每一寸肌肤,但他“方向性地”知道自己要雕一个健硕男子,最后肯定不会离谱到雕出个皮卡丘。

而随着他一层层雕刻,大卫的样子果然逐渐出现,最后定格成现在的样子。

好,我们说回“美少女生成模型”。

从信息论的角度看:减少噪声的过程,就是向其中不断添加信息量的过程。

在开始的第 1 步,图像是一堆完全随机正态分布的噪点,谁都猜不出最后出来的美少女是啥样,其中蕴含的信息量可以视为0;

但到了第 100 步,图像中已经蕴含了一些信息,但如果你是个老二刺猿,也许基本能猜出最后的成品是啥样了。

到了第 200 步,图像中的信息已经很丰富了,哪怕你是个普通人,也基本能猜出最后成品的样子了。

到了第300步,你就不用猜了,所有信息都展现给你了。

注意!

从第1步到第300步,图片里的信息量逐渐增加,图片文件也越来越大。

如果我把信息含量更少的“第200步”版本传给你,而你手里的 AI 模型恰好能够把它复原成第 300 步的成品,咱俩不就可以节省传输成本么?

在你同样可以恢复图像的前提下,我给你传递这张图片的“第 100 步”版本,成本不就越低么?

说到这,估计聪明的浅友已经感觉到这个“美女生成模型”和“声音复原模型”的关系了。

它们本质上就是一件事儿!

1、把我声波里的关键信息做一些提取;

2、然后把提取结果发给你;

3、你再用专门的 AI 模型把它还原出来!流量带宽不就妥妥省下了吗?

2019年夏天,腾讯会议天籁实验室负责人商世东找到同学们,就是商量这个神秘的议题。

作为在音频领域深耕二十多年资深音频人,商世东清楚编码器对生态的价值,这么多年也亲历了不少编码器江湖的往事,他觉得新的时代快到了。

大家一致决定,开始在 AI Codec 的“无人区”里搞搞事情。

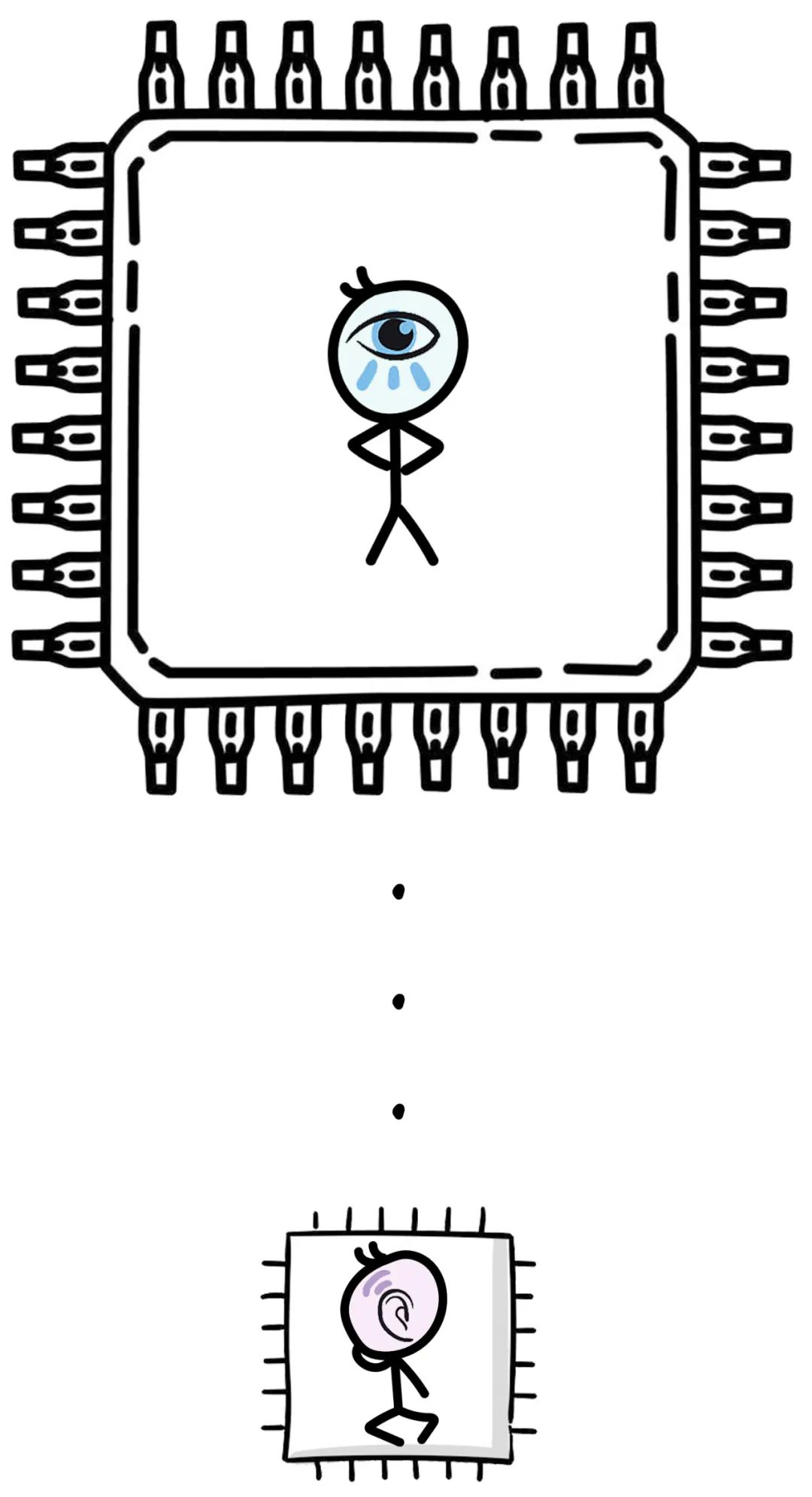

之前我们说过,AI Codec 就像是在文物局部取碎片,而 Codec 就像是取整个的文物,它俩的采样机制完全不同。可以说,AI Codec 为核心的编解码器,几乎是一项全新的技术。

全新的技术,破旧立新,改天换地,多酷!

从看热闹的角度确实酷,从干活儿的角度嘛。。。这里面有三个大坑:

第一坑,这个 AI 模型受到的限制贼多。

这里就得提到 Penguins 底层技术的另一个贡献者:腾讯 AI Lab。

腾讯 AI Lab 的阳珊告诉我,实时通信的场景既要高质量,又要低复杂度,还要低延时。单独满足某一个都不难,但做出既要又要还要的模型,就纯纯难煞打工人了。

第二坑,腾讯这帮产品经理,那可是太难缠了。

腾讯以产品著称,所以产品经理极其宠溺用户。

他们“龟毛”到了啥程度?但凡技术同事拿来的新玩意儿可能造成用户体验有一丝一毫的下降,甭管成本降低多少,都不可能更换。您就别找我谈,面斥不雅。。。

所以,在找产品经理之前,老师傅必须在家里先“暗搓搓”测试完。

腾讯会议质量测试团队的高雄告诉我,他们专门搓了一个评价系统,同时测试传统方案和 AI Codec 方案,这样才方便比较嘛。

这个系统外号叫“包青天”,每次改进,但凡有一点不合格就会打回来,技术老师傅开心得拳头都硬了。

其实,技术团队和测试团队两拨师傅从没红过脸,毕竟知道他们“是为自己好”。。。

第三坑,还得看新技术的改造成本呢!

根据天籁实验室的经验,音频编解码技术要是在体验打平的前提下,成本不降低个20%,产品团队基本不会考虑。

然鹅,刚才我们说了,AI Codec 是一项全新的技术。如果说传统编解码器的升级像是把房子重新装修,那么 AI Codec 就像是把房子拆了重盖!

这么大动干戈,只多 20% 的好处,那人家房东肯定还是不干啊!

2019 年底,肖玮他们就关起门来打过算盘,要想让新编解码器惊艳世人,起码得把性能提升个 300% 神马的。。。

在业界,对于音频质量的好坏其实是有一个评分标准的。5 分是完美,0 分是完全没法听。

腾讯产品的“龟毛”要求,一般最低得是 4 分,最好是 4.5 分。

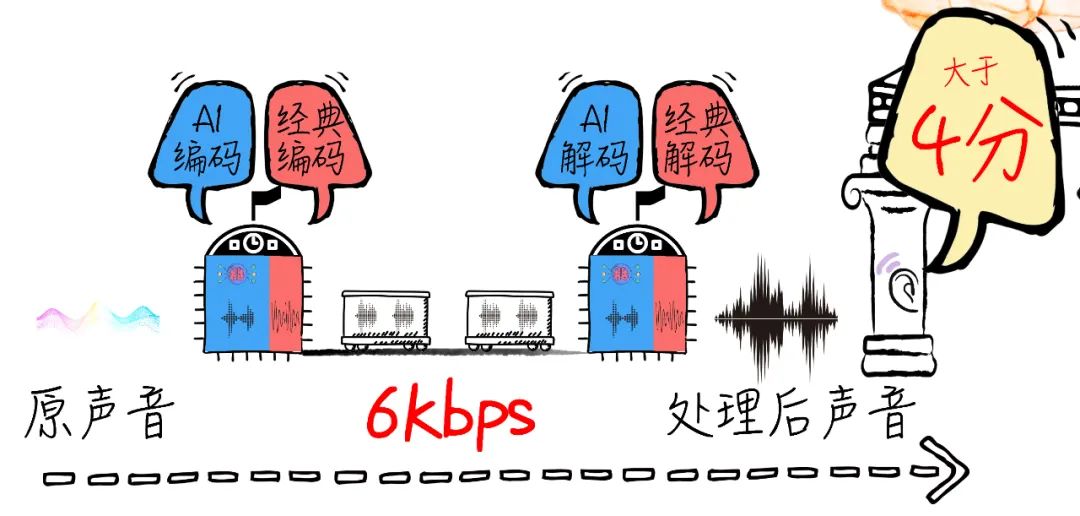

要想保证 4 分的用户体验,音频界公认的最低网络要求大概是 20kbps,也就是说,天籁实验室的目标只能是:效果做到 4 分以上的同时,把网络要求降低到 6kbps!

就像下面酱↓↓↓

当时老师傅们算出这个数,把自己都吓了一跳。

因为根本做不到,打死也做不到。。。

搞技术要实事求是,不能搞什么“亩产万斤”,他们只好含恨把这条技术路线放下了。

但是,这个念头如微弱的火苗,一直在大家的脑回路里燃烧,等待有一天找到喷薄的出口。

(四)不管黑猫白猫

话说,老师傅到底卡在哪了呢?

你还记得我们之前说过的“跷跷板”么?

在技术一定的前提下,带宽和算力是此消彼长的关系。

如果用 AI 模型来做编解码器,把带宽速率压到 6kbps 其实是可以的,但是此时要把它恢复到 4 分的音质,就需要一个很大的模型来搞,甚至光靠 CPU 都跑不动,得上 GPU。

这个模型说大,其实也不大。全世界对于音频处理的要求都是很苛刻的,不可能给到和视频处理一样的软硬件资源,大概整个手机,能划给你5%~8%的算力就顶天了。

当然各个手机的算力不同,但平均而言,这个限制下,模型的个头(或计算量)至少得从姚明砍到郭敬明。

可是怎么砍呢?

从 2019 年底开始,天籁实验室一直有一支小分队研究这个事情,他们不仅自己琢磨,也在关注国内外学术界的进展。

遇到有戏的技术就做一个 Demo,发现走不通就回来,也没设定时间表。

但到了 2020 年,老师傅的思考节奏被猝不及防打断——疫情袭来。

你可能还记得,就是这年春天,腾讯会议突然蹿红,成为了大家办公上课的刚需。

当时老师傅们也顾不上新技术的研发,每天都在想着找资源扩容,寻思用什么姿势才能顶住下个周一更大的流量洪峰。。。

这段经历看似是支线任务,但现在回望,它给天籁实验室留下一个闪亮的精神遗产,那就是:

关键时刻,当几亿人迫切需要大规模传递信息时,他们会牺牲画面,而声音是最后的信息承载渠道。

此时,“以低带宽承载高质量的音频”就不再是一个锦上添花的“玩物”,而是支撑我们社会运转的“基石”之一。

把这个技术做出来,成了老师傅面对历史的责任!

疫情刚一稳定,天籁实验室就抽调出重要的同事,开始加码 AI Codec 的研发。

到了 2021 年,他们心里已经隐约勾勒出一种可行方案。但愣是没敢声张。。。

为啥呢?

当时天籁实验室已经推到了“无人区”。市面上没有别人的技术可供参考了。他们抱着这个自研方案站在那里,左右都没人跟上,多少带点胆儿秃。。。

就在这时,天籁团队偶然翻到了微软音频技术团队一个简短的分享。

文章只有区区几百字,根本看不出啥信息,但他们一下子跳起来了。在荒无人烟的原野,只要能瞄见另一个猎手的影子,他们就足以心安,自己追踪的方向对了!更何况看到的是一个公认的“好猎手”。

肖玮嗅到了猎物的味道。他建议投入重兵,拉上 AI Lab 的阳珊他们,赶紧开整!已经前后追踪了三年,可不能让其他猎人给打了去!

卖了这么大的关子,到底技术是咋实现的?

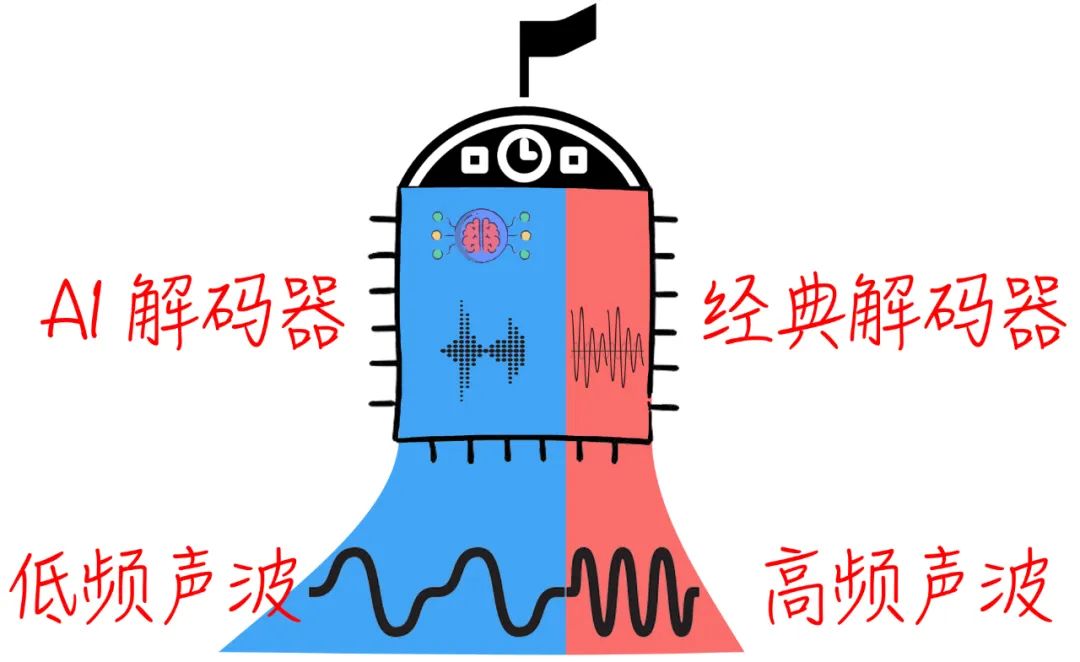

其实捅破窗户纸就很简单:这个方案把“经典信号处理技术”和“AI Codec”结合了起来。

既然纯粹用 AI 算力不够,那可不可以在所有频谱上,只划出一部分重要频谱交给 AI 模型处理,剩余的还交给经典技术处理?

这样模型的计算量就不会超纲,总体质量还能保证香香!

就像下面这样↓↓↓

你可能会说:就这?

话说,音频处理领域就像一个武林,各个门派还是有很深的成见的。AI 派看经典派是行走的古董,经典派笑话 AI 派拿锤子看什么都是钉子,两边经常隔空吵架。

但肖玮他们的意思是:最厉害的功夫,本来就不该有“门派”。

我是来做成这件事儿的,自然是哪招好用用哪招!黑猫白猫,抓到老师是好猫啊!

况且,即便“就这”,里面的学问还大着呢!

究竟把哪些频谱交给 AI ,把哪些频谱交给经典,才能让总体听感保持最佳呢?

对于语音信号来说,原则上低频声波携带的信息对听感影响更重,高频声波携带的信息对听感影响更轻,也就是说,要把 AI 尽量用在低频波段上。

经典信号处理,高低频的码率分配大概是 1:8。

用这种“AI+经典”杂糅的方案,高低频的码率分配大概是 1:2~1:3。

就像下面这样↓↓↓

嗯,纸上推演,似乎还不错!

老师傅着手实操,试着从频宽中间画了条线,然后分别处理,结果是。。。。不行!

虽然总体计算量确实是下去了,但听感也下去了,用这种方法压缩的音频在 6kbps 的码率下居然低于 4.0 分。

“不叫事儿”,老师傅安慰自己,以为调调就能过去。但谁承想,低码率下的听感像是被强力胶粘在了 3.x 分,无论怎么左冲右突,死活上不去 4.0。

调到最后,老师傅已经双目失神双耳失聪了。。。

苍天啊大地啊!明明技术其实已经突破了,但距离“腾讯级标准”就差那么一neinei,这也太窝火了。

但创新不就像打猎么?有时猎物就该在附近,猎手偏偏原地鬼打墙。此刻越急越找不到,冷静下来没准却能不期而遇。

那天夜里,万籁寂静。躺在在床上,肖玮突然睁开了眼,他仿佛听到了千军万马,正赶来支援。

(五)来自 40 年前的援军

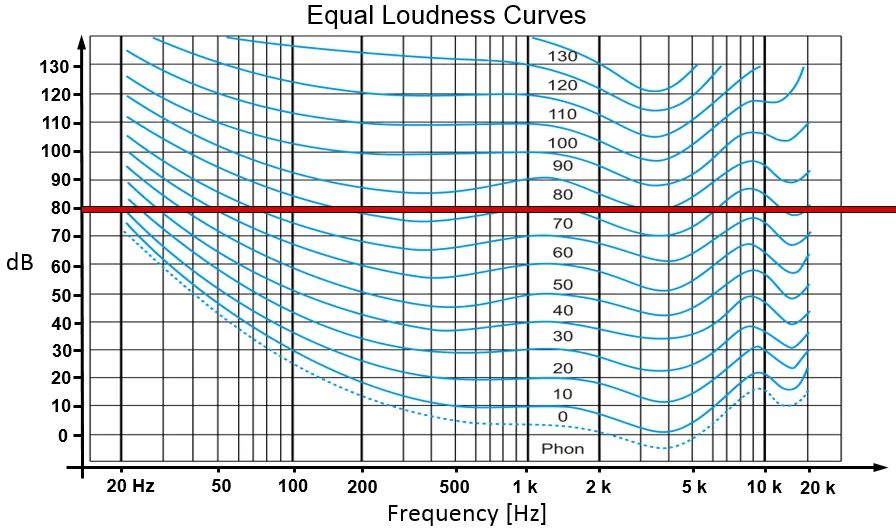

人的听力并非来自某种设计,而是漫长的自然演化中和环境互动不断进化的结果。

这是一个大家都明白,但又极易忽略的道理。

由于进化历史的复杂,在很多细节上,人的听力是“不讲武德”的,或者说,它背后的道理是不能那么容易讲清楚的。

比如在狩猎时代人们需要分辨鸟鸣,演化就调高了特定高频处的敏感度;比如有些频率是野兽吼叫的声音,会激发我们的杏仁核产生恐惧。

这就造成,人的听觉系统虽然整体上偏重某个频段,但演化又在这个大概的规律上持续给不同频谱调整“权重”——最终,人的听力不再是一个简单的直线,而是充满了难以解释的“小起伏”。

既然听力不是一个直线,那么你用一条直线去服务它,耳朵怎么会满意嘞?

这张图显示了:相同音量下,人耳对不同频率声音的感知度是不同的。

耳朵里的事情,需要巧取,不能硬来。

肖玮给我科普。

想明白这些,老师傅面前的问题就变成了:不同频段里,到底哪些细节对于听感而言是重要的呢?

这个问题,对码农来说其实超纲了。。。它应该由“生物学家”“医学家”或者“听觉科学家”来回答。

但直觉告诉肖玮,人类研究声学信号这么多年,自己不可能是第一个考虑这个问题的人,一定有前人做过研究。

于是老师傅们决定——翻论文!各种有关听力研究的,越精专越要啃,越艰深越不放过。

如山的论文,从 2021 年底看到了 2022 年初。

功夫不负苦心人,就在 2022 年春节前夕,他们居然找到了一篇上世纪 80 年代的论文,恰好研究了人耳在各个频谱上的细节特性。

踏破铁鞋,老师傅如获至宝,赶紧按照其中的结论来调整系统框架,重训模型。

春节一回来,模型还在迭代收敛中,就看到了评价系统的客观评分超过了 4.0,一般来说,这种情况下主观评分只会更高!

所有人的心脏都在突突地跳,这事儿成了!

果然,模型最终收敛,整个系统封装之后,可以在 6kbps 的情况下,让通话中听感保持在 4 分以上。生生把最低码率压到了原本极限的三分之一。

Penguins 编解码器诞生了!!

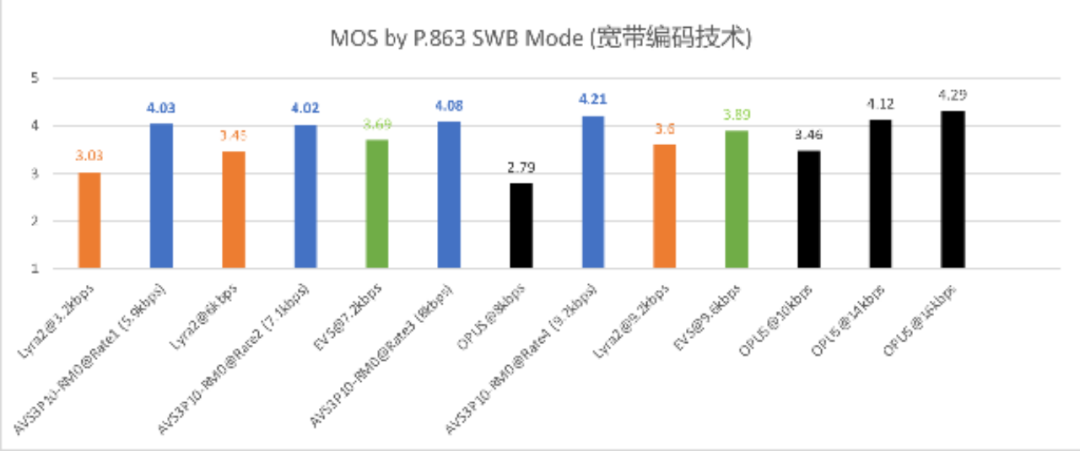

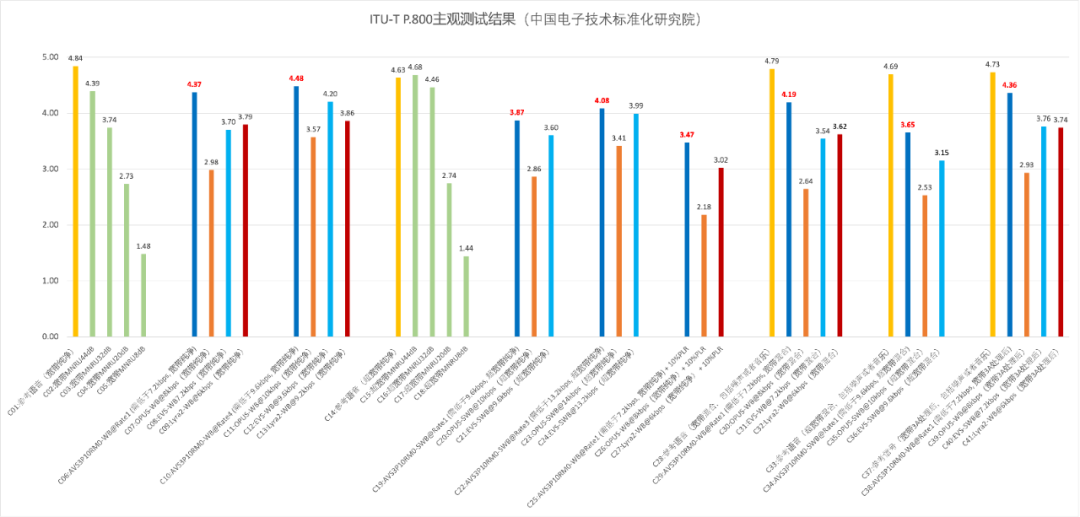

在音频信号处理界,有一个公认最难缠的客观质量测试标准,叫“ITU-T P.863”。

这个标准是由一众老牌声学家主导制定的,它关注的主要方向就是人的细节听感。

实际上,很多基于 AI Codec 的压缩方法在这个测试中得分都不高,所以他们经常心照不宣地跳过这个测试,反正外行也不懂。。。

天籁老师傅们点点头,咱就得用这个指标考验自己的成果!能够在这个客观测试标准中取得好成绩,大概率 Penguins 也能给出顶呱呱的主观通话质量。

果然,在这个测试中 Penguins 甩开对手老远——毕竟它的关键设计思路就是在细节处给耳朵“跪式服务”嘛!

这张图里,蓝色柱子是 Penguins 的得分,橘色柱子是同样采用了 AI Codec 技术的 Lyra2,可以看到 Penguins 表现全面领先。绿色和黑色柱子是基于传统信号处理的 EVS 和 OPUS,与这些传统信号处理方法的中高码率的质量相比,Penguins 也不逊色。

普通人也许很难想象,最终帮他们打胜仗的决定性援军,是来自 40 年前的一篇发黄的论文。

实话说,这篇论文的作者早已不再活跃,但他的研究成果却守候在永恒的历史岸边,横跨 40 年时空,把水中挣扎的素不相识的一群技术人拉上了岸。

他们相互对视,鞠躬致谢,然后挥手告别,这是一种无法言说的浪漫。

真正让老师傅觉得自豪的是:

这篇论文一直在那里,它像一扇门,谁都可以推开。但是天籁实验室最终想到去推这扇门,靠的并不是侥幸。

过去几年无数尝试碰壁后的经验,无数细小技术突破积累出的直觉,无数次因为责任而决定再试一次的发愿,都化成一级级台阶,最终指引老师傅走到了这扇门前。

正所谓世上没有白走的路,每一步都算数。

手握这个性能狂飙三倍的音频编解码标准,老师傅终于有勇气敲响产品团队的大门,这第一战,当然就是和自己关系最密切的腾讯会议!

(六)只有 6bps 的世界

在音频处理界有句俗话:

算法好不好,现网跑一跑。

这是因为在现实生活中,网络环境比实验室复杂千万倍。实验室里的数据再炸裂,都不能代表它实际就很好用。

天籁实验室的算法同学找到腾讯会议的产品同学时,腾讯会议的伙伴建议,先从带宽最低的“驾驶模式”和“弱网模式”入手。

现有的编解码器在 6kbps 下肯定卡,那就死马当活马医,把这部分的编解码器替换成 Penguins,反正不会更坏了。。。

在软件里替换掉编解码器已然工程量巨大,但这还只是万里长征的第一步,老师傅们必须对于各个车型、机型在各种实际网络工况下做实际测试。

这时,工程团队和测试团队就必须通力合作。

肖玮回忆一个搞笑的细节:2022 年他们开着自己的车在公司附近兜圈,就是为了找到哪儿信号只有 6kbps。。。

这不是在摸鱼旅游,是师傅们兜兜转转找弱网的地方时拍的。

“关键是信号还要稳定地差!有的地方测了两天之后,可能运营商也发现这里信号不行,给强行改好了,这就很尴尬。”他吐槽。

有时候为了找到一个弱网环境,老师傅开车兜一天,油钱都心疼。

除了寻找各种网络外,老师傅还要寻找各种手机。

因为他们必须确定:在各种机型、芯片、操作系统的组合下,尤其是在综合性能较差的手机里,编解码系统都能按预想的姿势干活。

“非要把所有机型都真实测一遍吗?这效率也太低了。”我问。

“就像瑞士手表,钟表匠测试手表质量,就必须让表真的转那么多天;就像汽车防撞、手机跌落测试,厂家真的就得去撞去摔。现实世界很复杂,在测试环节没有用虚拟替代现实的捷径。”高雄解释道。

就这样,各种弱网、弱机都被他们搞了一遍,确实发现了很多隐秘的小坑。

他给我举了一个“数据包”的小例子。

网络传输音频信号有点像寄快递,是一个数据包一个数据包传送的。

传统方案当然是给每一帧音频信息打一个包。

但是问题来了,每一个包外面还得有“包装”,包装上标注了这个数据包的基本信息,从哪来到哪去之类的,这就是“包头”。包头当然也占用一定的信息空间。

在新的编解码技术下,每一帧的有效数据量变成了原有的三分之一,这时包头的比重就变得很大,再这样一帧数据打一个包就不划算了!

于是老师傅们决定——把两帧打进一个数据包。

像这样的小改动还有很多,它们大多解决起来并不难,只是很琐碎。

“其实有多少黑科技,就有多少工程量。”负责工程化的文龙吐槽。

他用“短木板”理论打了个比方:

算法的革新带来的是体验的上界突破,肯定让人兴奋;但是工程底坐却是保证一切成功的前提。

没有一个王牌 App 是通过各种高精尖算法简单堆砌而成的,因为稍不注意,黑科技成了那块“短木板”了!

为了保证 Penguins 能够用起来,当时工程团队把客户端、服务后台等好多节点都从新打磨——几乎所有的重点处理链条都进行了针对性改造。

花了小半年时间,新的编解码器终于在腾讯会议里成功安家。

接下来,腾讯会议又逐渐切换,把原有编解解码器完全过渡到 Penguins 上,至此,从2019年就开始研究的技术,时隔漫长的三年,终于在第一个产品里实现了完整落地。

顾不上喘气,老师傅又盯上了下一个“猎物”,那就是 QQ。

QQ 研发团队的天成给我爆了一些“内幕”:

年轻人更喜欢用 QQ,而且他们使用 QQ 的姿势和我们这群老人用微信的姿势不同。

比如,年轻朋友之间,干啥都要连着麦干。哪怕各自刷网页,也要保持着通话状态。

甚至,情侣可能会“连麦陪睡”——俩人一宿不挂电话,听对方睡觉,或者打呼噜。。。

这已经不是“煲电话粥”了,简直是“吸电话氧”了呀!不理解,尊重吧。。。

长时间通话,网络环境肯定会经历各种变化,QQ 要想保证他们在任何时点都不被卡掉线,就更艰难。

关键是,年轻人比较“贫苦”,用的手机大都不高端,这进一步压缩了编解码器的运算资源。

这。。。不就是 Penguins 最好的用武之地吗?

于是在 2023 年,天成带领的 QQ 团队 也完成了编解码系统的改造,在只有 6kbps 的世界里完成了“荒野求生”!

到这一步,天籁实验室的师傅终于能腾出脑袋,思考那个“更辽阔”的问题:

既然技术飞跃这么大,而且已经在两大 App 上证明了自己,我们能不能去申请成为下一代语音通信的编解码标准呢?

凭借对标准的理解,老师傅们确信:在现有的标准体系里,AI Codec 标准妥妥是一片待开发的沃土。

尚世东调集算法、工程、质量等等团队,开始向中国的标准化组织——AVS——递交申请。

(七)成为榜样

说到音视频压缩传输标准,估计有的浅友觉得这是某种“荣誉称号”。

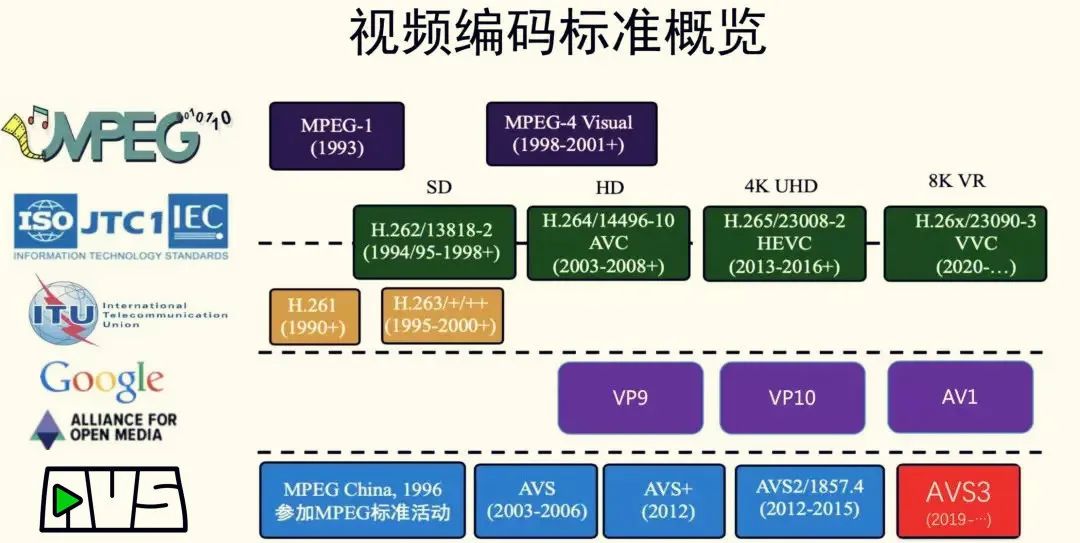

其实不然,从历史上看,音视频压缩标准一直是厂商甚至国家之间角力的战场。

就拿大家平时看片都会用到的视频压缩格式“MP4”和“MPEG”来说,它的音视频标准被称为“H.264”,背靠国际标准化组织(ISO)和国际电联(ITU)。很多国际公司,例如杜比、索尼、AT&T 等都参与了这个标准背后的研讨。

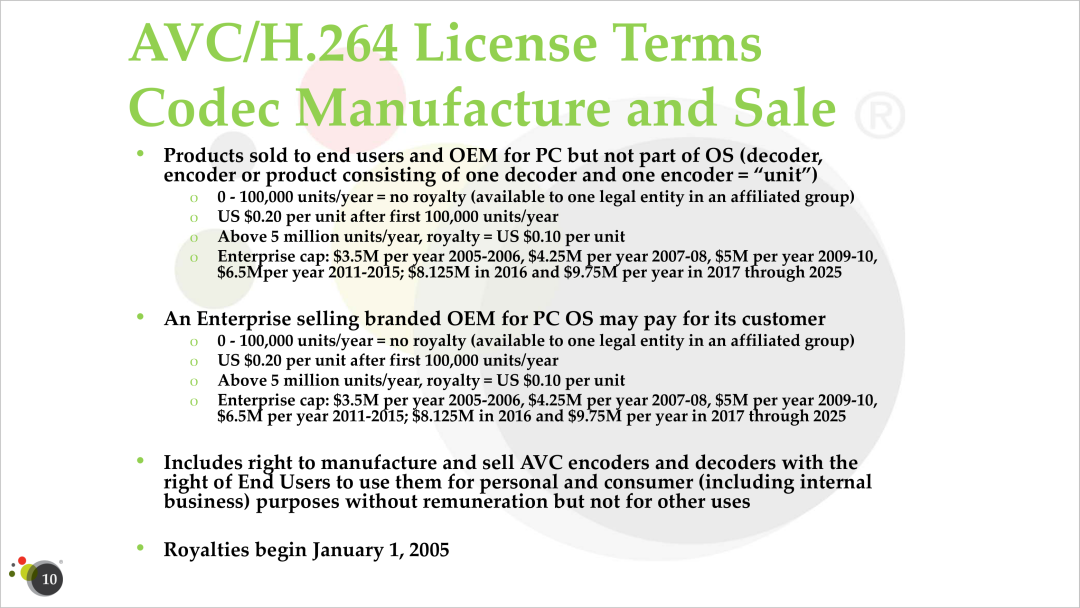

H.264 的授权协议

而这些公司可没有在做慈善,他们通过 ISO 和 ITU,对每一个使用这个标准的厂商都收一些费用。

这本来没什么问题,但要命的是,这些国外大公司尝到了甜头,争先恐后地参与制定下一代“H.265”标准,而且大幅提高收费。

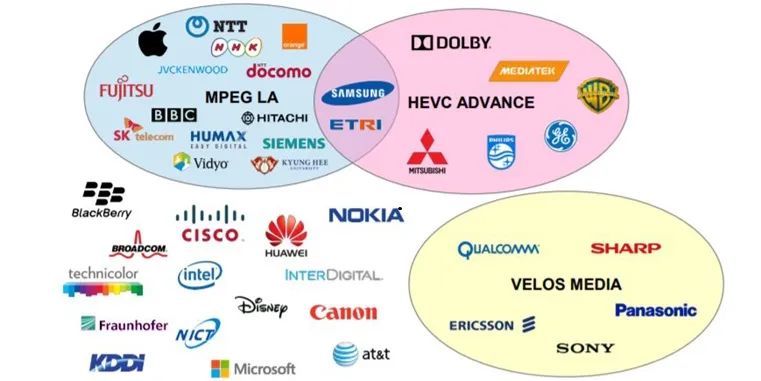

一台使用 H.265 设备要想不遭受专利诉讼,得在各个专利池里四处交钱,总共至少要掏 4 美元。。。

H.265 的“专利池”

碰到哪个都不行

这一下子超出了大家的承受范围,导致很多厂商根本做不下去了。

大致在这样的背景下,中国成立了数字音视频编解码技术标准工作组,也就是 AVS(Audio Video Coding Standard Workgroup of China),就是为了绕过这些国际大厂的专利壁垒。

由于 AVS 主要是为了国家层面技术自保,所以对于中国企业的专利收费是极其友好的,很多都是免费或象征性收费。

至 2024 年春天,AVS 已经经历了 AVS-1 和 AVS-2 两代,AVS-3 正在紧急编订中。

腾讯老师傅要冲击的,就是 AVS-3,确切地说是 AVS-3 中实时语音编解码技术的那部分。作为中国企业、中国技术人,这不仅是责任,也是荣光。

这是国际上的一些标准源流

但可想而知,既然是标准,制定流程是非常严肃的。这次,老师傅的搭档切换成了标准团队的专业咖,亚军。

亚军解释了 AVS 标准化的大概流程:

1、作为音频编解码标准的主导方,腾讯需要提出足够的论据证明标准立项的重要性,这叫需求评审。

2、AVS 标准组认可并立项后,会发出技术征集书。

3、AVS 工作组成员会提出各种候选技术提案,连带自测结果。

4、多次讨论迭代并通过第三方测试后,会慢慢形成稳定的标准文档和完整的参考代码。

5、最后把参考代码和技术征集书比对,如果指标全部满足,大家会表决通过,标准才最终诞生。

这里首先要过的难关,就是“技术征集书”。

标准之所以叫做标准,就是因为它不是一家之言。如果你的技术只适合腾讯家的产品,那肯定不行。

AVS 标准工作组会里有大学教授,有云计算厂商,有互联网厂商,还有手机等设备生产商。各位师傅都面临自己行业的实际情况,根据这些提出指标需求。

每次都是大型辩论现场,讨论达成一致后,才能最终输出技术征集书。

征集书像是个“英雄帖”,接下到了大家各显神通的时候,要拿出自己的“技术提案”来满足这些指标。

这个是各项细节指标,你感受一下(点击可以看大图)

肖玮把写送技术提案的工作比作“造炮弹”。

一旦开炮,炮弹离开炮筒,你就再没办法控制了。所以你不能放过自己,必须保证把炮弹造到最硬,再打出去。

老师傅先在自己的模拟环境里反复摩擦,又在腾讯会议和 QQ 实战环境中反复打磨,磨到不能再磨,磨秃噜皮,终于在 2023 年底整体提交。

这一炮打响了!提案通过了 AVS 组织严格测试,成为了稳定的“标准基线版本”。

这意味着:后续的迭代,都会在腾讯的“参考代码”上微调。

微调的工作一点儿都不轻松。

标准文档堪比学术论文,就连平时大家不太注意的每一章概述部分都要字斟句酌,甚至因为一个标点符号要用分号还是逗号,大家都会争执。

虽然极端繁琐,但亚军知道这种争论是有意义的。

因为标准一旦形成,它就会被成千上万厂商采用、执行。每个标点都必须经得起历史的考验。

到了 2024 年6月,满足技术征集书的标准交付件终于成型,很快大家就进入表决环节,各家企业代表此刻一致通过,这个新的音频编解码标准呱呱坠地,它就是——AVS3P10。

掌声热烈而漫长。

从 2019 年起心动念,到2022年落地实战,到 2024 年成为 AVS 标准,这条路腾讯老师傅们走了五年。

“其实在业内,一般都是五年做标准,五年做推广,总共要十年。我们的标准快了一倍,已经算非常顺利了!”肖玮说。

虽然不会把比较作为目的,但天籁实验室还是会积极关注国际上的同类技术进展。

事实上,国际上其他标准组织也在进行类似的工作。

但从目前进展和完成的情况,AVS3P10 为代表的中国标准不仅在标准进度上做到领先,在很多指标上也是领先的。

肖玮的话虽然克制,但难掩骄傲。

他值得骄傲。

从专利自保,到分庭抗礼,到自主创新达到国际顶尖,中国技术人用二十几年的时光,穿越了前车卷起的漫天黄尘,闯出了自己的天地澄澈。

图片来自《飞驰人生2》

(八)漫长岁月里的款款声波

“手艺”是个古早的词汇,它是工匠手里的刻刀,也是电流中奔腾的代码。

过去几年,天籁实验室这群师傅的手艺不仅撑住了腾讯会议真实的 4 亿用户,还炼成了惠及 14 亿人的技术标准,堪称“爽文”典范。

但我却愿意提示其中“克制”的力量。

技术人最容易犯的错误,是笃信某种技术。

2016 年 AI Codec 横空出世,如核爆一样在技术圈炸开,让传统的音频编解码黯然失色;它太优雅,就像电动汽车一样,用几台电机和一盘电池就能替代过去上万个零件组成的燃油机械。

于是,很多年轻的师傅激进地转向“纯 AI 派”,他们的理由很充分:具有底层先进性的 AI 模型定能江山一统,实现“技术革命”。

但大多数时候,决定“做什么”是简单的,但决定“不做什么”却要依靠经验、智慧以及强大的自制力,是更难的。

正如保守主义哲学家家埃德蒙·伯克所说:“先例是人类的学府,具有包容一切的气度和改善一切的才能,才是真正的改革家。”

如此看来,天籁实验室的老师傅至少做对了两件事:

第一,等待良机:在看清技术路线之前,宁可保存实力,也不盲目在新技术上扑入重兵。

第二,尊重先例:在 AI Codec 烈火烹油的时候,依然对传统音频编解码技术敞开大门。

事实证明,越是技术突飞猛进的时代,越需要有老师傅抱持这种看似冰冷,实则温热的“保守主义”态度。

回看中国的音视频编解码技术走过的道路,也是如此。

肖玮回忆起十几年前自己初次参加国际标准讨论的情景:

当时他感觉到巨大的反差。其他国家的代表团都是连鬓络腮白胡子,一看就是干了多半辈子的老法师;再看中国代表团,清一色都是二十来岁的毛头小伙子、小姑娘。

一个国外老哥专门走过来问肖玮:“How old are you?”

外国老哥解释,在他们国家,必须是在行业里摸爬滚打二十年以上的技术人,才有资格参与这种规格的标准讨论。

肖玮有点儿不好意思:在我们国家,二十年前整个行业才刚刚起步。。。

不过从那以后,就是这些小伙子小姑娘,一直在代表中国出席各种国际讨论,他们为全世界的音视频技术添砖加瓦,积沙成塔,以手中的代码而非年龄赢得世界的尊重。

如今他们虽还没夸张到白胡子的年级,但确实都已更加成熟。而在他们身后,正站着更多年轻的中国技术人。

一代代人,就这样前行,不疾亦不徐。俯瞰他们的脚印,是漫长的岁月里一串声波。

而我们的历史,也在这样的声音里,滚滚向前。

你还可以看:

👉当 AI 活成了你的样子,而你活成了狗

👉他们在“耳机”里和生活决斗

👉我在腾讯造“炮弹”

👉腾讯在命运的棋盘上砸下一颗钉子

👉我遇到一群靠“造梦”改变世界的人

👉人类抖M计划:如何造出一个会反叛的机器人?

👉2023:当我们都活成了“大模型”

👉把“中国制造”的云计算卖给外国人是一种怎样的体验?

间关莺语花底滑

幽咽泉流冰下难

再自我介绍一下吧。我叫史中,是一个倾心故事的科技记者。我的日常是和各路大神聊天。如果想和我做朋友,可以搜索微信:shizhongmax。

哦对了,如果喜欢文章,请别吝惜你的“在看”或“分享”。让有趣的灵魂有机会相遇,会是一件很美好的事情。

Thx with

免责声明:上述内容仅代表发帖人个人观点,不构成本平台的任何投资建议。