芯片行业与AI计算:定制化还是通用设计?

芯片行业与人工智能(AI)领域正沿着两条看似背道而驰的道路前进。芯片设计趋向于特定领域的优化,而AI则展现出惊人的多变性和泛用性。

这种分裂不仅揭示了硬件和软件发展的不同步,也预示着未来芯片与系统架构的重大变革。从ChatGPT掀起全球浪潮以来,仅仅18个月,软件初创企业如雨后春笋般涌现,探索着新的架构和技术。

然而,一块定制芯片从设计到量产通常需要超过18个月的时间。这种时间差凸显了软件与硬件迭代速度的不对等,尤其在AI领域,硬件可能在大规模生产时就已经落后于最新的软件需求。

Part 1

定制与通用的拉锯战

随着AI应用的多样化,定制硬件面临着首次运行失败的风险增加,因为硬件的固化特性难以跟上软件的快速进化。然而,这并非意味着定制硅片的末日。

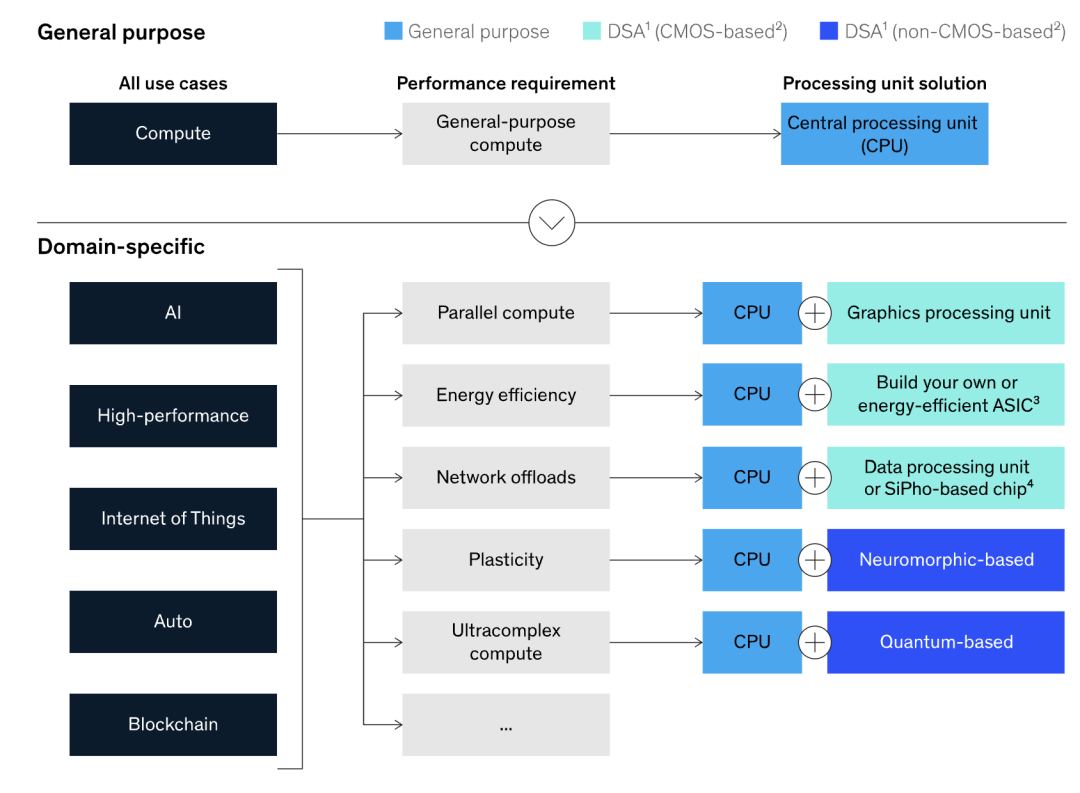

数据中心正在部署越来越多的处理架构,每种架构在特定任务上都比单一通用CPU表现更佳。特定领域AI芯片的挑战在于如何高效地将软件映射到异构处理器阵列上,而这正是行业尚未攻克的难题。

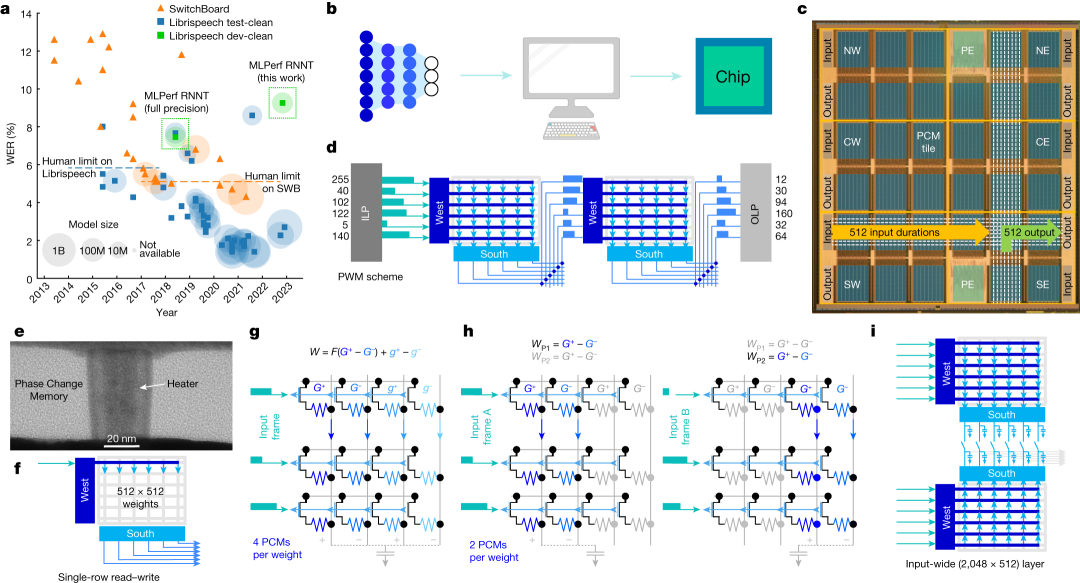

AI的兴起得益于GPU的强大处理能力,但GPU的领导地位也带来了阻力。虽然GPU在处理重复数学运算方面难以超越,但其通用性限制了针对特定应用的极致优化。面对AI算法的快速迭代,设计通用加速器的公司必须不断预测未来,而定制实现可能在短期内保持领先地位,直到新的定制实现出现。

硬件实现需要在通用性和特定性之间找到平衡。随着AI模型的参数量和操作需求不断增加,专用硬件单元成为了必要选择。尽管通用设备数量不足,但小芯片的出现可能缓解计算能力的短缺,通过混合和匹配不同处理引擎来完成特定任务。超高速、低功耗硅片与更多通用芯片或小芯片之间平衡的架构需求。在 AI 领域,对通用和可编程性的强烈需求与对定制硬件高效性的追求相互碰撞。

如何高效地将软件映射到异构处理器阵列上成为了关键挑战,目前业界尚未完全掌握这一技术。共存的处理器架构越多,映射问题就越复杂。

Part 2

多个市场,多个权衡

AI 的发展得益于 GPU 的处理能力,其图形处理功能与 AI 核心部分所需功能的相似性,以及相应软件工具链的创建,使得 NVIDIA GPU 成为最易定位的处理器。

然而,成为通用加速器的领导者并非一帆风顺,需要考虑面向未来的问题。若只是为特定应用构建硬件,则无需过多考虑未来的通用性,但这也可能导致 18 个月后出现新算法时硬件的落后。特异性也可以分层构建,通过硬件抽象层以标准化方式向软件公开,使得应用程序的特异性上升到更高的层次。

硬件实现需要权衡诸多因素,尤其是在 AI 领域,工作量不断发展变化,现有的架构面临诸多质疑。通用设备数量往往不足以满足需求,这促使行业寻求更高效的硬件解决方案。小芯片的出现或许能缓解这一问题,随着小芯片封装成本的降低,其应用范围有望从数据中心扩展到更广泛的市场。

AI的快速发展对芯片设计提出了前所未有的挑战。在训练和推理场景中,定制芯片与通用芯片之间的选择取决于具体的应用场景和市场。对于边缘设备,低功耗和高性能成为关键考量,而定制芯片能够提供最优解。AI和RISC-V的交集展示了特定领域计算与通用计算的共存。

随着技术的演进,特定领域的设计可能变得更加普遍,但也可能遵循历史模式,先经历定制化,随后转向低成本通用组件。在设计前沿,定制硬件提供了竞争优势,但高昂的成本和漫长的开发周期使得市场机会有时被浪费。

随着摩尔定律的放缓,定制解决方案可能成为新的赢家,但公司必须紧跟最新技术节点,否则通用处理器的自动进步将失去保障。

小结

技术问题将决定定制与通用设计之间的平衡点。随着功耗极限的到来,定制化成为必然趋势,但灵活性、可扩展性和市场适用性之间的矛盾依然存在。在芯片行业与AI计算的分裂中,寻找合适的平衡将决定未来芯片和系统架构的走向。

免责声明:上述内容仅代表发帖人个人观点,不构成本平台的任何投资建议。