英伟达和博通要掀两条路线之争?

6月份“国会山股神”佩洛西老太太披露购进了一批新股票,包括分别为价值500万美元的英伟达股票和博通的看涨期权。

博通(Broacom)业务条线涉及到AI数据中心的多个重要环节,博通的华人CEO陈福阳最擅长的事情是通过大胆收购,强力整合业务,被公认为全球运营能力最强的公司之一。

我于6月26日写过博通的文章《英伟达之外,获封“AI三骑士”的是这两家(下)》,简单分析了博通业务中最有增长潜力的两个部分,其中一个是定制芯片。欢迎大家有空阅读。

接着定制芯片的话题,这里我部分编译了作者Tech Fund的“The AI datacenter, Nvidia's integrated AI factory vs Broadcom's open fabric”,可以帮助大家了解定制芯片的情况。由于原文相当长而且有偏技术层面的大量介绍,我这里只是非常有限的节选,翻译粗陋之处望谅。英伟达和博通不久前对AI数据中心的未来提出了相反的观点,有点类似于当年微软和苹果代表了开放和封闭两种对立模式一样。

英伟达的做法是让客户在英伟达垂直集成的系统上运行所有AI工作负载,英伟达的系统包括从GPU到服务器到网络,再到英伟达的软件堆栈,全套的软硬件系统都是英伟达的。英伟达多年来一直是在努力构建这个软硬件生态系统。最著名的是CUDA计算平台,使通用编程语言C和C++在任何英伟达的GPU上执行任务,从而不再需要繁琐的图形编程技术。

此外,AI工程师还可以访问各种软件库,便于在英伟达GPU上部署和扩展工作负载。例如现在可以在英伟达GPU上使用Python pandas工具进行数据处理。英伟达还提供TensorRT-LLM和Triton Server等推理库,在英伟达GPU上部署经过训练的AI模型。这些AI模型可以使用Pytorch和Tensorflow等流行的开源学习库进行开发。

人们逐渐形成固定认知,认为AI编码只能在CUDA中进行,英伟达通过强大的软件为公司建立了护城河。

然而事实上并非如此。所有AI代码都是用Pytorch编写,它可以在CUDA、CPU上运行,现在也越来越多地在AMD的ROCm GPU计算平台上运行。如果想在另一个GPU上运行Pytorch模型,可以使用制造商提供的编译器,或者自己编写编译器。Pytorch和Hugging Face(即分享AI模型的社区)都非常积极地扩展对ROCm和其他GPU计算平台的支持,因为他们不希望AI的未来由单个制造商控制。

那么,既然也可以在AMD的GPU上运行Pytorch模型,为什么人们仍然抢着购买英伟达的GPU呢?主要是英伟达GPU在运行工作负载方面能力要强得多。此外由于LLM必须部署在多个GPU上,英伟达同时拥有的网络硬件和软件库优势,可以使用户在训练和推理中轻松工作。

对AI数据中心的未来,两个相反的理念

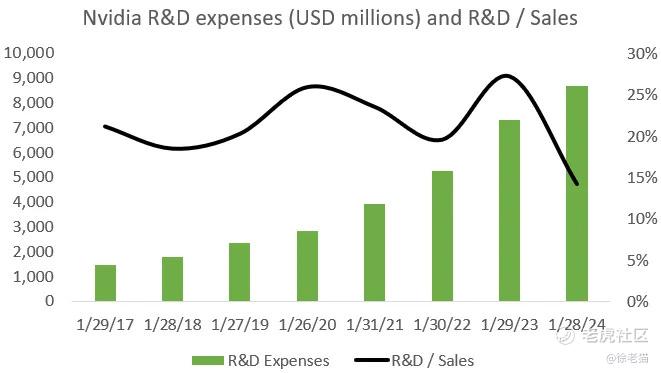

从长远来看,光是CUDA不足以成为英伟达保持竞争优势的护城河。英伟达真正在努力打造的是AI生态系统的快速创新,无论软硬件。英伟达目前每年投入80亿美元用于研发,很少有竞争对手能够同时拥有庞大的研发资金以及所需的人才、技术和专业知识。这是英伟达一览众山小的主要原因。下图:英伟达的R&D逐年提升。

我们假设英伟达的创新步伐放缓(实际上相反),竞争对手很容易缩小差距。例如如果LLM架构的演进变得可预测,大型云企业将有可能占上风,它们可以提供定制芯片来解决这些工作负载。同样,如果摩尔定律和其他关键技术速度放缓,竞争对手和大型云企业可以更轻松地构建由竞争性的软硬件生态系统。

英伟达的一条主要护城河是它正在渗透到AI训练的核心,其Omniverse软件平台为AI训练提供了完善的虚拟环境。这对于强化学习类型的任务特别有用,例如梅赛德斯一直在用Omniverse训练自动驾驶系统。因此,你可以将最新的Transformer深度学习技术集成到模型中,然后通过Omniverse环境的强化学习进一步改进。Robotaxi和人形机器人都可能在十年左右的时间内成为庞大的市场。这两项技术中,英伟达提供了GPU平台,也提供了虚拟训练环境,因此我们可以预期英伟达在这个价值链中会发挥很重要的作用。

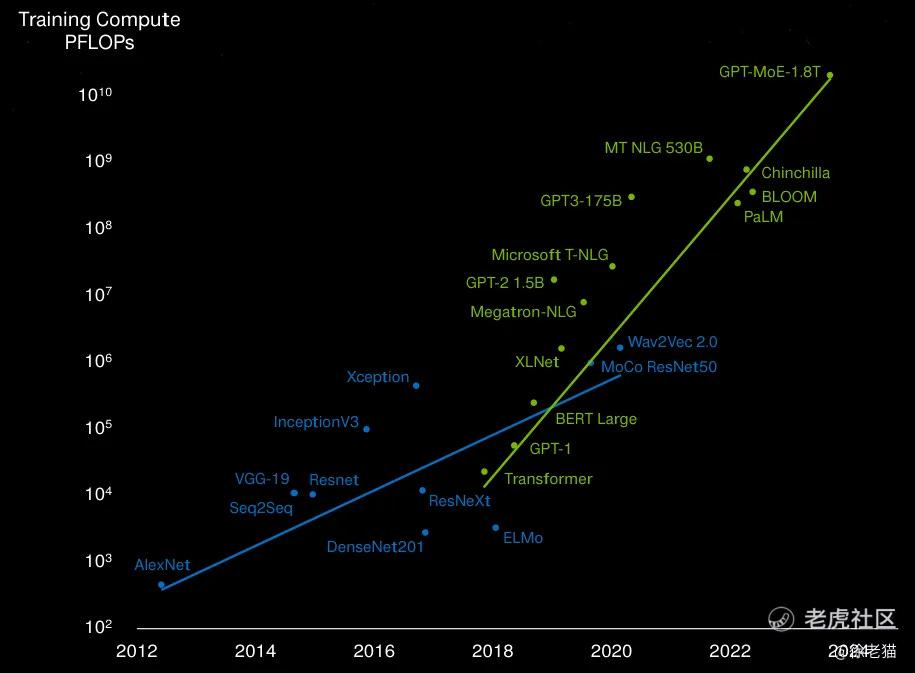

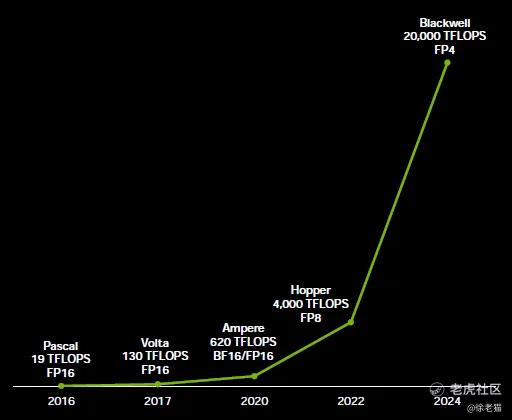

对于AI数据中心的未来,博通则提出了相反的理念。博通并没有将软硬件进行垂直集成,而是预见到一个即插即用的世界。在这个AI数据中心,不同制造商的组件可以随意交换进出,从GPU到CPU、NIC和交换机,并通过开放标准的以太网进行通信,AI计算将在较低功耗的定制芯片(ASIC)上运行,而不是英伟达较高功耗的GPU。由于训练计算量以每两年100倍的速度增长(见下图,注意对数刻度),电源效率的争论非常重要。

英伟达更多地采用了类似苹果的方法,即硬核工程与垂直整合相结合,以提供最佳的客户体验。而博通更多地看到了AI类似于Windows PC的前景,即任何制造商的硬件上都可以运行的软件平台。苹果的垂直整合和微软的专业分工(即价值链中每个参与者都专注于各自的专长),两种模式很难说谁输谁赢,各自有一定的优势。

博通“即插即用”的开放理念

博通对外甚至不再使用GPU这个英伟达带来的名称,而是阐述了自己的定制芯片概念:“人工智能加速器,很多人称为GPU,或TPU和NPU。我们称为XPU。开发这些产品有两种方法。第一,你可以开发一款适合每个人需求的通用产品。然而如果你是一家消费端AI公司,正在构建大模型,那么这些通用处理器功耗过大,部署到网络中的成本也太高。很多人今天别无选择,因为他们没有能力根据需求定制化。但少数拥有数十亿用户规模、创造超过5万亿美元收入的公司具备这种能力。这就是我们创造定制AI加速器的原因。”

博通的XPU业务现在有三个大客户,谷歌是第一家,可能微软是第二家,最近有人猜测Meta或字节跳动是第三家。亚马逊则与博通的竞争对手Marvell合作。设计领先的XPU是一项研发密集型的工作,成本高达数十亿美元。英伟达花了100亿美元来开发整个Blackwell平台,需要大量的专业知识和技能,进入门槛很高。博通和Marvell在这项业务中面临的主要风险是互联网和云巨头未来会更多地自己做研发,类似于苹果自己设计芯片。苹果已经展示了定制芯片如何为他们带来性能优势。

数据中心将不得不过渡到定制芯片?

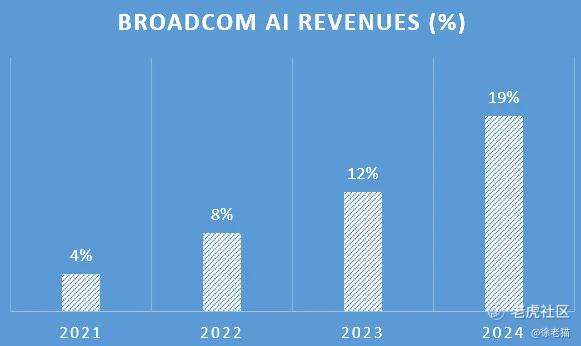

由于博通还拥有强大的网络和连接等数据中心业务,今年博通AI数据中心的收入已占19%。

这是博通COO阐述的AI巨大前景,他们正在与客户探讨如何构建100万个XPU的集群:

“如果我们回到2年前,当时最先进的集群有4,096个XPU,每个XPU的功率为几百瓦,将4,000个互连起来也相当简单,用我们的战斧交换机做一个单层网络即可。2023年,我们构建了一个超过10,000个XPU节点的集群,需要2层战斧或Jericho交换机。这是当今业界功耗最低的XPU,不到600瓦,并且采用了最新技术。现在2024年,我们将扩大到30,000多个,而许多消费端AI客户的目标是将数字扩大到100万。”

由于数据中心的功率限制,博通认为AI加速器将不得不过渡到定制芯片。这些针对特定AI工作负载进行了优化,从而降低了功耗和尺寸要求。从投资角度来看,另一个重要因素显然是涉及大量网络和连接技术,从交换机到 PCIe,这又是博通擅长的领域。

让我们了解一下定制芯片业务的缘起,这是博通ASIC负责人的介绍:

“2014年,我们遇到了一位客户,他决定在人工智能领域做一些非常酷的事情,我们为他们开发了一款AI芯片。我们开始转移资源并专注于AI。定制芯片的好处可以用一个简单的方程式来解释:性能除以总拥有成本。总拥有成本是芯片的成本,加上电的成本,再加上将其组合在一起的基础设施成本。当你是一家大型互联网公司时,内部工作负载对于营收非常重要。因此,如果你定制加速器的架构、带宽、正确的I/O比率和正确的内存比率,你就可以比在通用硬件上更有效地完成这些特定工作负载。我们与客户合作将现有的架构定制化,确保能够最大限度提高性能。还有另一个非常好的效果,那就是当你优化硬件时,你可以让它变得更小并且更便宜。另一个好处是,当你优化电源时,你就优化了电力成本。”

博通为互联网巨头设计的AI加速器显然都是非常先进的芯片,芯片尺寸很大,一个芯片中包含多达1100亿个晶体管,2.5D连接128GB的HBM,6TB的网络带宽。基本上它与英伟达的旗舰H100 GPU是类似的。

这块业务一直保持着20%的复合年增长率。然而针对一种工作负载进行优化,是优点也是缺点。英伟达之所以在AI工作负载方面拥有超过80%的市场份额,是因为他们的GPU不仅自身表现出色,而且能够用在广泛的工作负载上。只要AI领域不断快速发展,简单地安装英伟达集群就更有意义。不仅可以更轻松地在此集群上部署所有AI代码,而且随着工作负载不断发展,可以更好地适应未来。

英伟达的整合AI平台

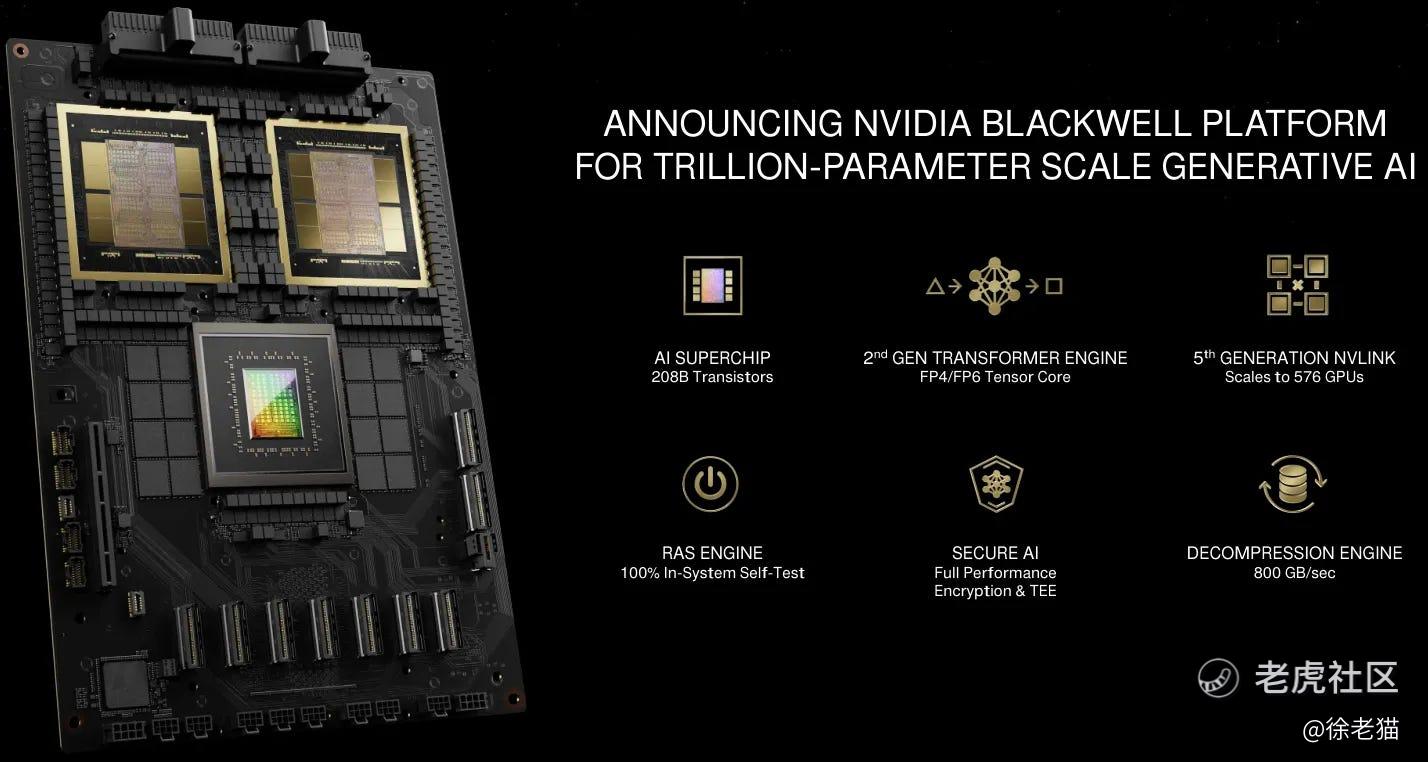

英特尔是无可争议的AI之王,垂直整合的英伟达平台为所有AI工作负载提供动力。我们很难押注英伟达未来几年会轻易将AI市场份额拱手相让,这种情况应该不会马上发生。虽然AMD将占据一些份额,今年可能约占5%到10%,非常有限的份额,而且主要还是由于英伟达解决方案来不及供应。今年底Blackwell将会发布,所以如果你买到这款GPU,那么之后很可能没有动力去购买AMD MI300。

不用说,Blackwell平台是一个计算巨兽,单个超级芯片上有2080亿个晶体管,576个超级芯片通过NVlink互连在一起,有效形成一个极低延迟的巨型GPU。最有趣的功能是,与之前的8位版本相比,最新版本的GPU支持4位浮点计算。意味着AI计算中的每个实数只需要4位,芯片内存容量增加一倍,速度也提高一倍。这个功能主要用于推理,因为4位在这里已经足够精确了。

下图说明了英伟达超级芯片的计算能力是如何发展的。基本上每两年计算能力就会提高约5-10倍。

黄仁勋这样介绍新的DGX Blackwell:

“我向OpenAI交付了第一个DGX-1,它的运算速度为170teraflops,即0.17petaflops。现在的速度为720个petaflops,几乎是用于训练的一个exaflop机器,也是世界上第一台在一个机架中一个exaflop的机器。地球上只有几台2、3个exaflops的机器,因此这是一个单一机架中的exaflops人工智能系统。看看它的背面,DGX NVLink主干,每秒130TB的数据通过该机箱的背面。这超过了互联网的总带宽,因此我们基本上可以在一秒钟内将所有内容发送给每个人。共有5,000根NVLink电缆,总共两英里。如果我们必须使用光学器件,我们就必须使用收发器和重定时器,而仅这些收发器和重定时器就需要花费20,000瓦。因此我们通过NVLink Switch完全免费地做到了这一点。整个机架有120千瓦,所以20千瓦就产生了巨大的差异。它是液体冷却的,进入的温度是25摄氏度,大约是室温,出来的温度是45摄氏度,大约是按摩浴缸的温度。当有人说GPU时,我看到的是这个。我们的GPU现在有600,000个零件和3,000磅。”

黄仁勋随后介绍了平台的训练时间和功率要求:

“如果要训练一个1.8万亿个参数的模型,使用25,000个Ampere版GPU大约需要3-5个月左右的时间。如果我们用Hopper来做这件事,可能需要8,000个GPU,并且在90天内消耗15兆瓦。如果使用Blackwell,在相同的90天内只需要2,000个GPU,仅需要4兆瓦的功率。这就是我们的目标,不断降低成本和能源。”

软件可能成为千亿美元市场

未来自动驾驶软件很可能会成为一个千亿美元的市场,所以能够成功占领这个市场的公司,其估值将可以另外增加万亿美元。这是一个绝对值得观察的空间。

更令人兴奋的领域是Robotaxi市场,Robotaxi会占全球行驶里程15%的份额,将为系统提供商如英伟达和Mobileye带来近万亿美元的收入。

英伟达并不纯粹专注于AI数据中心的加速和推理,从长远来看,他们希望涉足自动驾驶系统、无人驾驶汽车和人形机器人等潜在的大市场。

免责声明:上述内容仅代表发帖人个人观点,不构成本平台的任何投资建议。

学习了,感谢分享

。

这篇文章不错,转发给大家看看