蔚来智驾的大模型之路:自研芯片 + 世界模型 + 群体智能

作者 |德新

编辑 |王博

7月27日上周末,蔚来举办第二届NIO IN。

李斌说,2023年的第一届NIO IN像是一个大纲,第一次对外完整展示了蔚来布局的12大技术领域。

而这届,更像第一个交付的章节。它重点展示了5项阶段性的进展:

自研智驾芯片神玑NX9031流片成功;

整车操作系统天枢SkyOS全量上线;

Banyan3.0今年将上线,推出多个NOMI智能体;

智驾世界模型NWM,将在四季度开始推进量产工作;

二代NIO Phone发布。

在蔚来第二、第三品牌车型上市前,蔚来多年投入的自研,终于开始逐渐显现出一些成果。

其中,在智能驾驶领域,从模块化的智驾方案,向端到端大模型的切换成为今年最重要的技术风潮。未来一周内,小鹏、理想等都将公布各自在端到端智驾上的进展,蔚来率先出牌。

蔚来CEO李斌、蔚来智能驾驶研发副总裁任少卿,向我们完整阐述了蔚来在智驾上做端到端的思考。

总地来说,自研芯片加上世界模型,再加上群体智能,是蔚来智驾大模型的核心框架。

一、蔚来自研大算力智驾芯片,神玑NX9031

开场不久,李斌就从兜里掏出已经流片回的神玑NX9031,现场掌声不断。

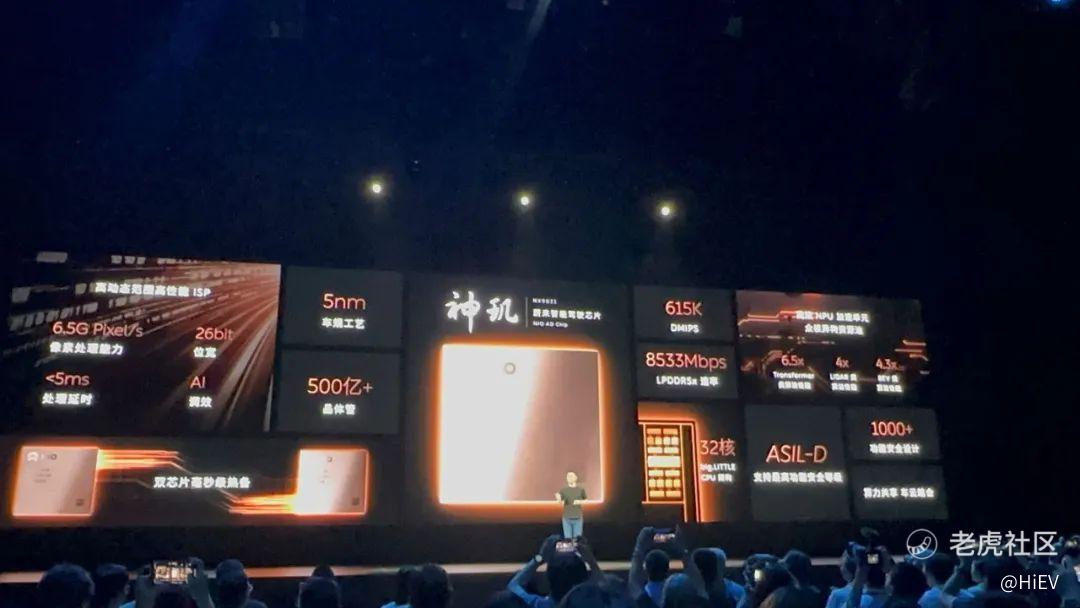

蔚来称,这是「全球首颗车规5nm高性能智驾芯片」。

实际上,神玑NX9031几个月前已经流片回来,团队测试下来,「效果比预期的还要好」。

蔚来此前曾经提到神玑NX9031的定位是「一颗顶4颗(OrinX)」。这次,他们公布了更多9031的参数特征:

32核CPU,采用big.LITTLE大小核架构,CPU算力达到615K DMIPS;

NPU加速单元,Transformer类算法性能提升6.5倍,LiDAR类算法性能提升4倍,BEV类算法性能提升4.3倍;

ISP最高可达6.5G Pixel每秒的图像处理能力;

算力共享、车云结合。

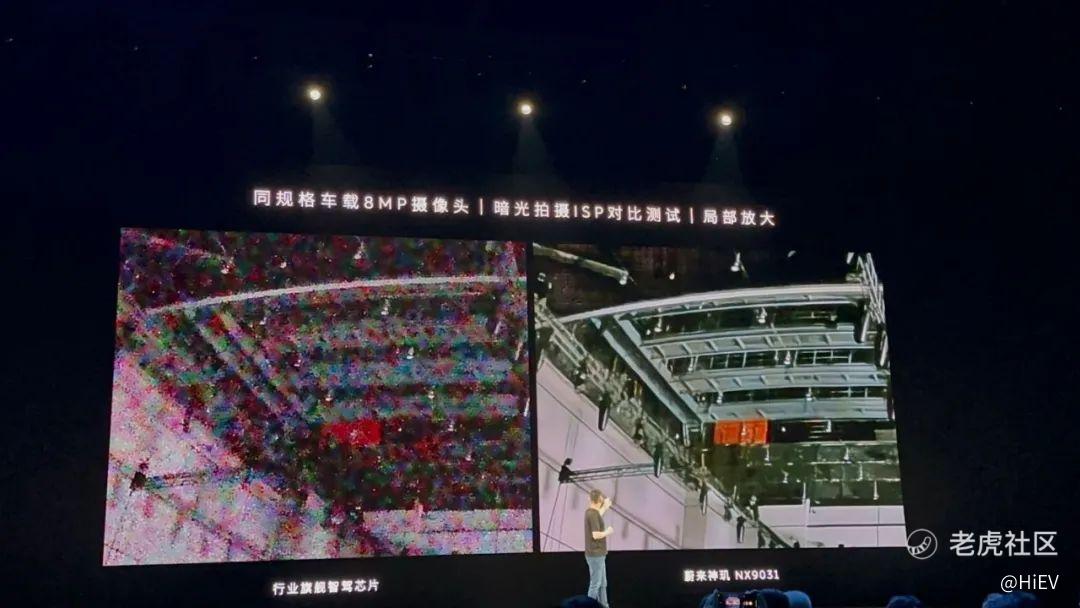

现场,蔚来还「小试牛刀」,展示了一下神玑上自研ISP在恶劣光线条件下的处理能力。

9031上ISP的高处理位宽配合降噪算法,能提供很高的动态处理范围,从而使暗光下图像细节更丰富,更容易看清几百米外的标识、细小物体。

现场实拍的神玑NX9031和行业旗舰智驾芯片的图像处理对比,基于8百万像素摄像头

蔚来提到的「一颗顶四颗」,是指从AI算力和ISP等主要指标上,至少有4倍以上的性能提升。

目前已经官宣的第一款搭载神玑NX9031的车型将是ET9,ET9将在明年交付。

不过,李斌也提到,「(芯片)它的作用,要明年的一季度才可以发挥出来。即使芯片上车了,依托于新的架构体验要落地也是需要时间,期望值要管理好。」

这可能也意味着,在NT3这代平台上,蔚来自研的神玑和第三方的计算芯片可能要并行一段时间,实现平滑过渡。

二、NWM世界模型,让智驾系统学会想象

神玑NX9031是蔚来内部的芯片团队与智驾团队花费了几年时间联合定义的。它很重要的一项特性,就是为世界模型原生打造。

世界模型是蔚来智驾研发的下一个主要方向。

蔚来认为,一个足够聪明的智能体,应当具备想象重建(空间理解)和想象推演(时间理解)的能力,而端到端的模型,不必然具备这两个核心能力。

因此智驾有端到端的模型还不够,核心是搭建世界模型。

蔚来世界模型(NIO World Model,简称NWM),去年已经开始规划,但当时的NIO IN还不太成熟。

目前,NWM具有生成2分钟长度视频的能力,这已经超过了目前业界大部分AIGC视频生成软件。

2分钟的视频长度,可以用来预测未来2分钟内将发生的驾驶场景;在轨迹规划方面,MWM目前每0.1秒能生成216种可能的轨迹,而每0.1秒后再根据环境动态重新生成216种轨迹,让系统选出最佳的驾驶策略。

李斌说,NWM这几个月的进展非常快,是「跃迁式的,几个月前还只能生成几十秒」。2分钟意味着即使开得很慢(30公里/小时),也可以覆盖到未来1公里将发生的各种驾驶情况。

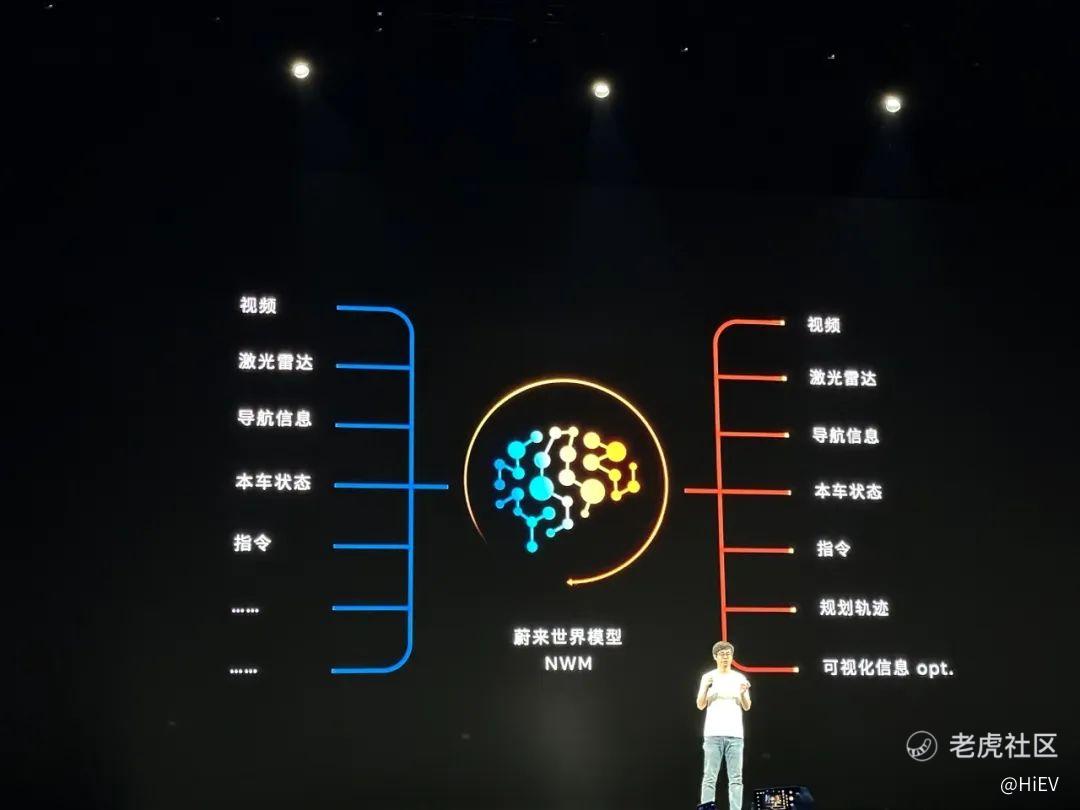

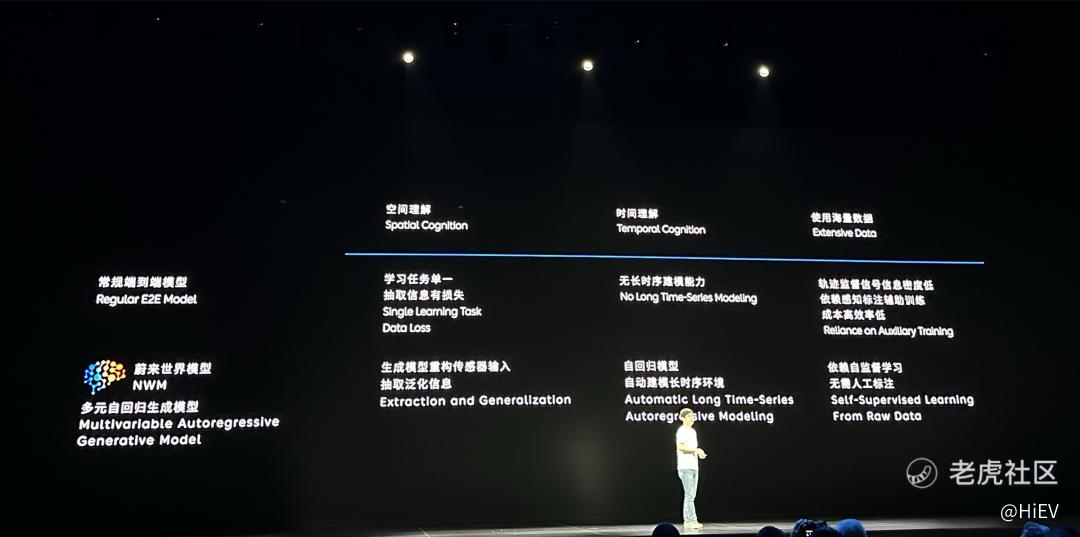

NWM是一种多元自回归生成模型。少卿总结,NWM和常见的端到端模型的差别包括:

空间理解能力,NWM通过生成模型重构传感器输入泛化信息,而端到端模型学习任务单一、抽取信息有损失;

时间理解能力,NWM自回归模型自动建模长时序环境,后者则没有长时序建模能力;

数据要求,NWM使用无标注的数据进行自监督学习,后者依赖轨迹信号信息密度低、感知标注辅助训练,成本高而效率低。

但训练一个理想的世界模型,挑战也很大:需要千万级Clips以上的真实数据训练、数据要丰富,想象重建的时间轴要连贯,其他还有大量的工程工作。

蔚来接下来的工作,是将NWM实现车端的部署。少卿透露,今年Q4会有机会「给大家一些体验」。

与NWM配套,蔚来开发了仿真器NSim(NIO Simulation)。在整个数据链路上,车端的群体智能 + NSim理论上可以给NWM提供源源不断的数据。

三、群体智能,智驾系统独特的验证路径

将智驾系统完全模型化,面临两个挑战:

第一,世界模型需要千万级Clips的真实数据,从哪里获得这些真实数据;

第二,过去智驾系统的bug,可能只需要定位问题,验证1%的模块,而现在随着模型的迭代,测试验证的工作量暴增。

过去蔚来「豪横」使用四颗OrinX的做法在业界颇有一些争议。在大模型的时代,群体智能的设计,似乎开始发挥出更明显的价值。

以数据收集为例,如果没有量产车队,一般的智驾公司持有的测试车辆最多在几百台级别,而几百台真值采集车光持有成本就达到几亿元。蔚来通过量产车队收集数据,目前NT2平台的车型总数在20多万台。

而群体智能,多用一块OrinX的设计,使车辆不光在智驾状态下,在非智驾状态下也能获取到有效数据。

蔚来在Banyan 2.6.5版本中上线的端到端AEB,其从20亿公里的数据中获取到了1万个碰撞事故事件。实际上,在NIO IN上公布的蔚来用户智驾领航的总里程还只有11亿公里(尽管已经是目前各家中总里程最高的)。

AEB能力提升的核心挑战是在大幅提升AEB场景覆盖率的基础上,不增加AEB的误触发,验证覆盖是开发中的难点。端到端AEB的验证也使用了群体智能,4亿公里分为10轮的里程验证。

少卿说,「群体智能和生成式模型是杀手锏,可以满足上游训练数据的需求。」

而在测试验证上,群体智能使得新的模型版本,可以对比人类驾驶的状态,也可以对比过去的稳态版本,形成反馈闭环。蔚来智驾团队告诉我们,「群体智能的验证非常接近于实车验证,大幅好于仿真验证」。

在过去的4年里,智能系统的架构每年都在发生翻天覆地的变化。

无论对电子电气架构、软件架构还是芯片设计,高度动态的技术变化始终是巨大挑战。

蔚来用长期的投入淌出了一条独特的路径。

免责声明:上述内容仅代表发帖人个人观点,不构成本平台的任何投资建议。