一文看懂最强大模型排名:6大关键指标全透视百模大战

谁是最强大模型?该如何评判?

从千团大战,到共享之战,再到如今的大模型之争,百模大战正如火如荼上演,孰优孰劣,各执一词。

今天我会结合第三方平台的数据对目前通用的大模型进行一次五大维度能力的排序:

对AI模型在关键性能指标(包括质量、价格、输出速度、延迟、上下文窗口等)进行比较和分析。

六大关键指标亮点:

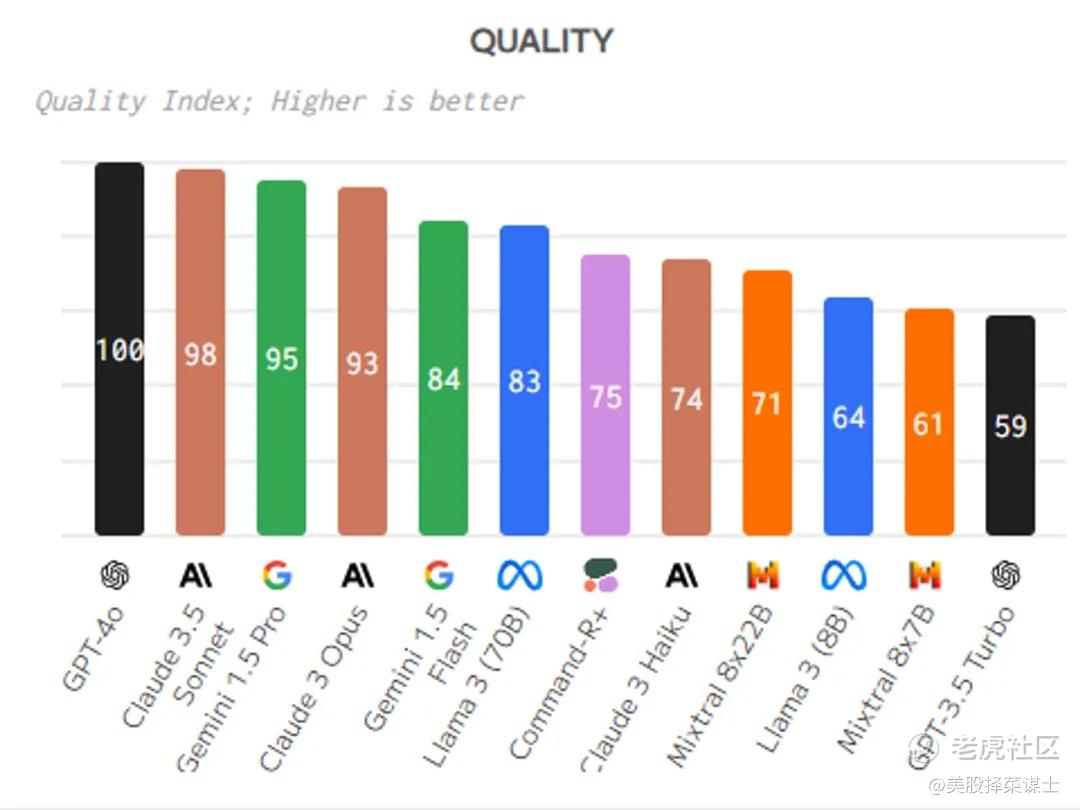

质量指数:用于评估模型在各种任务和基准测试中的性能表现,得分越高表示模型表现越好。

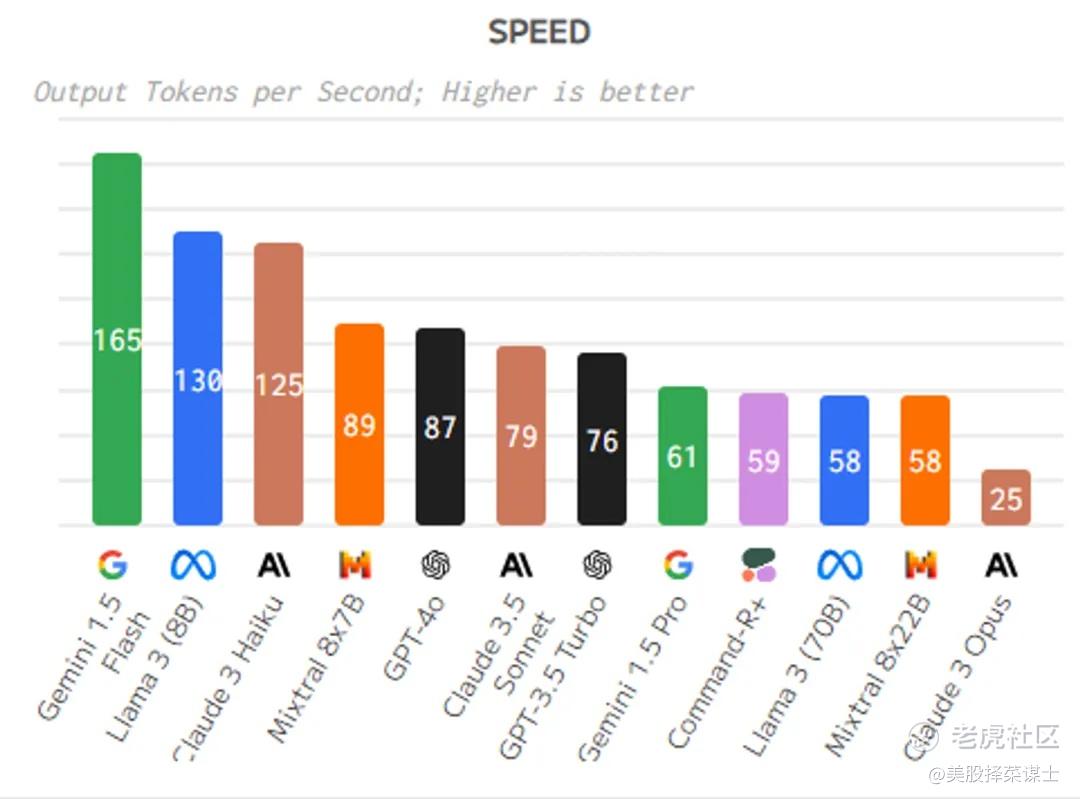

输出速度:衡量模型生成输出的速度,输出速度越高表示模型处理能力越强。

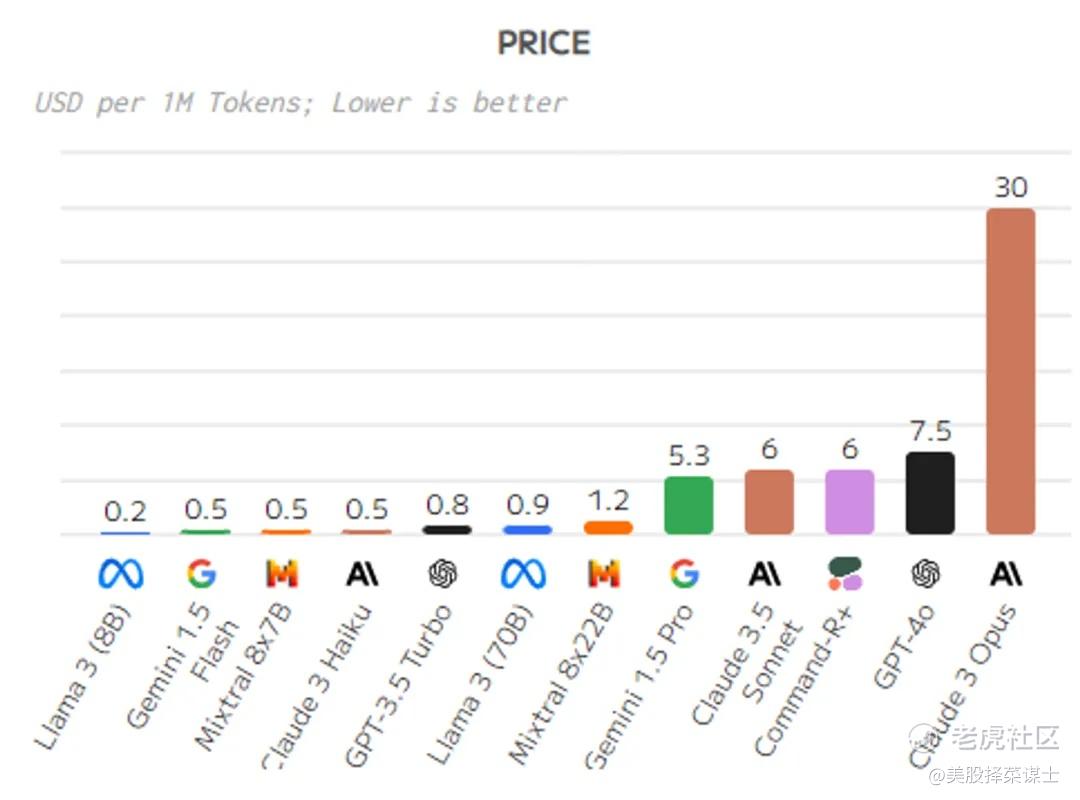

价格:表示模型的成本,价格越低表示性价比越高。

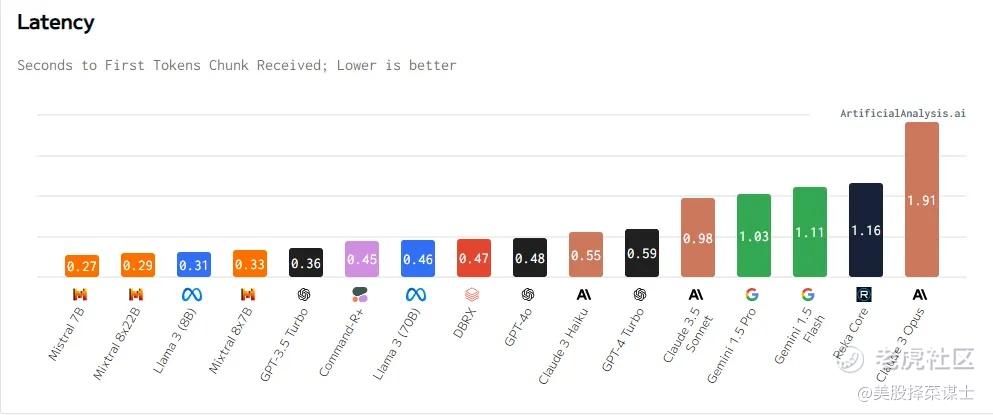

延迟:指从发送请求到接收到第一个响应之间的时间间隔,延迟越低表示模型响应速度越快。

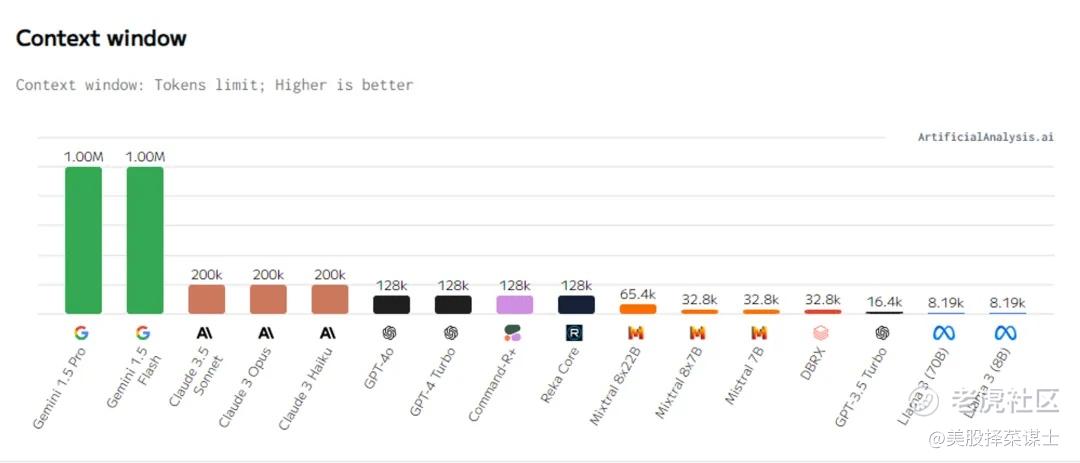

上下文窗口:表示模型在处理文本时能够同时考虑的标记数量的限制,较大的上下文窗口有助于模型更好地理解和生成文本。

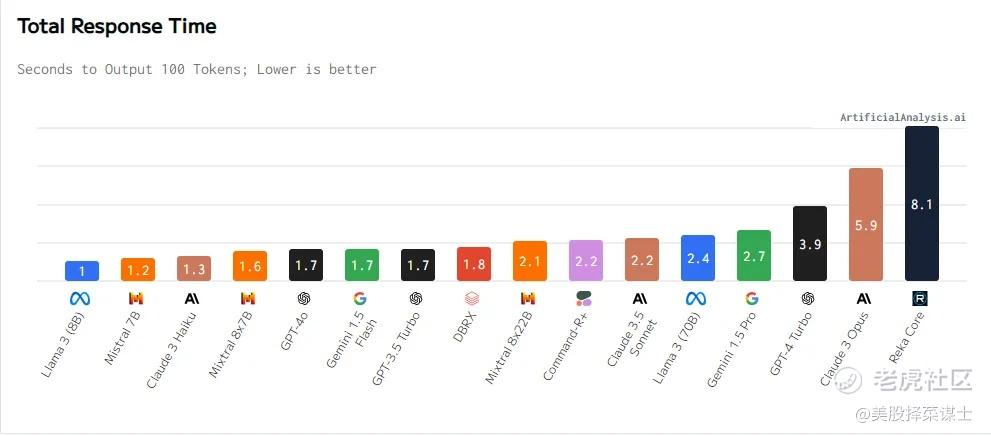

总响应时间:从发送请求到接收到完整输出结果所经历的时间,综合考虑了延迟和输出速度等因素。

这些关键指标可以帮助用户全面评估和比较不同AI模型的性能和特点,从而选择最适合特定任务需求的模型。

质量指数越高越好。质量与输出速度、价格之间存在权衡。质量指数代表在聊天机器人领域、MMLU和MT-Bench中的相对性能。

速度指标代表模型生成标记时的每秒标记数。

价格指标代表每百万标记的价格。模型之间存在速度差异,质量和价格不一定成正比。

总响应时间代表接收100个标记输出所需的时间,由延迟和输出速度指标计算。

延迟指标代表接收第一个标记所需的时间。总响应时间随着输入标记长度的增加而变化。速度和价格之间存在权衡。延迟和输出速度之间存在关系。

总响应时间随着输入标记长度的增加而变化。模型之间存在速度差异。总响应时间代表接收100个标记输出所需的时间。模型之间存在总响应时间的差异。

根据不同指标对AI模型进行排序如下:

第一,质量指数:

得分越高越好,大型AI模型的质量指数通常是根据模型在各种基准测试和任务中的表现来评估的。质量指数得分越高表示模型在各方面的性能表现越好。这些性能指标可能包括模型在自然语言处理、文本生成、对话系统等任务中的准确性、流畅性、逻辑性等方面的表现。较高的质量指数意味着模型在处理各种任务时具有更好的性能和效果。在选择使用大型模型时,质量指数是一个重要的参考指标,可以帮助用户评估模型的整体表现和适用性。

GPT-4o

Claude 3.5 Sonnet

Gemini 1.5 Pro

GPT-4 Turbo

Claude 3 Opus

Gemini 1.5 Flash

Llama 3 (70B)

Command-R+

Claude 3 Haiku

Mixtral 8x22B

Llama 3 (8B)

Mixtral 8x7B

GPT-3.5 Turbo

第二,输出速度:

大型AI模型的输出速度通常会受到多个因素的影响,包括模型的复杂性、参数数量、计算资源、优化程度等。一般来说,大型模型由于具有更多的参数和更复杂的计算过程,其输出速度可能会较慢。较大的模型通常需要更多的计算资源和时间来处理输入数据并生成输出,因此其输出速度可能会受到一定影响。然而,一些大型模型可能会通过优化算法、并行计算等技术来提高输出速度,以提高性能和效率。在实际应用中,需要综合考虑模型的输出速度、准确性和延迟等因素,以选择最适合特定任务的模型。

Gemini 1.5 Flash

Llama 3 (8B)

Claude 3 Haiku

Mistral 7B

Mixtral 8x7B

GPT-4o

Claude 3.5 Sonnet

GPT-3.5 Turbo

第三,大模型token价格:

大型AI模型的价格通常会受到多个因素的影响,包括模型的复杂性、参数数量、训练成本、计算资源等。大型模型通常需要更多的计算资源和时间来训练和部署,因此其价格可能会较高。另外,一些大型模型可能需要专门的硬件设备或云计算服务来支持其运行,这也会增加成本。在选择使用大型模型时,需要考虑其价格与性能之间的平衡,以确保在满足需求的同时控制成本。不同的提供商和服务可能会有不同的定价策略和价格模型,因此在选择大型模型时需要进行综合评估和比较。

Llama 3 (8B)

Gemini 1.5 Flash

Mixtral 8x7B

Claude 3 Haiku

GPT-3.5 Turbo

Llama 3 (70B)

Mixtral 8x22B

GPT-4 Turbo

Claude 3 Opus

第四,大模型上下文窗口:

上下文窗口是指在自然语言处理中,模型在处理文本时能够同时考虑的标记数量的限制。换句话说,上下文窗口表示模型在生成输出时可以看到的输入文本的长度范围。较大的上下文窗口意味着模型可以考虑更多的上下文信息,从而更好地理解和生成文本。在某些任务中,如信息检索和推理,较大的上下文窗口可能会带来更好的性能。因此,上下文窗口是评估模型能力和性能的重要指标之一。

Gemini 1.5 Pro

Gemini 1.5 Flash

Claude 3.5 Sonnet

Claude 3 Opus

Claude 3 Haiku

GPT-4o

GPT-4 Turbo

Command-R+

Reka Core

第五,总响应时间:

大型AI模型的总响应时间通常会受到多个因素的影响,包括模型的复杂性、参数数量、计算资源、输入数据大小等。总响应时间是指从发送请求到接收到完整输出结果所经历的时间。对于大型模型,由于其复杂性和计算需求较高,总响应时间可能会较长。然而,一些大型模型可能会通过优化算法、并行计算等技术来降低总响应时间,以提高性能和效率。在实际应用中,需要综合考虑模型的总响应时间、准确性和延迟等因素,以选择最适合特定任务的模型。

Llama 3 (8B)

Mistral 7B

Claude 3 Haiku

Gemini 1.5 Flash

GPT-3.5 Turbo

Mixtral 8x7B

GPT-4o

Claude 3.5 Sonnet

第六,延迟排序:

此外,根据延迟(秒数)对AI模型进行排序如下:大型AI模型通常具有较高的延迟,因为这些模型需要处理更多的参数和更复杂的计算。大型模型通常需要更多的计算资源和时间来处理输入数据并生成输出。因此,与小型模型相比,大型模型的延迟可能会更长。然而,一些大型模型可能会通过优化和并行化处理等技术来降低延迟,以提高性能和效率。在选择使用大型模型时,需要权衡其性能和延迟之间的关系,以满足特定应用的需求。

Mistral 7B

Mixtral 8x22B

Llama 3 (8B)

Mixtral 8x7B

GPT-3.5 Turbo

Command-R+

Llama 3 (70B)

DBRX

GPT-4o

Claude 3 Haiku

GPT-4 Turbo

Claude 3.5 Sonnet

Gemini 1.5 Pro

Gemini 1.5 Flash

Reka Core

Claude 3 Opus

======================================

根据不同指标的排序,可以更清晰地了解各个AI模型在关键性能指标上的表现。

根据排序结果,可以总结六大关键指标的亮点如下:

质量指数:GPT-4o和Claude 3.5 Sonnet在质量指数方面表现最好,得分较高,显示出在各种任务和基准测试中的优异性能。

输出速度:Gemini 1.5 Flash和Llama 3 (8B)在输出速度方面表现突出,具有较高的处理能力和速度。

价格:Llama 3 (8B)和Gemini 1.5 Flash在价格方面表现较好,价格较低,性价比较高。

延迟:Mistral 7B和Mixtral 8x22B在延迟方面表现较好,响应速度较快。

上下文窗口:Gemini 1.5 Pro和Gemini 1.5 Flash具有较大的上下文窗口,有助于模型更好地理解和生成文本。

总响应时间:Llama 3 (8B)和Mistral 7B在总响应时间方面表现突出,能够快速生成完整的输出结果。

综合以上亮点总结,用户可以根据具体需求和重点关注的指标选择最适合的AI模型。

全文完。

免责声明:上述内容仅代表发帖人个人观点,不构成本平台的任何投资建议。