月之暗面发布 k0-math 数学模型,宣布 Kimi 10 月月活超 3600 万。

文丨王与桐 程曼祺 编辑丨程曼祺

今日下午,月之暗面创始人杨植麟出席了一场小型媒体沟通会,发布 Kimi 数学模型 k0-math,称该模型会在未来 1-2 周内上线 kimi 产品;杨植麟同时披露,10 月使用 Kimi 的人数已超过 3600 万。

这场沟通会在前一天开始组织,此类活动,一般会给现场媒体自由提问时间,月之暗面此次则在现场开放了 3-5 个自由提问,同时提前收集了一些问题,投屏到 PPT 上,杨植麟从中挑选回答。

本周一,《暗涌 Waves》报道了杨植麟联合创立的上一家创业公司循环智能的部分股东在香港对杨植麟和循环智能另一位联创张宇韬提起仲裁;接近此事的人士称,仲裁原因可能是:在尚未拿到来自循环部分投资方的同意豁免书时,杨植麟和张宇韬等人已启动月之暗面融资。

月之暗面此后回应:铭德律师事务所已接受杨植麟和张宇韬委托,该事务所认为仲裁事项既缺乏法律依据,也不具备事实基础,将依法提出抗辩。

沟通会前,月之暗面称此次沟通会只聊技术与产品,不回应包括仲裁在内的与技术、产品不相关的问题。

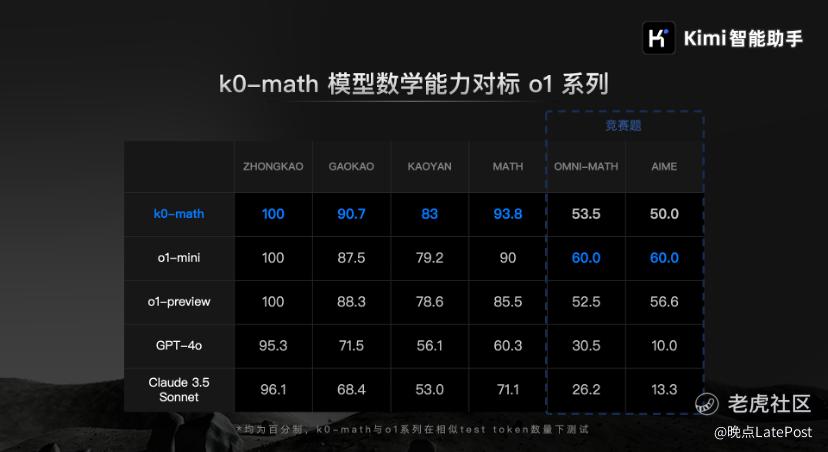

在沟通会的分享环节,杨植麟先介绍了 Kimi 数学模型的一些基本指标。以往很少参与公开测评的月之暗面,这次拿出了一个与 o1 的评分对比表。

k0-math 与 o1-mini、o1-preview 等模型在数学测试上的比较。

据月之暗面,在中考、高考、考研等考试测试上,k0-math 的表现优于 OpenAI o1。月之暗面方面称,他们使用了中考、高考和考研的真题来测试。

在数学竞赛 OMNI-MATH(北京大学和阿里巴巴在今年推出的一个评测基准,评估大型语言模型在奥数级别难题上的推理能力)和 AIME(美国数学邀请赛 American Invitational Mathematics Examination) 上,k0-math 的得分则略低于 o1。

k0-math 的技术思路与 o1 类似,也是在大语言模型架构上结合强化学习算法,训练出能像人那样分步骤思考的模型,在回答问题和生成内容时展现 “思维链”(CoT, Chian of Thoughts)。

杨植麟将其总结为 Scaling law 的范式转换:从预测下一个 token 的规模扩展( Next-Token Prediction Scaling)到强化学习的规模扩展(Reinforcement Learning Scaling)。

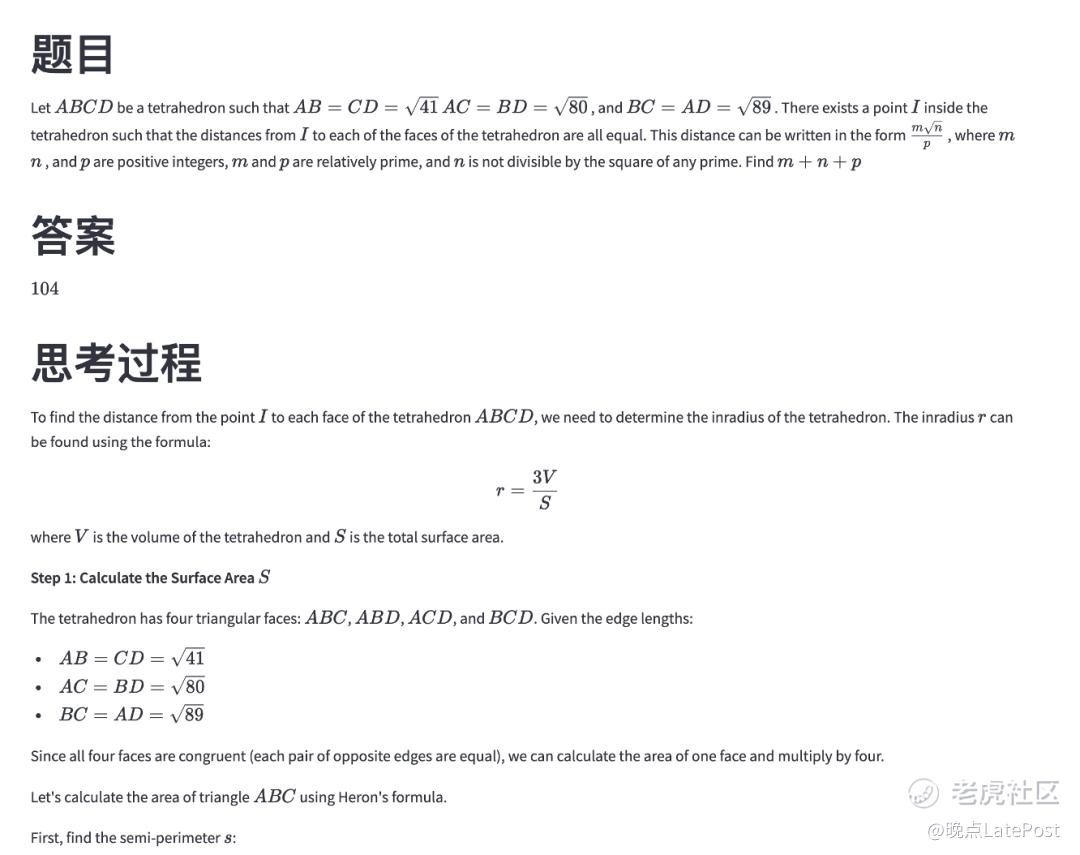

杨植麟在现场展示了一些 k0-math 的实例。比如在处理 AIME 最后一道数学竞赛题时,遇到了一个难点,k0-math 尝试了多个路径,最开始是用了不等式,失败后再用换元方式得到正确正确答案,k0-math 展示了详尽的解题思考过程。

k0-math 解答数学题的思考过程节选,完整回答共有 100 多行。

而在一些简单问题上,比如 1+1 是否等于 1,4046 / 476 是多少,k0-math 目前有 “过度思考” 的倾向。杨植麟说,未来当模型越来越聪明时,将能自主判断什么问题要思考更久,什么问题可以马上回答。

在怎么使用新的数学模型上,杨植麟说,他们希望把 k0-math 代表的强化学习能力用到搜索场景里,与 Kimi 探索版结合,这样能够更好完成复杂搜索,在工作场景里发挥更多价值。

比如,新模型可以理解用户更丰富的意图——当一个用户输入 “特斯拉 Model Y” 时,探索版可以推测出用户想要的是财报的信息还是价格的比较,而不是单纯的回答问题。“在收集过程中,我们可以看到非常多不同的数据源,这些数据之间有冲突,需要思考哪个数据是真实、有效的。这样一来,模型就能做在扩展到更多信源的同时,完成链式推理。” 杨植麟说。

此前,月之暗面的相关技术与产品动态多与无损压缩的长文本(lossless long context)有关。去年 10 月第一次亮相时,月之暗面就称 Kimi 能处理 20 万字的长文本。这之后,月之暗面发布了 moonshot-v1 系列三个模型,分别适用于生成短文本、长文本和超长文本。今年 3 月,长文本又从 20 万字扩大到 200 万字。

杨植麟一直强调模型即产品。成立至今,月之暗面较少释放模型及测评信息,讲得最多的是产品。月之暗面的主打产品 Kimi 从去年 11 月全面上线至今,也实现了从 0 到月活 3600 万的增长,这帮助去年 4 月成立的月之暗面在不到 24 个月里,达到了超 30 亿美元的估值。

在技术、产品和商业化之外,市场也关注这家公司的核心团队、治理结构和围绕创始团队一些暂未有全貌的事件:这包括年初阿里的 8 亿美元的大额投资及后续,以及最近发生的仲裁风波。

公司往往是创始人个人特质和风格的外溢,尤其是早期公司。

AI 大模型创业的主线仍是模型技术进化速度与应用进展。但人们也想更多了解月之暗面,了解掌舵这家公司的创始人是一个怎样的人。

沟通会后,杨植麟在现场回答了一些提问,摘录如下(文字有部分删减):

聊技术:预训练还有半代到一代空间,未来重点是强化学习

Q:能完整回顾一下月之暗面关注到强化学习范式的过程吗?

杨植麟:这个变化其实可以预测。我们很早就说过,接下来推理占(计算量)的比例会远超训练,本质上说是一个事情,因为没有那么多数据训练,肯定就通过强化学习生成数据。所以我们更早就在规划在强化学习上我们能做什么,不管是人才还是技术储备。

人才上,我们去年就开始准备;技术上也经历了不同过程,比如一开始是 RLHF(基于人类反馈的强化学习,这是 OpenAI 在 GPT-4 上使用的微调方法),发现上限并没有那么高,所以还要探索新的、真正规模化的方式。

Q:月之暗面此前比较少直接介绍模型和预训练情况,你们现在的预训练的情况是怎样的?

杨植麟:我觉得预训练还有半代到一代的空间,这个空间明年会释放出来,明年领先的模型会把预训练做到比较极致的阶段。

但接下来最重点的还是强化学习。它还是 Scaling,只是通过不同的方式去 Scale。

Q:月之暗面的基础模型是部分使用了开源模型,还是自己来做的?

杨植麟:我们自己做的。

Q:月之暗面一直没有发布多模态模型的原因是什么?

杨植麟:我们也在做,在内测几个多模态能力。

AI 接下来最重要的能力是思考和交互,思考的重要性远大于交互,因为思考会决定上限,而交互是一个必要条件,如果没有 vision(视觉)能力没法做交互。

怎么看上限?就看做这个任务时,标注的难度有多大,你需要一个博士去标,还是人人都可以标?哪个更难,它就是(当前)AI 的上限。所以我觉得多模态肯定必要,但思考决定它(AI)的上限。

Q:现在很多人觉得 Scaling Law 遇到瓶颈了,你觉得这会如何影响中美大模型的竞争?差距是变大还是变小?对中国公司是好事还是坏事?

杨植麟:差距我觉得相对是一个常数,对我们来说它有可能是一个好事。

假设你一直 pretrain(预训练),今年 1B、明年 10B 或者 100B,它不一定可持续。当然做 post-train(后训练)也要 Scaling,只是 Scaling 的起点很低,在一段时间内算力就不会是瓶颈,此时创新能力是更重要的。在这种情况下我们反而有优势。

Q:像你这么聪明的人,会不会被 Scaling law 给限制住了?

杨植麟:我比较乐观。核心在于,原来 Scale 的方式是用静态数据集,比较简单粗暴;现在用强化学习,很多情况下有人参与这个过程,但人没法标注那么多数据,所以用 AI 给人的标注加一个杠杆,比如标 100 条数据,就能产生非常大的作用,因为剩下的是 AI 自己在思考。

我现在觉得大概率可以通过这种方式做出来,所以(Scaling law)的上限很高。

聊产品与商业化:AI 已出现超级应用,Kimi 最重要的目标是提升留存

Q:新发布的数学模型的推理成本目前是怎样的?1-2 周上线后,是会主动让用户选择是否用 k0-math,还是 Kimi 自己分配?以及在 Kimi 目前还没有付费订阅的情况下,怎么平衡成本和让更多人能用上 k0-math?

杨植麟:我们接下来大概率会先让用户自己去选,早期通过这样的方式能更好满足用户预期。

但最终这还是一个技术问题,有两个点:一是能更加动态地去分配最优算力,如果模型足够聪明,应该知道什么样的问题需要想多久,就跟人一样,不会 1+1 也想半天;二是长期看,成本也会不断下降,比如今年要达到去年 GPT-4 的水平,只需要十几 B 的参数,去年可能需要 100 多 B。整个行业都是先做大再做小,这是普世规律。

Q:怎么看 Kimi 和豆包的竞争?

杨植麟:我不希望我们过多关注竞争,因为竞争并不产生价值。我们更关注如何迭代更好的技术和产品。我们会更聚焦在怎么提升模型的思考推理能力。

做正确的事情,而不是专门去做不一样的事。只要能有人实现 AGI,都非常好。

Q:Kimi 目前最重要的核心任务是什么?

杨植麟:提升留存。因为留存是技术成熟的重要指标,并且(现在的留存)还有非常大的提升空间。我们的模型能力跟产品指标是高度是相关的。

目前我们的模型可能思考能力还不够强,交互还不够丰富,我们把这些东西做得更好之后,留存会进一步上升。

Q:前段时间某家第三方机构估算, Kimi 今年投放的金额有四、五亿,大部分是视频广告。Kimi 的投流策略是什么?

杨植麟:第一,数据不准确。第二,对我们来讲,最核心的还是把留存和增长做好。适当的投放是需要的,但需要平衡好这几个东西之间的关系。

Q:留存到多少会满意?

杨植麟:永无止境。

聊团队:没有人才流失,主动选择聚焦

Q:怎么看行业里 AI 人才从创业公司回流大厂?

杨植麟:我们没有遇到这个问题。别的公司遇到了也正常,因为行业发展进入了一个新阶段,会从一开始有很多很多公司在做,变成少一点的公司在做,并且接下来大家做的东西会逐渐不一样。这是必然规律。

Q:怎么看月之暗面近期的人才流失?

杨植麟:先问是不是,再问为什么。我们没有人才流失,我们主动做了业务减法。

这也是我们过去一年比较大的 lesson,我们一开始尝试过几个产品一块做,这在一定时期内奏效,但后来发现,这样就活生生把自己变成大厂了,没有任何优势。

砍业务本质上也是在控制人数。这几个大模型创业公司里,我们始终保持人数最少,始终保持卡和人的比例最高,这非常关键。我们不希望团队扩那么大,(扩大)对创新有致命性伤害。

另外我们也会根据美国市场的情况,判断哪个业务做大的概率更高。Super App(超级应用)已经出现了,ChatGPT 的月活已经超过 5 亿,它至少是半个超级应用。而像 Character.ai 这种产品,一开始用户量也蛮多,但是后面很难破圈。

所以根据我们自己的判断、包括美国市场的情况,聚焦在我们认为上限最高的事情上,而且这跟我们的 AGI misson 也最相关。

题图:现场照片,来源:视觉中国。

精彩评论