在凉爽的西雅图,屋子太小,CVPR太火。

作者|苏霍伊

编辑|王博

发自美国西雅图

美国当地时间6月19日,2024年IEEE国际计算机视觉与模式识别会议(CVPR)的最佳论文大奖揭晓。

作为计算机视觉和模式识别领域的顶级会议,每一届的CVPR的最佳论文都会受到广泛关注。今年共有4篇论文获奖,其中2篇最佳论文,2篇最佳学生论文。

其中,最佳论文是:

《Generative Image Dynamics(生成图像动力学)》,由谷歌研究院发布;

《Rich Human Feedback for Text-to-Image Generation(为文本到图像生成提供丰富的人类反馈)》,由加州大学圣地亚哥分校、谷歌研究院、南加州大学、剑桥大学及布兰迪斯大学合作发布。

最佳学生论文是:

《Mip-Splatting: Alias-free 3D Gaussian Splatting(Mip-Splatting:无混叠的3D高斯喷溅)》,由德国图宾根大学、图宾根人工智能中心、上海科技大学及捷克理工大学合作发布。

《BioCLlP: A Vision Foundation Model for the Tree of Life(BioCLlP:生命之树的视觉基础模型)》,由美国俄亥俄州立大学、微软研究院、加州大学欧文分校、伦斯勒理工学院共同发布。

CVPR火热的现场与西雅图凉爽的天气形成了鲜明对比,现场几乎所有活动都要排队。在6月17日到18日的活动中,不少场次座位满了,地板上也很快就坐满了人,西雅图会议中心的空地也有不少人席地而坐。

CVPR 2024现场,“甲子光年”拍摄

“甲子光年”从大会主办方了解到,本届CVPR共有来自76个国家和地区的超过12000人参加了线下会议,是CVPR历史上与会人数最多、规模最大的一届。其中,来自中国的参会者是美国之外最多的,共有1730人,包括中国内地1511人、中国香港134人、中国澳门2人、中国台湾83人。

今年CVPR共收到11532篇论文投稿,相比2023年的9155篇增加了25%,论文数量达到了历史新高,录取率却从去年的25.8%小幅下降到了23.6%, 仅2719篇被接收,竞争愈发激烈。

来自美国高校的Mark对“甲子光年”表示,本届盲审阶段获得三位审稿人一致满分意见(5/5/5)的论文“不在少数”,他的论文也是其中之一。“CVPR的审稿要求,所有的审稿只看质量不用接收率来衡量,所以满分多了并不是审查要求放低了,而是论文质量提高了。”Mark也是本届最佳学生论文的亚军获得者。

“合作”仍是学术研究的关键词。学术界贡献了39.4%的论文,而产业界与学术界合作成果则贡献了27.6%的论文。在产业界中,谷歌是最大的贡献者,提交了52篇论文,往后是腾讯和Meta,各贡献了35篇论文。

同时论文作者也增加了不少,参与撰写被接受论文的作者人数从去年的8457人增加到超过10000人。其中只有大约三分之一的作者在去年有论文被接受,许多新面孔加入了这场“学术竞赛”。

高亮论文(Highlights)和口头(Oral)报告环节也非常引人注目,分别有324篇和90篇论文获选进行展示,占总提交论文的2.81%和0.78%,入选比例不高,但每一篇都代表了CV领域的顶尖水平。

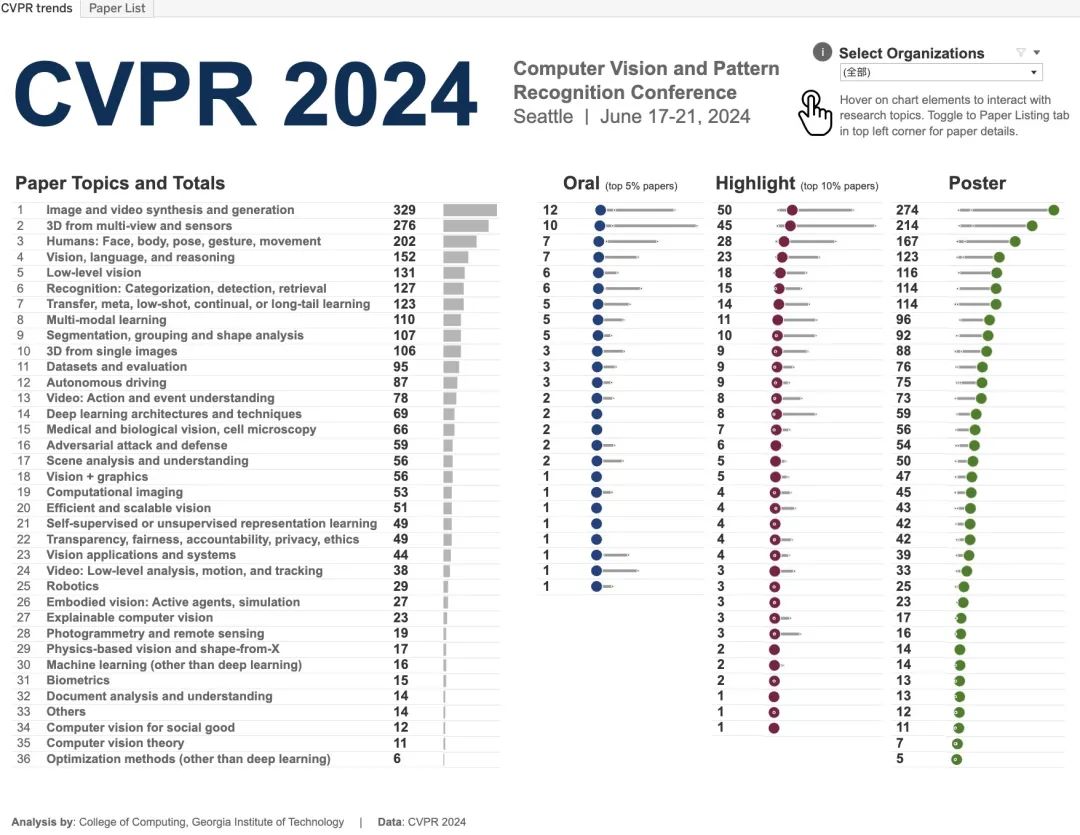

CVPR 2024论文主题分布,来源:CVPR

CVPR 2024论文数据展示了计算机视觉领域的全球趋势和新动向。研究最多的主题有:图像和视频合成与生成、三维视觉、人体行为识别、视觉、语言与语言推理、底层视觉、识别、迁移学习与多模态学习。特别是图像和视频合成与生成,这一研究主题在会议中共有329篇相关论文,是绝对的研究热点。紧随其后的是三维视觉和人体行为识别,分别有276篇和202篇论文。

根据“甲子光年”在现场的观察和探访,本届CVPR的热门研究领域主要有三个:

2D&3D生成(2D&3D generation);

具身智能(Embodied Artificial Intelligence);

视觉基础模型(Vision Foundation Models)。

1.最佳论文:谷歌研究院成最大赢家

相信大家对上一届CVPR的最佳论文还有印象,由上海人工智能实验室、武汉大学及商汤科技联合完成的《Planning-oriented Autonomous Driving(以路径规划为导向的自动驾驶)》,这也是近十年来计算机视觉三大顶级会议中(CVPR、ICCV、ECCV),第一篇以中国学术机构作为第一单位的最佳论文。另外,来自西北工业大学的团队也获得了CVPR 2023的最佳学生论文的荣誉。

尽管本届CVPR接收的来自中国的论文不少,但是最终只有上海科技大学的团队参与的论文获得了本届最佳学生论文。前两届获得最佳论文(最佳学生论文)提名的谷歌则是打了一个翻身仗,CVPR 2024两篇最佳论文都来自谷歌研究院,一作都是华人。

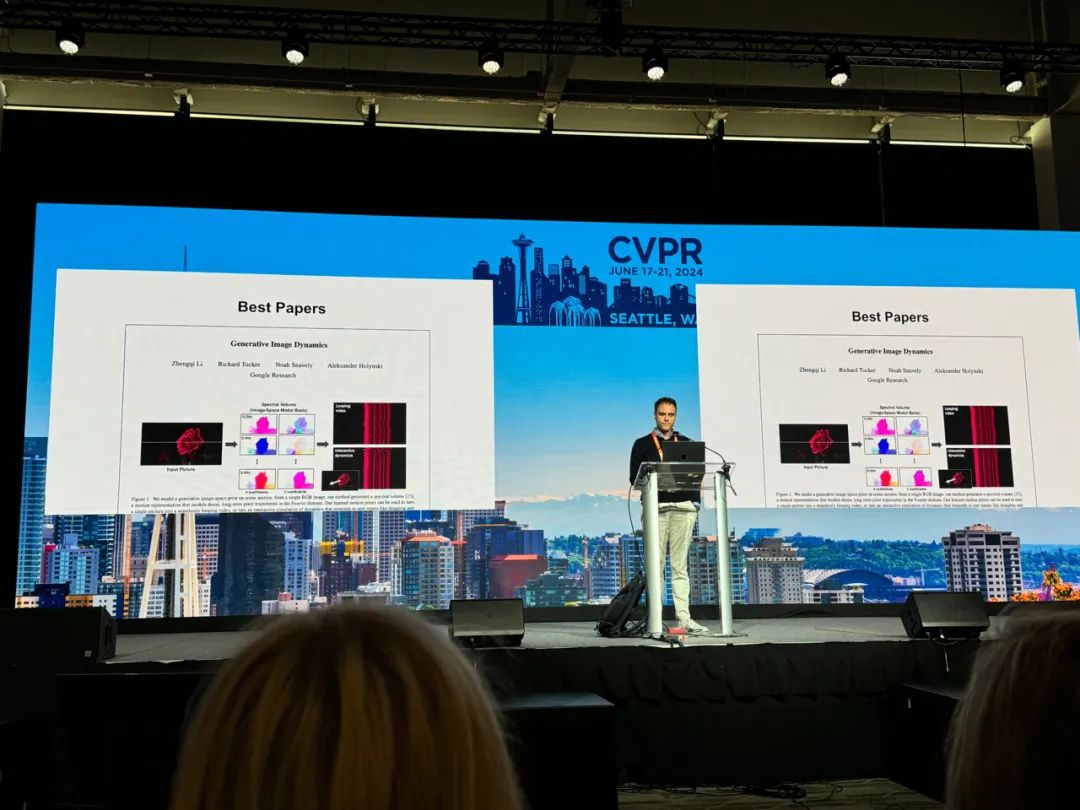

最佳论文《Generative Image Dynamics》颁奖现场,图片来源:“甲子光年”拍摄

第一篇最佳论文是来自谷歌研究院的《Generative Image Dynamics》,作者为Zhengqi Li、 Richard Tucker、Noah Snavely和Aleksander Holynski。

论文本质上研究了一类视频生成的子类问题,植物火苗等空气动态摇曳运动视频生成,它代表了真实物理世界中的空气运动,而这种运动是十分难以模拟的。

方法框架是采用两阶段的级联范式,第一从静态图片当中运动轨迹,第二以运动轨迹和静态图片为先验,生成动态视频。文章发现频谱体积这一特征可以作为一个很好的先验,控制静态图片的摇曳运动。值得注意的是,这样频谱体积也能从简单的运动,比如鼠标移动中重建恢复出来。

所以这项研究在虚拟世界人机交互,真实世界模拟的中有非常大的潜力和范式作用。现在很少用文章讲底层的信号处理知识和high level的任务,如图像生成联系起来。这篇文章回顾传统的信号处理算法,能够帮研究者做出具有差异化的实质性工作。

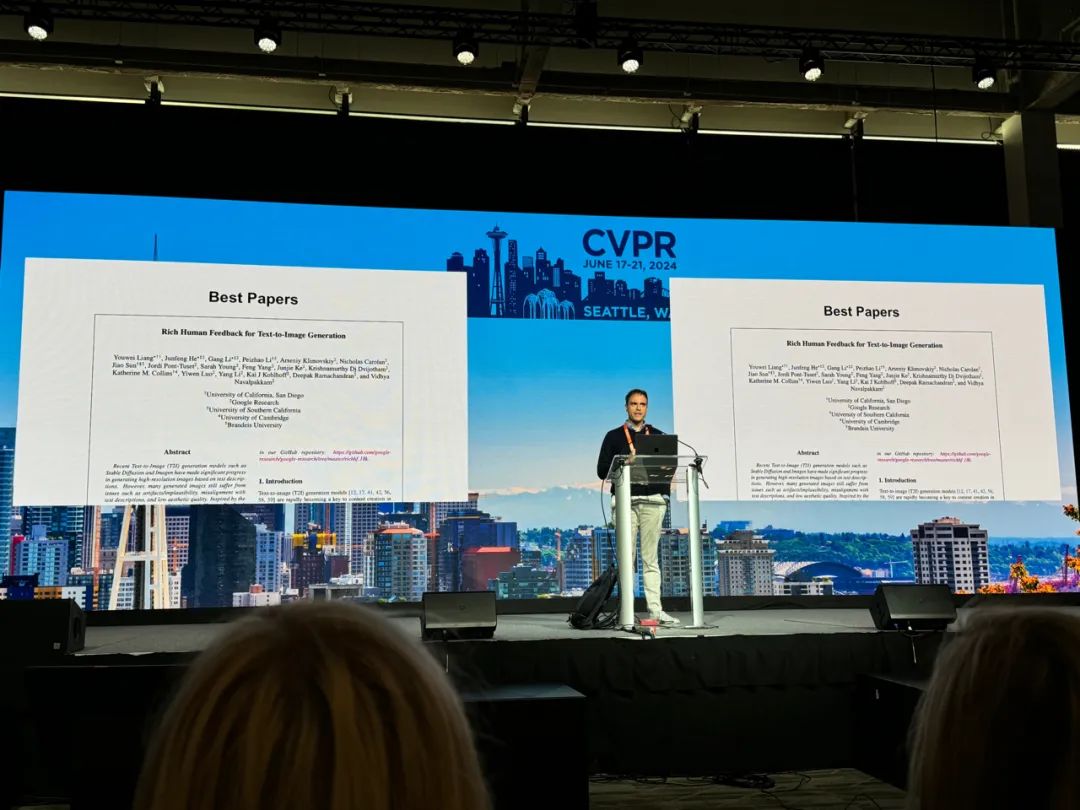

最佳论文《Rich Human Feedback for Text-to-Image Generation》颁奖现场,图片来源:“甲子光年”拍摄

第二篇最佳论文由加州大学圣地亚哥分校、谷歌研究院、南加州大学、剑桥大学及布兰迪斯大学共同发表的《Rich Human Feedback for Text-to-Image Generation》斩获,作者有Youwei Liang、Junfeng He、Gang Li、Peizhao Li等人。

他们提出的方法自动化模拟了人类的反馈过程。

许多生成的图像仍面临着不够真实、与文字描述不匹配以及审美质量不高等问题。该研究通过选用高质量的训练数据对生成模型进行微调,或者通过使用带预测热图的掩模来修正这些问题区域,从而改善了图像的生成质量。值得一提的是,这些改进措施不仅适用于收集人类反馈数据的图像,也能扩展到其他模型(如Muse模型)中。

人类反馈的概念最初由OpenAI在GPT模型中提出,目的是通过人类标注来指导并改正模型的不足。这篇论文将人类反馈的方法引入到图像生成领域,不仅如此,研究人员还创建了一个包含各种错误(如不匹配的文本、伪影区域、语义错误匹配和主观评分)的数据集。同时,他们也尝试使用一个多模态判别模型来模拟人类反馈的自动化过程。

实验结果表示自动化的标注模型在一定程度上能够模仿人类的反馈,显示出与人类标注的一致性。但值得深入探讨的是,这种自动化评分模型是否能真正替代人类的评价。因为人类反馈通常来源于具有不同背景的多样人群,能够提供更全面的评判。相比之下,自动化评分可能面临评判过于单一和模型过拟合的问题,尤其是这些模型通常是在特定的生成模型和图文对上进行训练的。

可以说,自动化标注模型在模拟人类反馈方面取得了一定成果,但其泛化能力和一致性仍需进一步验证。

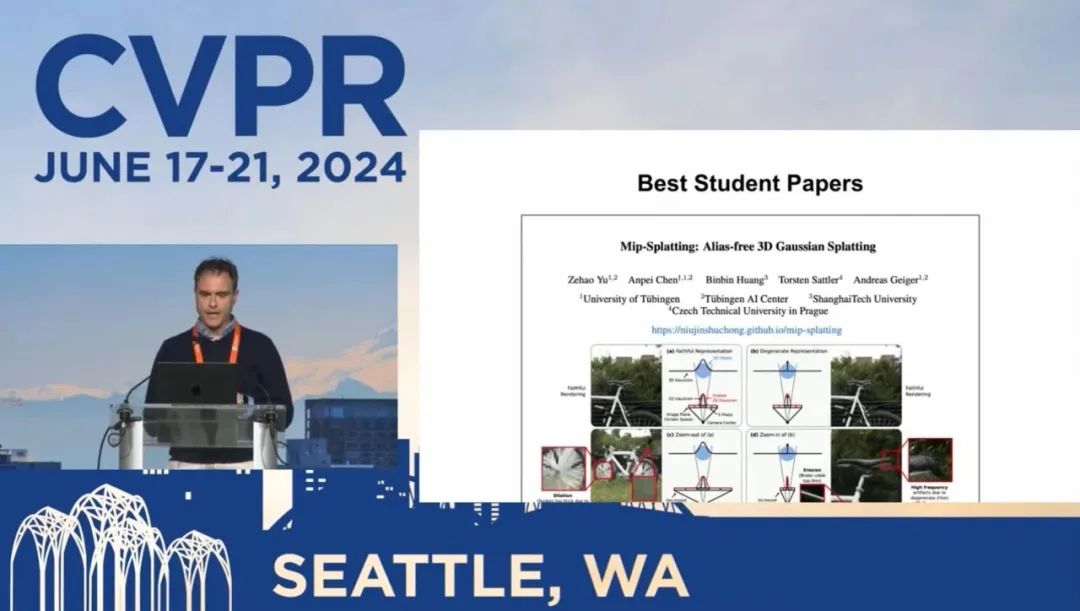

最佳学生论文《Mip-Splatting: Alias-free 3D Gaussian Splatting》颁奖现场,来源:CVPR

再来看最佳学生论文。

第一篇最佳学生论文颁发给了《Mip-Splatting: Alias-free 3D Gaussian Splatting》,由德国图宾根大学、图宾根人工智能中心、上海科技大学及捷克理工大学共同发表。作者为Zehao Yu, Anpei Chen, Binbin Huang, Torsten Sattler和Andreas Geiger,其中论文的一作、二作都是上海科技大学的在读或毕业生。

这篇论文重要关注3D高斯喷溅(Gaussian splash)在三维重建领域取得了高质量的效果,尤其是其渲染速度相比于之前的Nerf(神经辐射场)的方法有了极大的提升,但这一方法在改变采样率时,例如在改变焦距或者相机距离时会产生伪影,问题的根源可以归因于缺乏3D频率的约束和使用2D膨胀滤波器。

去年7月,法国科研机构Inria和德国马普所联合发表了一篇论文,详细介绍3D高斯喷溅技术,这项技术使得大规模生成精细化3D模型成为可能。论文一经发出,便在计算机视觉领域引起极高关注。AI创企知天下的创始人兼CEO宋宽此前对“甲子光年”表示:“这项技术具有划时代意义,高斯喷溅将使三维点云算法从‘小众’变成‘大杀器’。”

“甲子光年”注意到,这次Mip-Splatting引入了一个3D平滑滤波器,该滤波器根据输入视图引起的最大采样频率来约束高斯基元,从而消除高频伪影。

高斯伪影是3D生成中难以解决的问题。作者们引入了一个2D mip滤波器代替2D膨胀,可有效缓解混叠和膨胀问题,和高斯伪影问题。

值得一提的是,文章作者之一Binbin Huang(黄彬彬)还另提出2D Gaussian的高质量文章,可通过将3D基元转换为2D基元,有效地解决3D高斯表面几何粗糙的问题。

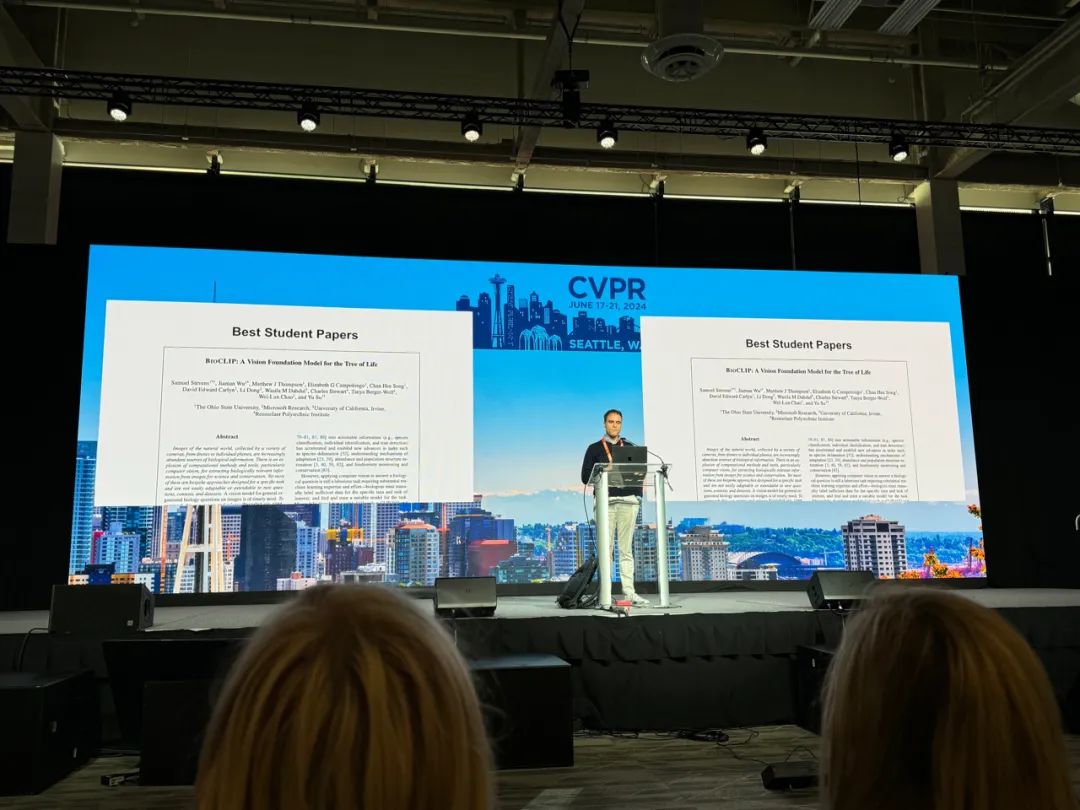

最佳学生论文《BioCLlP: A Vision Foundation Model for the Tree of Life》颁奖现场,来源:“甲子光年”拍摄

第二篇最佳学生论文由美国俄亥俄州立大学、微软研究院、加州大学欧文分校、伦斯勒理工学院共同发布的《BioCLlP: A Vision Foundation Model for the Tree of Life》获得,作者有Samuel Stevens、Jiaman (Lisa) Wu、Matthew J Thompson等。

近年来,随着无人机到个人手机等多种摄像设备的普及,自然界图像的收集已变得异常丰富。这些图像不仅仅是生物信息的丰富源泉,更成为了科学研究和保护工作中不可或缺的重要工具。然而,现有的计算方法和工具,尤其是计算机视觉技术,大多数是为特定任务量身定制的,难以适应新的问题、不同的环境和数据集。

针对这一挑战,来自俄亥俄州立大学等地的研究人员发布了名为TREEOFLIFE-10M的数据集,这是迄今为止规模最大、最多样化的生物学图像数据集。借助TREEOFLIFE-10M提供的大量植物、动物和真菌图像,以及丰富的结构化生物知识,研究团队开发出了BioCLlP——面向生命树的基础模型。

经过严谨的测试和评估,BioCLlP在多个细粒度生物分类任务中展现出了显著的性能优势,表现优于现有基准模型16%至17%。内在评估显示,BioCLlP学习到了符合生命树层次结构的表示方法,有着强大的泛化能力和广阔的应用前景。

2.现场感受:参会者最关注三大热门研究领域

CVPR 2024现场,图片来源:“甲子光年”拍摄

CVPR前两天的活动以Workshop、Tutorial为主,与上述三个领域相关的活动几乎每场都座无虚席,这其中很多都是华人面孔,从国内专程飞过来的观众也不少,西雅图当地的酒店价格也水涨船高。“屋子太小而CVPR又太火热。”来自中国科技大学的Dalison对“甲子光年”说。

在国内大学读研二的小罗此行就是希望通过CVPR来“套瓷”自己的目标博士生导师,“我已经有目标‘导师了’,写邮件很多时候可能就被淹没在茫茫‘邮’海中了,但在这里却能和大佬们当面交流。”

另一位来自丹麦哥本哈根参会者说自己第一次来参加CVPR,所以想“都看看、都转转”,“但感兴趣的演讲一些在同时进行,不得不做取舍。”

但是他发现再取舍,也会遇到挤不进会场的情况。例如,魏茨曼研究所数学系和计算机学院助理教授Tali Dekel发表的《AI for Content Creation Workshop》演讲,人多到已经“溢出”房间了,她的研究方向主要在于图像和视频分析、多识图系统等。

Tali Dekel的分享现场,观众已经排出场外,图片来源:“甲子光年”拍摄

而像Meta、OpenAI、LumaAI这样的知名公司的分享,也吸引了大量观众的关注,人们纷纷涌向这些活动的会议室,门口排起了长长的队伍。

会议现场的观众,图片来源:“甲子光年”拍摄

根据“甲子光年”在现场的观察和探访,本届CVPR的热门领域主要有三个:

2D&3D生成(2D&3D generation);

具身智能(Embodied Artificial Intelligence);

视觉基础模型(Vision Foundation Models)。

2D&3D生成代表着从认识世界到模拟世界,是人类对真实世界的逆向重塑。

具身智能代表着从虚拟走向真实,从认识世界到改变世界,是AI对自动化机械的智慧“革新”。

视觉基础模型是从局部子问题走向通解,类似于“All in one”,试图寻找一个“视觉GPT”去解决大多计算机视觉问题。做法是用统一的大模型去替代不同领域数据集上的专家模型。主要得益于Transformer技术的启发。这类模型在多个视觉任务中展示了卓越能力,包括图像分类、目标检测和图像生成。

CVPR用不同研究子领域,将相似研究背景的科研人员聚合在一起。他们通过演讲和Free talk的方式,分享自己的学术观点和见解。虽然没有统一的评价体系来判定其影响力,但对比下来,“甲子光年”感受到参会者心中都“自有判断”,这几天持续的思想碰撞会让他们继续探索新的研究方向。

这次会议共推出了123个workshop与24场tutorial,“甲子光年”主要听了其中三场。

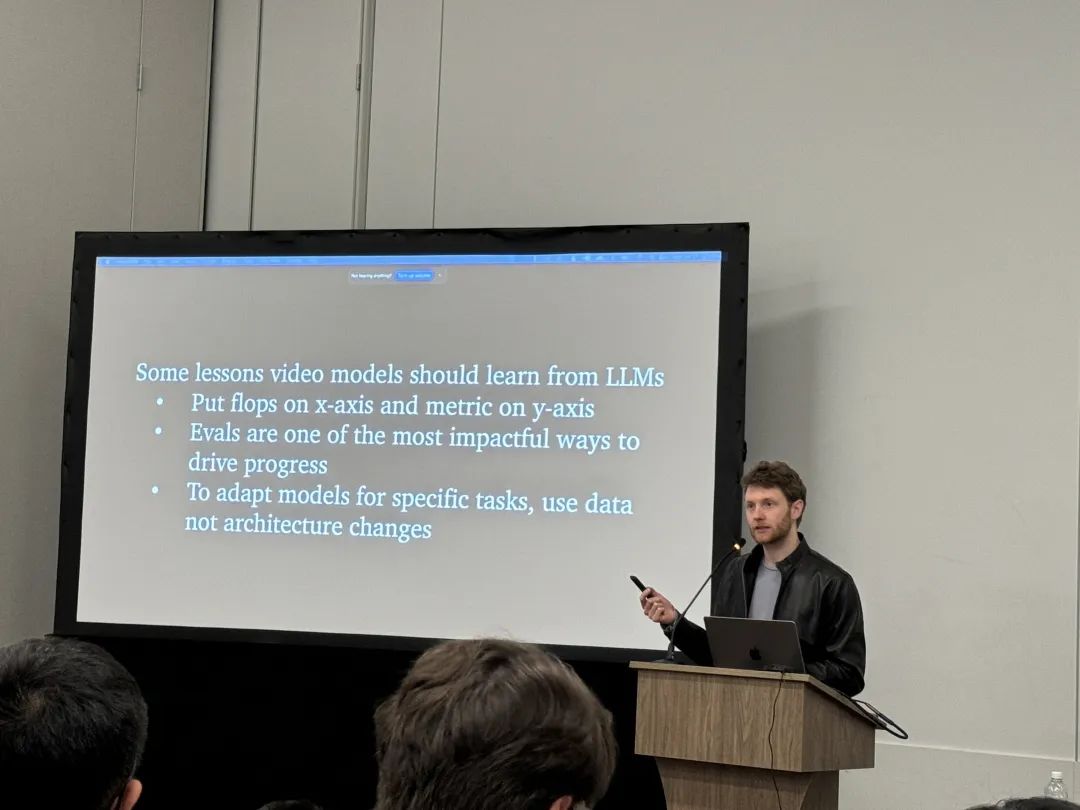

首先是OpenAI的Sora团队负责人Tim Brooks的分享,他曾主导了三代DALL-E的研究工作和Sora项目。如往常一样,Tim这次同样未讲述过多Sora的技术细节。有趣的是,在被问及如何平衡科研和兴趣时,他坦诚地回答道:“我已经一年多没有做科研了。”

Tim Brooks在演讲,图片来源:“甲子光年”拍摄

瑞士苏黎世联邦理工学院计算机科学系助理教授汤思宇在题为《Virtual Humans for Robotics and Autonomous Driving》的workshop中,分享了人体和物体的交互模拟的观点。从方法、数据等多个层面深入浅出地介绍了他们人类物体运动交互生成在系列工作。

她重点关注了人类运动实时性、多样性以及人造数据集的逼真性。这些工作对于人造机器人控制在算法上提供了帮助,能够让人形机器人根据简单的指令在模拟空间中做出自适应的相应动作。

从这届CVPR上关于人类与物体交互的研究来看,人形机器人在关键点算法问题上已经逐步突破。未来需要做的是,这些算法在真实世界中的复杂场景下的可复现性,以及配合硬件算法是否真的能做到可控性和实时性。

汤思宇在演讲,图片来源:“甲子光年”拍摄

刚刚在国内参加了2024北京智源大会的谢赛宁也出现在了CVPR 2024的现场,在主题为《Generative Models for Computer Vision》的workshop演讲中,他提到了DiT从顶会的“弃儿”到业界“新宠”的历程。和其他很多被拒论文一样,《Scalable Diffusion Models with Transformers》这篇论文在CVPR 2023曾因“lack of novelty(缺乏新颖性)”而遭到拒稿。

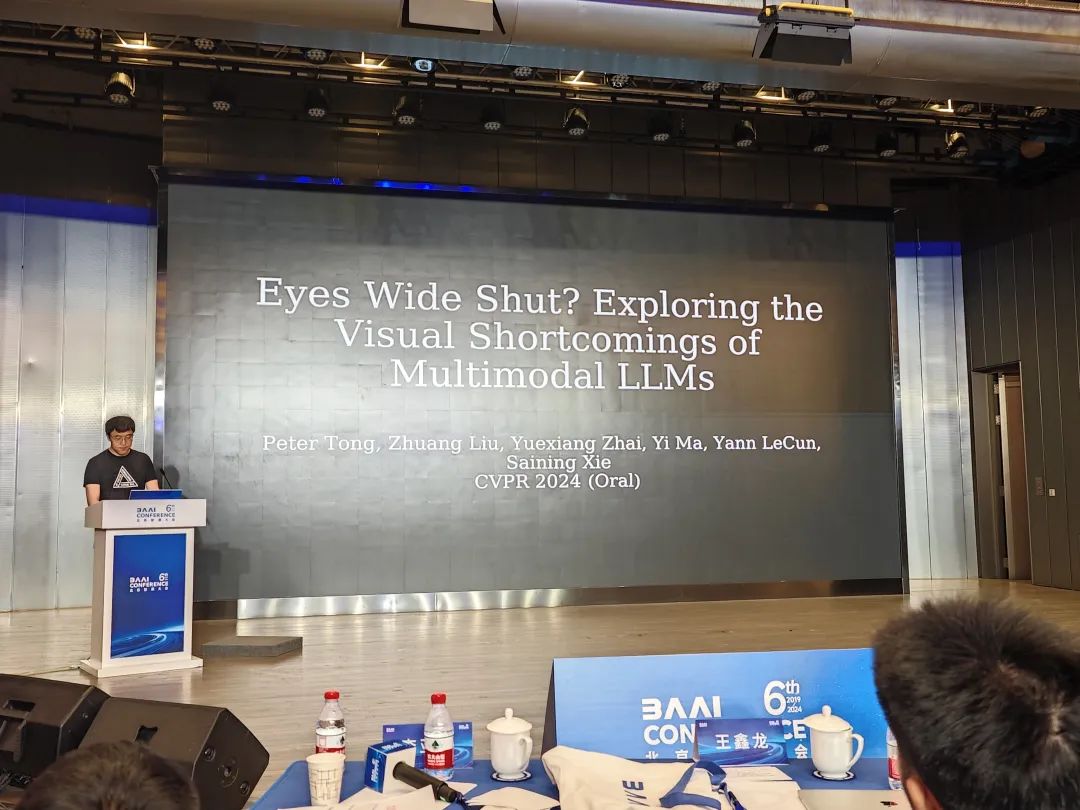

不过今年,谢赛宁参与的2篇论文被CVPR接收,在此前举行北京智源大会上,他也对论文进行了介绍。

谢赛宁在2024北京智源大会演讲,图片来源:“甲子光年”拍摄

其中一篇论文题为《Eyes Wide Shut? Exploring the Visual Shortcomings of Multimodal LLMs(视而不见?探究多模态大语言模型的视觉缺陷)》,联合作者包括了图灵奖得主杨立昆和香港大学教授马毅。

谢赛宁现场提出了一个问题:“Is vision good enough for language? (视觉对语言来说足够好吗?)”

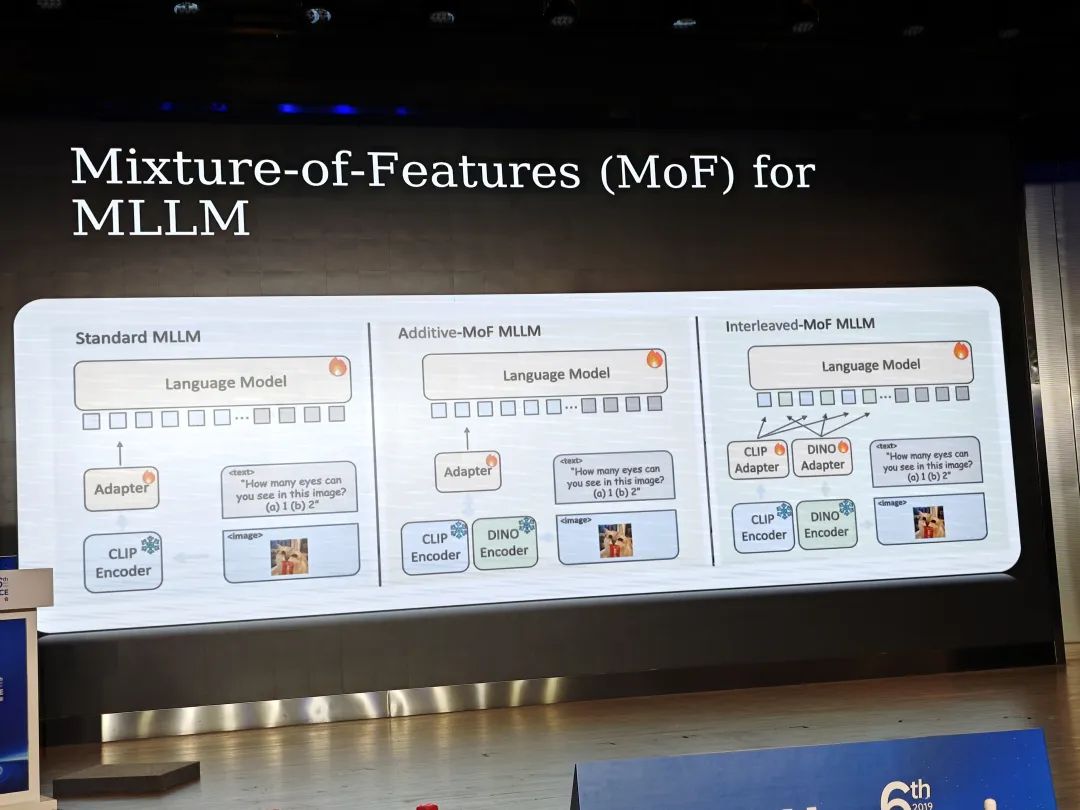

多模态模型的进步主要来自于大语言模型强大的推理能力。然而,视觉部分通常只依赖于实例级对比语言-图像预训练(CLIP)。谢赛宁等人的研究表明,最近的多模态大语言模型(MLLMs)在视觉能力上仍然存在系统性的不足,他们提出了一种特征混合(MoF)方法,证明将视觉自监督学习特征与MLLMs集成可以显著增强它们的视觉基础能力。总之,视觉表示学习仍然是一个开放的挑战,准确的视觉基础对于未来成功的多模态系统至关重要。

谢赛宁在2024北京智源大会演讲,图片来源:“甲子光年”拍摄

“我们其实可以尝试去补足CLIP model的短板,”谢赛宁在智源大会上说,“但是CLIP已经待在这个领域里太久了,我们现在急需一个alternative pipeline(替代流程)。”

与智源大会上被“围堵”类似,谢赛宁也是CVPR 2024上的“明星”,在他演讲结束之后,也有很多人围住他期待与他交流。

CVPR 2024现场,图片来源:“甲子光年”拍摄

在CVPR 2024现场,“甲子光年”感受到,在大模型时代的计算机视觉领域,传统的判别式回归任务的应用空间被显著压缩。

如简单的图像分类、物体检测等,曾经是研究的重点,但现在它们的应用空间正被显著压缩。这种变化主要是因为像Meta提出的“分割一切的模型”——SAM,这类大型模型不仅能够以高效率完成这些任务,还能在更复杂的任务上展现出色的性能。例如,SAM能够通过大量预训练数据学习到丰富的特征表示,使其能够轻松适应多种视觉任务,从基本的分类到复杂的场景理解。

随着AIGC在视觉任务中的需求高涨,对算力和大模型训练的经验要求也随之增加。AIGC涉及从文本到图像的生成、风格转换、以及新颖视觉内容的创造等复杂任务,这些都需要强大的计算资源和高级别的模型训练技能。

由于这些任务对资源的需求极高,学术界的多数团队在没有足够算力和资源的情况下,往往局限于进行模型的微调(fine-tuning)或无需进行大规模训练的研究。

这种资源限制导致了研究的两极分化:一方面是有能力进行大规模训练的大公司和顶尖实验室,他们能够探索和创新更多高难度的技术;另一方面是资源有限的研究团队,他们需要在现有的技术框架内寻找新的应用方式或改进方法。

只是这种分化在推动技术快速进步的同时,学术界又该如何面对平等科研机会的挑战?

(封面图来源:“甲子光年”拍摄)

精彩评论