Runway CTO:将在“几天内”向付费用户提供。

作者|王艺

编辑|赵健

文生视频领域又有新模型来卷了。

北京时间6月17日晚九点,Runway发布了其最新的视频大模型Gen-3 Alpha,这是Runway即将推出的一系列模型中的第一个。Runway称,与Gen-2相比,Gen-3 Alpha在保真度、一致性和运动方面有了重大改进,并且朝着构建“通用世界模型”的道路上迈出了重要一步。

Runway成立于2018年,是一家AI视频编辑软件提供商。很早之前,Runway在文生图领域就曾经大放异彩,和Stability AI一起训练了大名鼎鼎的Stable Diffusion模型。

2023年2月,Runway提出了首个AI编辑模型Gen-1,用户可以在原视频基础上进行编辑操作;2023年2月,在很多用户都没拿到Gen-1内测资格的时候,Gen-2就发布了。相比Gen1,Gen-2在实现更高保真度和一致性的同时,增加了Multi-Motion Brush功能,允许用户在一张图像上选择多个区域,并对每个区域设置不同的运动速度参数;同时,Gen-2还可以无需原视频基础,从头升成视频。

本次发布的Gen-3 Alpha模型使用视频和图像联合训练,其特色包括:

90秒内快速生成10秒视频

并行生成多个视频

模型驱动新的文本到视频(T2V)、图像到视频(I2V)和文本到图像(T2I)

动作笔刷、高级摄像机控制、导演模式

即将推出用于精细控制结构、风格、动作的工具

Runway CTO Anastasis Germanidis发帖表示,在多模态模型中,“控制”(即可控性)是关键,视频扩散模型(Vedio Diffusion Models)还远远未达到通过Scaling带来的性能提升;并且这些模型在学习预测视频的任务时,构建了视觉世界的强大表征,因此对于这些表征的把握至关重要。

Anastasis Germanidis在接受采访时也透露了Gen-3 Alpha的发布时间点:将在“几天内”首先向付费 Runway用户提供,但免费版本也将在未来某个时间点向所有用户开放。

Anastasis Germanidis的专访报道,图源:VentureBeat

相比于其他视频生成模型,Gen-3 Alpha更加侧重于为专业的艺术家服务,其宣传语就是——“For artists, by artists(为艺术家而生,由艺术家而生)。”

这也是Runway的愿景,Runway的强大逼真的影像生成能力可能会在影视创作领域掀起AI革命。

Runway CEO Cristóbal Valenzuela曾在今年3月份发帖称——“让我们拍电影吧。我们不要花5000万美元拍一部电影,而是用100万美元拍500部电影。”

1.更细颗粒度的时间控制

Gen-3 Alpha接受了高度描述性、时间密集的说明文字的训练,因此能够实现富有想象力的过渡,和更为精确的场景元素关键帧,在动作跟随和时间控制上表现得更加精准:

Prompt: An extreme close-up shot of an ant emerging from its nest. The camera pulls back revealing a neighborhood beyond the hill.

提示词:一只蚂蚁从巢中爬出来的特写镜头。镜头向后拉,显示出山那边的一个社区。

Prompt: Handheld camera moving fast, flashlight light, in a white old wall in a old alley at night a black graffiti that spells ‘Runway’.

提示词:手持相机快速移动,手电筒的灯光,在一个古老的小巷的白色旧墙上的黑色涂鸦,拼写“Runway”。

Prompt: An astronaut running through an alley in Rio de Janeiro.

提示词:一名宇航员正在里约热内卢的一条小巷里奔跑。

Prompt:Handheld tracking shot at night, following a dirty blue ballon floating above the ground in abandon old European street.

提示词:手持跟踪拍摄在夜间,跟随一个肮脏的蓝色气球漂浮在地面上在废弃的旧欧洲街道。

2.更逼真的人类角色

此次发布的Gen-3 Alpha擅长创造具有多种动作、手势和情感的富有表现力的人类角色,给了视频创作者更好的“讲故事”的可能性:

Pompt: Subtle reflections of a woman on the window of a train moving at hyper-speed in a Japanese city.

提示词:日本某城市高速行驶的火车窗户上,映出一位女性的微妙倒影。

Prompt: An older man playing piano, lit from the side.

提示词:一位老男人在弹钢琴,灯光从侧面照来。

3.更多样的艺术风格

Gen-3 Alpha拥有一支“跨学科”的训练团队——它由研究科学家、工程师和艺术家组成;同时,不同于其他多模态大模型在特定基础上训练而成,Gen-3 Alpha是从零开始训练的,这就使其突破了原有视频范式的束缚,带来了一定的创造力。也因此,Gen-3 Alpha能更好地诠释各种艺术风格和电影术语。

Prompt: A man made of rocks walking in the forest, full-body shot.

提示词:一个由岩石构成的男人在森林中行走,全身照。

Prompt: Zooming through a dark forest with neon light flora lighting up.

提示词:穿过一片黑暗的森林,霓虹灯植物亮起。

Prompt: An ultra-wide shot of a giant stone hand reaching out of a pile of rocks at the base of a mountain.

提示词:一张超广角镜头,一只巨大的石手从山脚下的一堆岩石中伸出。

Prompt: Aerial view shot of a cloaked figure elevating in the sky betweem slyscrapers.

提示词:从空中拍摄的隐形人物在摩天大楼之间的天空中升起。

此外,Runway还在官网中表示,作为 Gen-3系列模型的一部分,他们一直与领先的娱乐和媒体组织合作并建立伙伴关系,为他们提供Gen-3 Alpha的定制版本。Gen-3系列模型的定制版允许用户生成更加风格化、与现实更加一致的内容,并且可以针对特定的艺术和叙事要求进行编辑。

同时,Runway团队还将为Gen-3 Alpha还将发布一套新的保护措施,包括全新的内部视觉审核系统和C2PA(Coalition for Content Provenance and Authenticity,是一套新的技术标准和开源代码,可以标注内容来源)出处标准,以确保Gen-3 Alpha生成内容版权的有效性。

4.网友:比Luma和Sora还要先进

相较于之前视频模型发布时外界的褒贬不一,此次发布的Gen-3 Alpha之后,网友的反应却相当的一致——几乎所有人都在为Gen-3 Alpha生成的效果所惊叹,质疑声寥寥。

比如有网友认为,Gen-3 Alpha生成动漫的能力是他们“很了解用户需求”的表现;

再比如有网友惊叹到,文本转视频的问题很快就解决了!

更是有人直接放上了瞠目结舌的表情以示震撼:

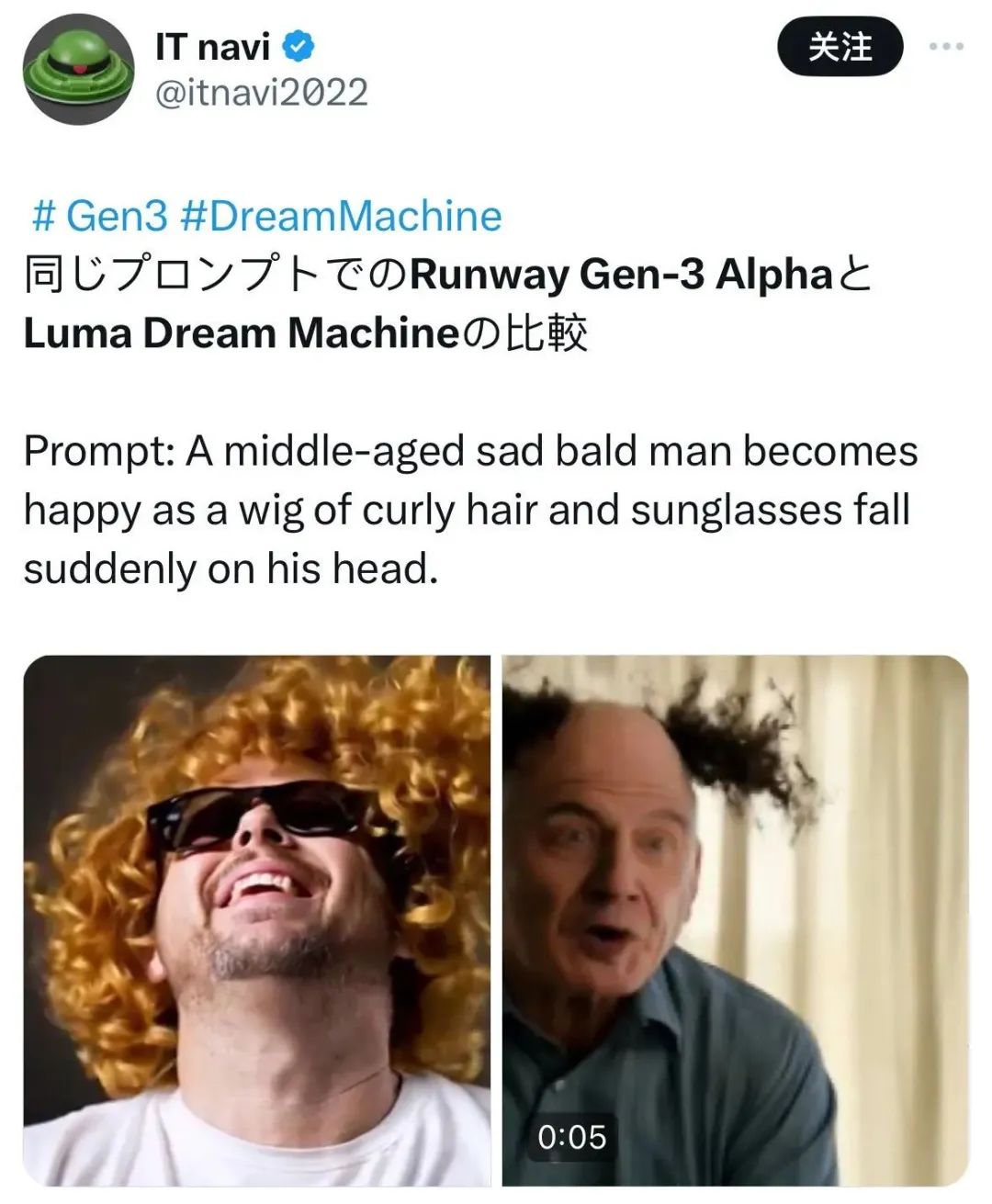

也有网友直接把Gen-3 Alpha和Luma Dream Machine的demo放在一起进行了对比,可以看出,无论在画质还是视频创意上,Gen-3 Alpha都明显优于Dream Machine;更有网友表示,“看起来比Luma和Sora还要先进”。

自今年二月Sora发布以来,AI视频领域就一直有玩家跃跃欲试,前有Snap Video、Vidu,后有快手可灵、Yisu、Dream Machine。相较于之前的AI视频产品,可灵和Dream Machine在视频真实性、连贯性上大大增强,已经有了一点“世界模型”的影子;

然而,AI视频领域的老玩家Runway在此期间的一直保持沉默,似乎是在养精蓄锐,直到今天才带来了惊艳世界、可控性更强、效果不输Sora的“世界模型”Gen-3 Alpha。

可以说,我们没有等来Sora,但等来了世界模型的全面开花。而下一个惊艳众人的世界模型是谁,我们也将拭目以待。

(封面图来源:Runway)

END.

精彩评论