"We are at the iPhone moment of AI" NVDA CEO 黄仁勋在GTC大会上三次提及,AI的iPhone时刻已经到来。 $英伟达(NVDA)$

一觉醒来AI产业大变天,最近接连几起轰动全球的科技事件,认知反复被刷新。微软深夜抛出的GPT-4 Office全家桶,一波王炸未平,紧接着谷歌推出新款聊天机器人Google Bard,文本生成视频Runway Gen2开启内测,Adobe的AI生成图像工具Adobe Firefly,惊魂未定,正苦苦思考我的剩余价值还剩什么,英伟达出其不意发布核弹新显卡,颠覆全球的AI决定性时刻,GTC2023来了。 $英伟达(NVDA)$

今年英伟达顺风而起,股价暴涨90%,市值飙升超越特斯拉,它背后的男人黄仁勋,在昨晚的GTC主题演讲上究竟说了些什么,为什么这是AI的iPhone时刻,我们一起来一探究竟。

精彩亮点

Nvidia GTC正成为前沿科技与颠覆性产品发布盛会

人工智能正扮演哪些角色

根植加速计算领域,十年实现百万倍加速

发展与深度学习的发展有着微妙的默契

英伟达加速计算业务进入正循环

A100工业化应用,同等条件成本可降低9倍

英伟达GPU与量子计算

RAFT助力Spark-RAPIDS大规模提升数据处理速度

cuOpt以300亿/s速度破世界纪录

Triton 让AI模型的部署和管理更加简单

CV-CUDA和VPF为视频处理领域降本增效

Parabricks 助基因组研究实现里程碑式成就

Holoscan用AI为医疗仪器赋能

Grace Superchip为云端服务供货商提供 2 倍成长机会

BlueField 与数据中心加速

DGX——大语言模型背后的功臣

人工智能的【iphone时刻】已到来

AI Foundation助力更多颠覆性AI产品

英伟达全新推理平台兼具弹性与适应性

Omniverse Cloud——拓宽虚拟世界与数字孪生的边界

Nvidia GTC正在成为前沿科技与颠覆性产品发布的盛会

全球 NVIDIA 生态已涵盖 400 万名开发人员、40000 家公司、14000 家初创公司,据统计有超过 250000人来参加这次大会。亚马逊云、微软、阿里云等这些各行业巨头都已作为钻石级赞助商加入NVIDIA的合作伙伴计划,获得NVIDIA最高级别的技术支持和资源,共同打造具有开创性、甚至是颠覆性的科技与产品生态。

GTC 2023邀请了来自学术界、行业大拿的优秀主讲者,大会主题不仅涵盖计算机视觉、对话式AI、高性能计算等当下最热门的话题,还包括一些更具想象力的、更远大课题的探讨,如Earth-2项目、微芯片的运算光刻技术议题等。NVIDA GTC聚集了各行各业的重要公司,包括人工智能、汽车与运输、医疗保健、制造业、金融服务、零售等,让全世界都看到了加速计算和AI为各行各业的赋能。

人工智能正在扮演哪些角色

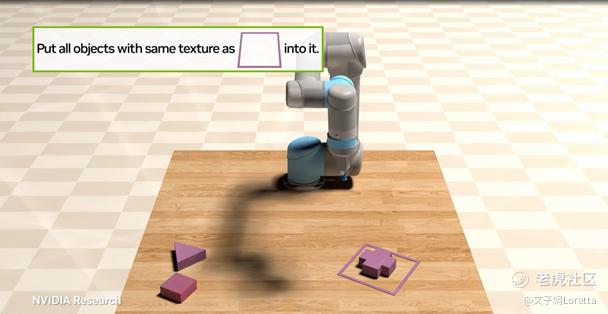

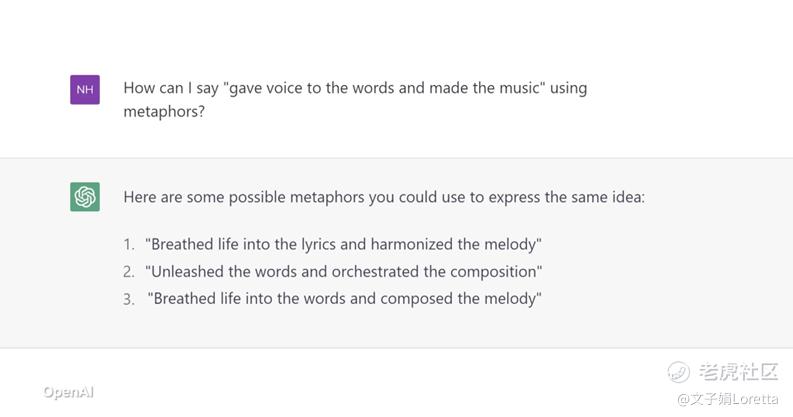

人机交互的翻译官:人类也许不再需要编程来向机器发送指令,AI可以将更符合人类语言习惯的文本或语音转化为机器行动。

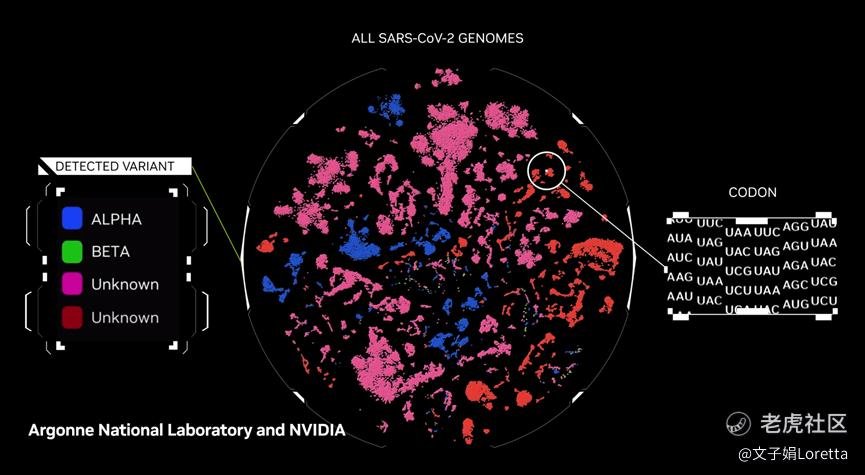

人类的生命健康守护者:预见与检测可能对人类生命健康产生威胁的因素,提前建立防范机制来抵御侵害。

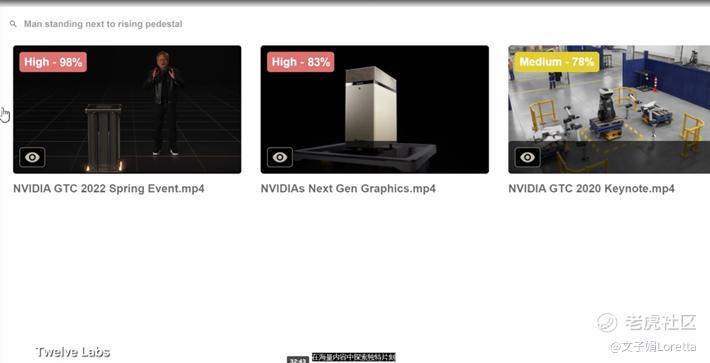

更精细化的搜索工具:接受更精细的文字描述,在海量信息中,挑选最符合的结果。

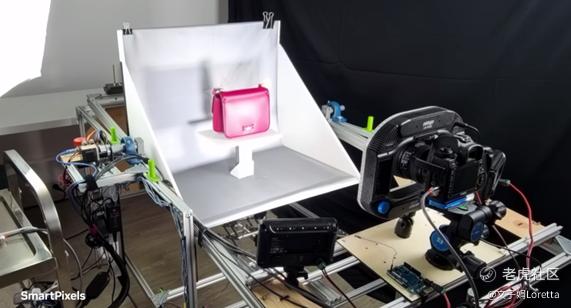

现实与虚拟的破壁者:从快照建立3D模型,实现更高水平的虚拟现实。

工作的灵感助手:为设计、编程、3D建模等创造性工作注入效率和更多的可能性。

英伟达根植加速计算领域,十年实现百万倍加速

英伟达于2006年率先提出加速运算,致力于解决普通计算机无法解决的问题。英伟达所采用的加速方案,并不仅仅局限在硬件上,而是从芯片、系统、网络、加速函式库到应用程序,自底层到顶层的各个环节上思考优化方案。每次优化的成果,都会加速一个应用的发展,涵盖绘图成像、粒子或流体力学、量子物理学、数据处理和机器学习等领域。英伟达在过去十年中为许多应用程序,实现了百万倍的加速,解决了以往不可能解决的问题。

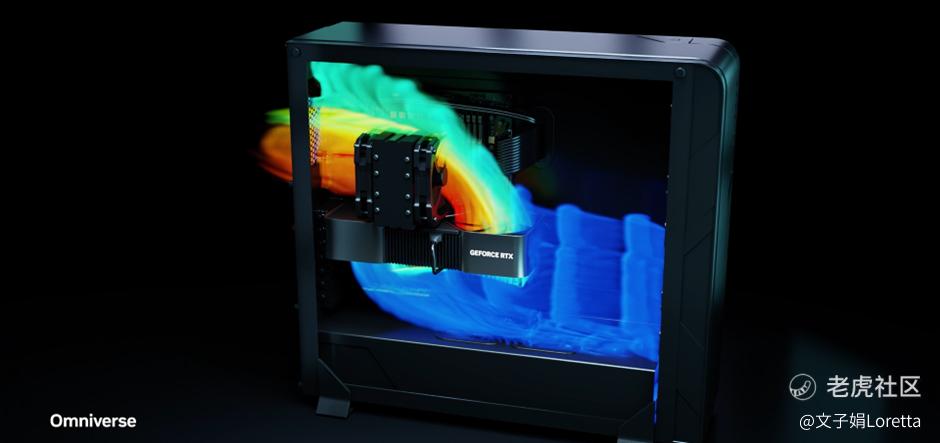

英伟达A100的工业化应用,同等条件成本可降低9倍

汽车和航天产业会使用计算流体力学 (CFD) 进行乱流和空气动力学模拟,电子产业则使用 CFD 进行散热管理设计。在这张 Cadence 的投影片中介绍了由 CUDA 加速的新 CFD 求解器。在同等系统成本下,NVIDIA A100 的运算吐吞量是CPU服务器的9倍。或者说,在同等模拟运算吐吞量下,NVIDIA 的成本可降低 9 倍,消耗的能源则可降低 17倍。Ansys、Siemens、Cadence 和其他领先业界的 CFD 求解器现在也都采用 CUDA 来加速。在全球各地,工业用 CAE 每年使用近1,000亿个CPU 核心小时。加速技术可说是节省电力和实现永续发展和净零排放的最佳方式。

英伟达RAFT助力Spark-RAPIDS大规模提升数据处理速度

世界各地有许多企业使用 Apache Spark 来处理数据池和仓储、SQL 查询、图表分析和推荐系统等工作。Spark-RAPIDS 则是 NVIDIA 的加速 Apache Spark 数据处理引擎。在全球耗费 5,000 亿美元的云端运算支出中,最大一项即是数据处理费用。Spark-RAPIDS 现在可用于加速主要的云端数据处理平台,包含 GCP Dataproc、Amazon EMR、Databricks 和 Cloudera,推荐系统会使用向量数据库来储存、编列索引、搜索和撷取非结构化数据的大量数据集。向量数据库的一个新的重要用例就是大型语言模型,可在文字生成期间,针对检索特定领域或专有事实进行查询。

我们正在引入一个新的函式库 RAFT,以加速编列索引、加载数据以及为单一查询撷取一批邻接项目。我们正在将 RAFT 加速引入 Meta 的开放原始码工具 FAISS (Facebook AI Similarity Search)。超过 1,000 个组织使用的 Milvus 开放原始码向量数据库以及具有超过40 亿次Docker 提取的 Redis。对于要建立专有大型语言模型的组织来说,向量数据库可说是无比重要。

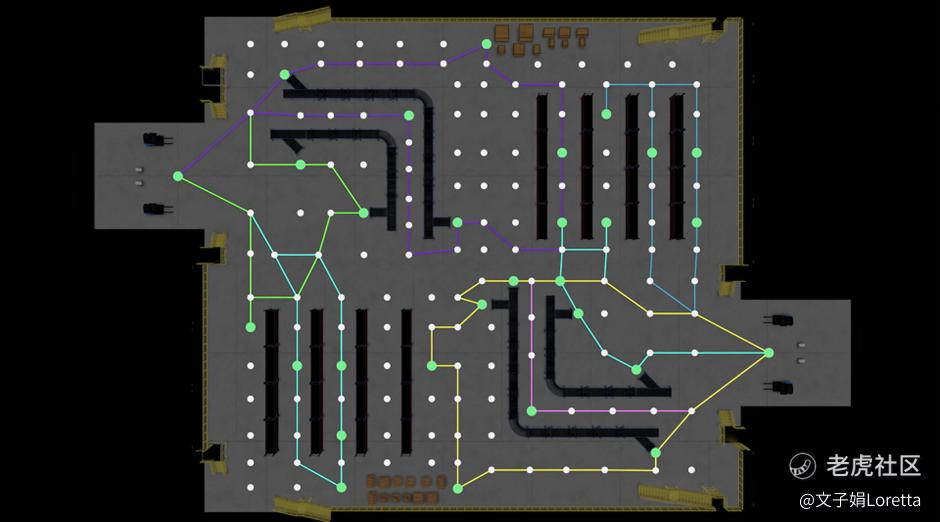

英伟达cuOpt以300亿/s的速度破世界纪录

二十二年前,作业研究领域的科学家 Li 和 Lim 提出了一系列高难度的收送货问题 (pickup and delivery problem)。在制造、运输、零售和物流领域 甚至是救灾工作,都涉及 PDP。PDP 是旅行推销员问题的更抽象版本,是 NP-hard 问题,表示没有可找出精确解答的有效算法。随着问题规模扩大,求解的时间也会呈阶乘增长。NVIDIA cuOpt 使用进化算法和加速运算,分析每秒 300 亿次的运作。不仅打破世界纪录,也为Li和Lim提出的难题找到了最佳解答。

AT&T 定期派出 30,000 名技术人员,为 700 个地理区域的 1,300 万客户提供服务。今天,AT& T以CPU执行工作,要一整晚的时间才能完成调度优化,AT&T 希望能实时找到调度解决方案,持续将紧急客户需求和整体客户满意度优化,同时针对延误和不断出现的新事件进行调整。采用 cuOpt 后,AT&T 就可用100倍的速度,更快找到解决方案,并实时更新调度解决方案。

AT&T 采用了全套 NVIDIA 人工智能函式库,除了 Spark-RAPIDS 和cuOPT,他们还使用 Riva 支持对话式人工智能,以及透过 Omniverse 创造数字分身。AT&T 正在利用 NVIDIA 加速运算和人工智能来实现永续发展 节省成本和新服务等目标。

cuOpt 还可将物流服务优化。每一年,全世界都会有 4,000 亿个包裹,投递到 3,770 亿个站点。Deloitte、Capgemini、Softserve、Accenture 和 Quantiphi 已开始使用 NVIDIA cuOpt 帮助客户推动营运优化。

英伟达cuLitho提升计算光刻速度近40倍,大大提高芯片产能

芯片产业已成为几乎所有产业的基础 芯片制造需要极高的精准度,制作特征比细菌小 1,000 倍,并与单一黄金原子或与人类一条 DNA 链的顺序相当。光刻是在晶圆上建立图案的流程,也是芯片制造流程的开始。包含两个阶段: 光掩膜制作和图案投影。基本上,这是触及物理学极限的成像问题。光掩膜就像芯片的模板光线会被阻挡,或穿过光掩膜到达晶圆而形成图案,光线则由 ASML EUV 极紫外线光刻系统产生。

在此,每个系统造价都超过 2.5 亿美元,ASML EUV 会使用激烈的方式来制造光线。激光脉冲每秒向液态锡滴发射 50,000 次,将其蒸发,并放出 13.5 奈米 EUV 的电浆,接近 X 光波长。多层膜反射镜则会将光线引导至光罩,光罩多层反射膜利用 13.5 奈米光线的干涉图案,来建立最低 3 奈米的更精细图形。简直是在施魔法。晶圆定位在四分之一奈米范围内,每秒对齐 20,000 次,以针对任何振动进行调整。进行计算光刻的这一步,也同样神奇。计算光刻应用了逆向物理算法来预测将在晶圆上产生最终图案的光罩上的图案。

事实上,光罩上的图案根本不像最终的图形,表达式微影模拟了马克士威 (Maxwell) 方程式中光线通过光学组件,并与光阻剂互相作用的行为。表达式微影是芯片设计和制造中 产生最大运算工作量的一环,每年可消耗数百亿个 CPU 小时。大型数据中心往往全年无休运作以建立光刻系统中使用的光掩膜。在芯片制造商每年投入近 2,000 亿美元的资本支出中,这些数据中心的运作成本也占了一部份。随着算法复杂度增加,计算光刻技术也正快速发展。使该产业能够达到 2 纳米精确度,甚至超越此水平。

NVIDIA宣布推出cuLitho 这是一个计算光刻函式库。cuLitho 是一项耗时近四年的巨作,透过与台积电 (TSMC) ASML 和 Synopsys 的密切合作,将计算光刻加快了超过40倍。NVIDIA H100 有 89 个光掩膜板,目前,在 CPU 上执行的单一光掩膜板,需要两周的时间来处理。在GPU上执行的 cuLitho 则可在一次8小时内处理一个光掩膜板,仅需要 500 台。

DGX H100 的系统上以 cuLitho 进行加速,台积电可以减少用于计算光刻的40,000 台 CPU 服务器数量,从而将功率从 35 万亿瓦降低到仅 5 万亿瓦。

借助 cuLitho,台积电便能缩短原型周期时间、提高产量、减少制造过程中的碳足迹,并为 2 奈米及更高阶技术做好准备。今年 6 月起,台积电将开始采用 cuLitho 来生产。每个产业都需要加速每项工作负载,这样我们才能节省电力并达到事半功倍。

英伟达BlueField 与头部数据中心协同合作

在现代软件定义的数据中心中,执行虚拟化、网络、储存和安全等作业的操作系统,往往会消耗数据中心近一半的 CPU 核心和相关电力,数据中心必须加速每个工作负载,以节省电力并释放 CPU,以用于可创造营收的工作负载。NVIDIA BlueField 可卸载并加速数据中心操作系统和基础架构软件。目前有二十多名生态系合作伙伴,包含 Check Point 思科 (Cisco)、DDN、Dell EMC、Juniper、Palo Alto Networks、Red Hat 和 VMWare 都采用了 BlueField 的数据中心加速技术,来以更效率执行自己的软件平台。

BlueField-3 已进入生产阶段,并由领先的云端服务供货商,包含百度、CoreWeave、京东 (JD.com)、Microsoft Azure、Oracle OCI 和腾讯游戏 (Tencent Games) 所采用,以加速他们的云端运作。

英伟达DGX——大语言模型背后的功臣

NVIDIA 加速运算的起点是 DGX ,这是世界级的人工智能超级计算机,也是推动大型语言模型技术突破背后的引擎。 当初,就是我亲手将世界上第一个 DGX 交给 OpenAI。从那时起,名列《财富》杂志 (Fortune) 100 强的企业中已有半数都安装了 DGX 人工智能超级计算机。DGX 已经成为人工智能的必备工具。 DGX 的 GPU 包含了八个 H100 模块,H100 有一个 Transformer Engine 用于处理像 ChatGPT 这样令人赞叹的模型,GPT 正是「生成式预先训练的 Transformer」(Generative Pre-trained Transformer) 的缩写 8 个 H100 模块透过 NVLINK 交换器建立 NVLINK 连结,以实现完全无阻塞的运算。8 个 H100 可组成一个巨大的 GPU 来运作。

计算网络是人工智能超级计算机最重要的系统之一。400 Gbps 超低延迟 NVIDIA Quantum InfiniBand,具有网络内处理功能,可将数十万个 DGX 节点连接到人工智能超级计算机中。NVIDIA DGX H100 是全球客户建立人工智能基础架构的蓝图。目前已全面进入生产阶段 Microsoft 已经宣布,Azure 即将开放 H100 人工智能超级计算机的个人预览版,我很高兴听到这个消息.不久后,Atos、AWS、Cirrascale、CoreWeave、Dell、Gigabyte、Google、HPE、Lambda Labs、Lenovo、Oracle、Quanta 和 SuperMicro也将陆续推出其他系统和云端服务。

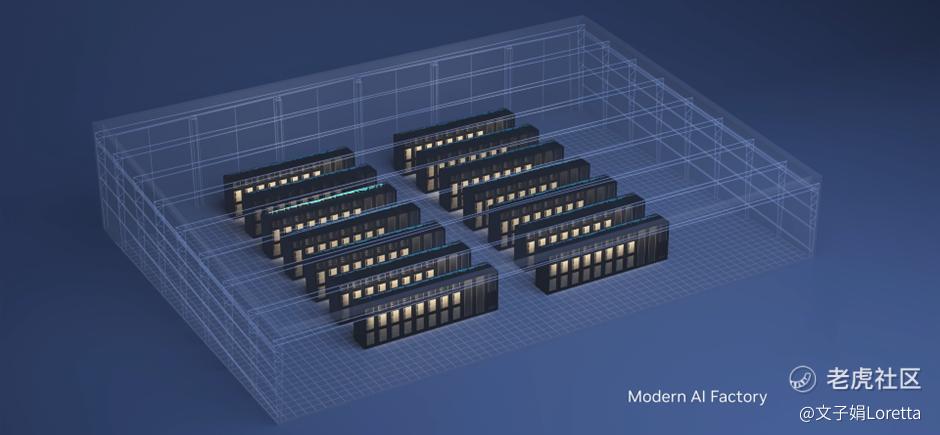

DGX 人工智能超级计算机的市场已大有成长。DGX 人工智能超级计算机最初的用途是人工智能研究仪器,现在正在扩展到营运领域。可全天候执行,进行调整数据和处理人工智能等工作。DGX 超级计算机可说是当代的人工智能工厂。

人工智能的【iphone时刻】已经到来

我们拥有 50 家 EA 企业客户,涵盖消费者因特网和软件、医疗保健、媒体与娱乐和金融服务等产业 ChatGPT、Stable Diffusion、DALL-E 和 Midjourney。已激起全世界探究生成式人工智能的好奇心。这些应用程序的功能不仅容易上手,也令人赞叹,在短短几个月内,便吸引了超过一亿名使用者。ChatGPT 更是有史以来成长最快速的应用程序 而且,不必进行任何训练,即可使用只要开口要求模型做一些事情就好。无论提示精确或是模棱两可,模型都能运作如果表达得不够清楚 ChatGPT 也能透过对话了解使用者的目的。ChatGPT 所产生的文本质量也超乎想象。ChatGPT 不仅可撰写备忘录和作诗、整理研究论文内容、解答数学问题、为契约划重点,甚至能写出软件程序。

ChatGPT就像一部计算机,不仅可执行软件,也可以编写软件。生成式人工智能能够发展到这个程度,都归功于众多技术上的突破。首先是 Transformer 从数据的关系和相依性中,平行且大规模地学习上下文和文义;接下来,大型语言模型从大量数据中学习后,便可在未经过专门训练的情况下,执行下游任务。还有受物理学启发的扩散模型,无须监督即可进行学习,并产生影像。

在短短十多年里,我们已从努力辨认猫的模样,进展到能够产生穿着宇宙飞行服的猫,在月球上行走的逼真影像。生成式人工智能俨然是一种新型态的计算机,也就是我们用人类语言设计出的计算机。能发展出这样的能力,意义相当深远,这表示每个人都可以指挥计算机来解决问题。以往,这是只有计算机程序设计师能涉足的领域 如今,人人都可以当工程师。生成式人工智能是一种全新的运算平台,就像 PC、因特网、行动装置和云端一样。正如之前的运算时代,业界先驱会创造出新的应用程序,并成立新公司,以利用生成式人工智能的自动化和共同创造能力。

Debuild 则让使用者只需解释自己想要什么,就可以设计和部署网络应用程序。写作辅助工具 Grammarly 可考虑上下文意涵 ,Tabnine 能帮助开发人员编写程序代码,Omnekey 可生成量身打造的广告和文案, Kore.ai 是一个虚拟客户服务人员代理程序,Jasper 可产生营销素材Jasper 已经写出近 50 亿字,将产生初稿的时间减少了 80% ,Insilico 也使用人工智能来加速药物设计,Absci 目前已采用人工智能来预测治疗抗体。

英伟达AI Foundation助力更多颠覆性AI产品的出现

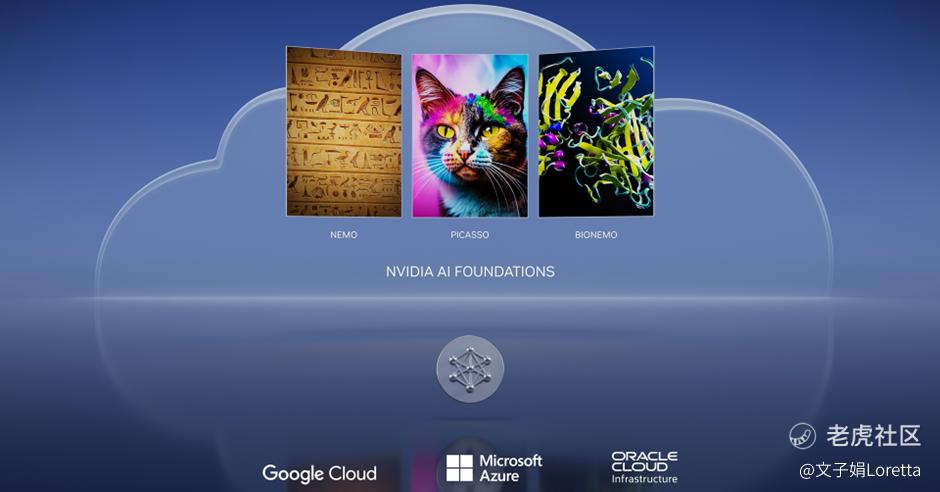

今天我们宣布推出 NVIDIA AI Foundations 这款云端服务,相当适合需要建立、完善与操作自定义大型语言模型和生成式人工智能的客户。该模型与人工智能使用专有数据训练,可供特定领域的工作使用。 NVIDIA AI Foundations 由语言视觉与生物学模型制作服务所组成。

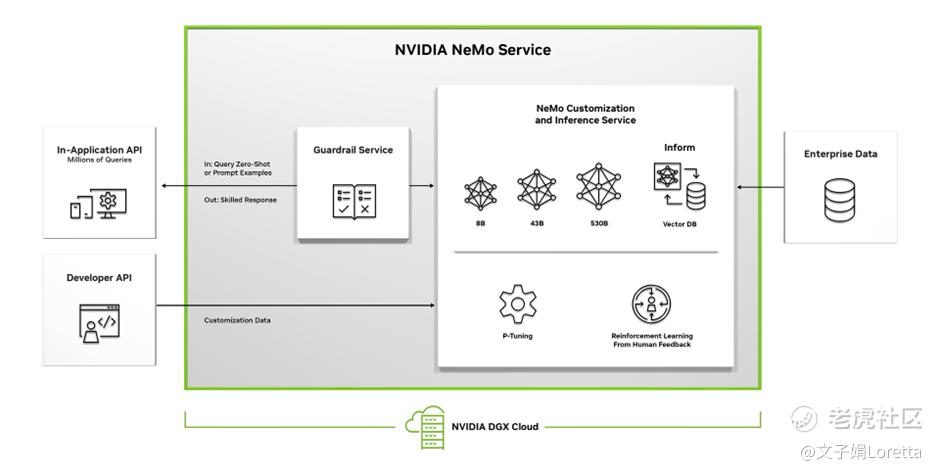

NVIDIA Nemo 是用于建立自定义语言,文字转文字的生成模型。客户可以使用自己的模型,或使用 Nemo 预先训练的语言模型开始着手,该模型包含 GPT-8、GPT-43到 GPT-530 B 参数,从建立专有模型到营运的整个过程,NVIDIA 人工智能专家将与您合作。

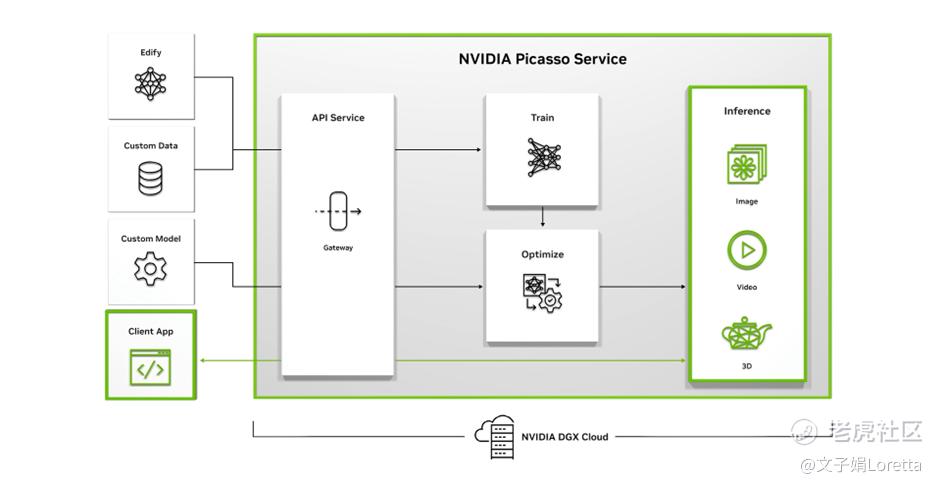

Picasso 是制作视觉语言模型的服务,若客户想要建立透过授权或专有内容训练的自定义模型。NVIDIA Picasso 是一种云端服务,用于建构和部署生成式人工智能影像、影片和 3D 应用程序,借由该服务,企业、ISV 和服务供货商,就可以部署自己的模型。

我们正在与主要合作伙伴合作,为每个行业提供生成式人工智能功能,组织还可以从 NVIDIA Edify 模型入手,并根据数据进行训练以建立产品或服务。这些模型可以生成影像、影片和 3D 资产 若要使用生成式人工智能模型,应用程序会传送含有文字提示和元数据的API呼叫Picasso。Picasso 会使用在 NVIDIA DGX Cloud 上执行的适当模型,将生成资产传响应用程序,内容可能是拟真的影像、高分辨率影片 或是详细的3D几何图形,产生的资产可以输入编辑工具或 NVIDIA Omniverse 中,以建构拟真的虚拟世界。元宇宙应用程序和数字孪生仿真,透过在 NVIDIA DGX Cloud 上执行的 NVIDIA Picasso 服务,您可以简化建构自定义生成式人工智能应用程序、所需的训练、优化和推理。

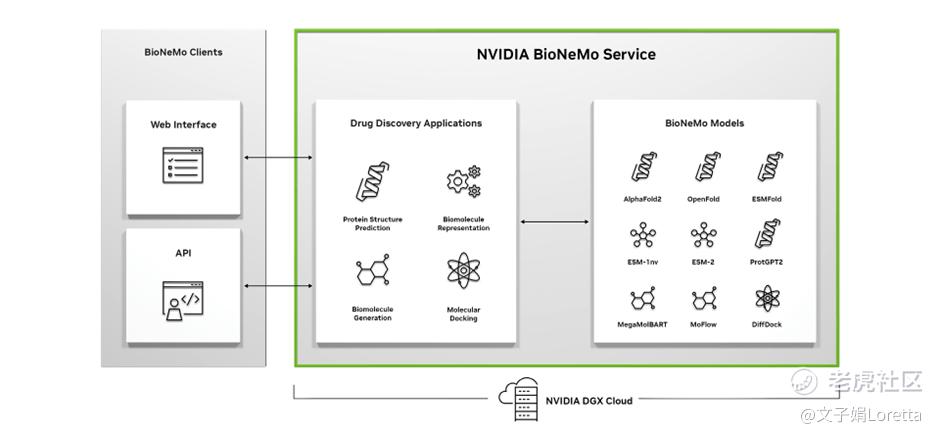

我们的第三语言领域是生物学。药物开发是一个价值约为2万亿的产业,其中投资到研发部门的资金共有 2,500 亿,NVIDIA Clara 是用于影像、仪器、基因体学和药物开发的医疗照护应用程序框架。该产业开始运用生成式人工智能 来探索疾病目标,设计新分子或以蛋白质为基础的药物,并预测药物在体内的行为。在数百家新兴人工智能药物开发的新创公司之中,Insilico Medicine、Exscientia、Absci 和 Evozyme 皆属于其中一员。其中有些新创公司已经发现了新目标或候选药物,且已开始着手进行人体临床试验。BioNemo 协助研究人员使用专有数据 建立、微调和提供自定义模型。如今,生成式人工智能正在转变药物开发过程的每一步。NVIDIA BioNeMo 服务以云端服务形式,提供最先进的药物开发生成式人工智能模型,可立即轻松加速药物开发工作流程。

NVIDIA AI Foundations 是云端服务,也是铸造厂,能够建立自定义语言模型和生成式人工智能。自十年前推出 AlexNet 以来,深度学习开辟了广大的新市场,其中包含自动驾驶、机器人以及智能喇叭。此外也重塑了我们购物、接收新知与欣赏音乐的方式 这只是冰山一角而已。

人工智能正处于转折点,因为生成式 AI 已经开启了新的机遇浪潮,推动了推理工作负载的阶跃式的增长,人工智能现在可以生成多种数据,包含语音、文字、影像、影片、3D 图像,以及蛋白质与化学物质。

英伟达全新推理平台兼具弹性与适应性

设计云端数据中心来处理生成式人工智能是一项相当艰巨的挑战。一方面来看,使用单一类型的加速器是理想之选,因为这让数据中心具有弹性,也可以处理无法预测的流量尖峰和低谷。另一方面而言,却没有加速器能够以最佳方式处理算法、模型、数据类型和大小的多样性。NVIDIA 的One Architecture平台,提供了加速与弹性。

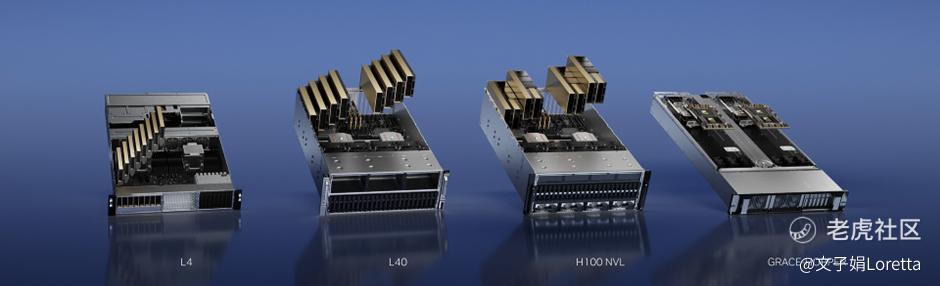

今天,我们宣布推出全新的推理平台,其中有四种配置、一个体系架构,一个软件堆栈。每种设定都针对工作负载的一个类型优化。

英伟达推出L4 GPU,真正做到以一敌百

对于人工智能影片工作负载,我们推出了L4,针对影片译码与转码、影片内容审核以及如背景替换、重新照明、眼神交流 转译服务与实时影片翻译等等功能进行优化。现今大多数的云端影片都在CPU进行处理,一台8-GPU L4的服务器将能够取代一百多台用于处理人工智能影片的的双插槽 CPU 服务器。

Snap 是 NVIDIA 人工智能在计算机视觉和推荐系统方面的先驱用户,Snap 会透过 L4 使用 AV1 影片处理生成式人工智能和扩增实境。Snapchat 的使用者每天上传数亿部影片。Google 今天宣布在 GCP 推出 NVIDIA L4。NVIDIA 和 Google Cloud 正携手合作几个主要的工作负载在 L4 上加速。让我来介绍其中五个工作负载:第一,为 Wombo 和 Descript 等客户推理生成式人工智能模型;第二,我们正在整合 Triton 推理服务器与 Google Kubernetes Engine 和 VertexAI;第三,我们正在使用 NVIDIA Spark-RAPIDS 加速 Google Dataproc;第四,我们正在加速 Google 的 AlphaFold 以及 UL2 和 T5 大型语言模型;第五,加速 Google Cloud 渲染 3D 和扩增实境体验的沉浸式串流。透过这次合作,Google GCP 成为首屈一指的 NVIDIA 人工智能云端平台。我们期待可以尽快,告诉您更多关于合作的信息。

英伟达推出L40 GPU,较当下流行产品性能高达10倍以上

针对 Omniverse、绘图运算渲染,以及如文字转影像和文字转影片的生成式人工智能,我们宣布推出 L40。相较于最流行的云端推理, GPU NVIDIA T4 L40 的性能最高可达 10 倍以上。Runway 是生成式人工智能的先驱,其研究团队是 Stable Diffusion 及其前身 latent diffusion 的主要创立者。Runway 正在发明用于建立和编辑内容的生成式人工智能模型,凭借着 30 多种人工智能魔术工具,他们的服务正彻底颠覆创作过程,而一切都来自云端。

英伟达推出H100 NVL,专服务于chatGPT类大型语言模型

像 ChatGPT 这样的大型语言模型,是一种重大的全新推理工作负载,GPT模型需要海量存储器和运算资源。 此外,推理的过程是大量且横向扩展的工作负载,需要使用标准商用服务器。对于如 ChatGPT 这样的大型语言模型推理,我们宣布推出新的 Hopper GPU——配备双GPU NVLINK的PCIE, 拥有 94GB 的 HBM3 显存。H100 可以处理 1750 亿个参数的 GPT-3,而支持商用 PCIE 服务器,可以让它更轻易地横向扩充。目前云端唯一可以实际处理 ChatGPT 的 GPU 是 HGX A100,相较于处理GPT-3的HGX A100,拥有4对双 GPU NVLINK 的 H100 标准服务器,速度加快了10倍,H100 可以大幅度降低大型语言模型的处理成本。

英伟达推出Grace Hopper,传输速度快7倍

Grace Hopper 是我们的全新超级芯片,透过高速的每秒 900 GB 芯片对芯片一致性接口来连接 Grace CPU 和 Hopper GPU。Grace Hopper非常适合处理大型数据集,例如用于推荐系统和大型语言模型的人工智能数据库。如今,具有大型内存的 CPU 可以储存和查询大型的嵌入式表格,并将结果传输到 GPU 进行推理。借由 Grace-Hopper,Grace 可以查询嵌入式表格,并透过高速接口将结果直接传输到 Hopper,传输过程比 PCIE 快了 7 倍。客户希望可以建立更大型的人工智能数据库,Grace-Hopper 是最理想的引擎 。这是 NVIDIA 的推理平台,是一种适用于各种人工智能工作负载的架构,也适合最大的数据中心加速和弹性。

字数受限,更多移步公号,同名。

精彩评论