12月18日,2024冬季火山引擎Force原动力大会上,豆包发布视觉理解模型,豆包视觉理解模型具备更强的内容识别能力、理解和推理、视觉描述等能力。

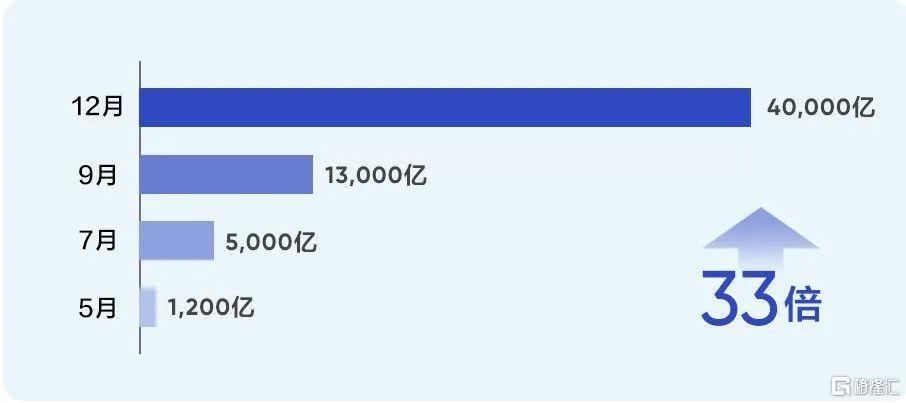

截至目前,豆包大模型日均tokens使用量超过4万亿,发布7个月以来增长超过33倍。

受此消息影响,今日A股抖音豆包概念股再次集体上涨。截至收盘,博瑞传播、遥望科技、紫天科技等涨停,天娱数科、视觉中国等跟涨。

豆包“全家桶”更新

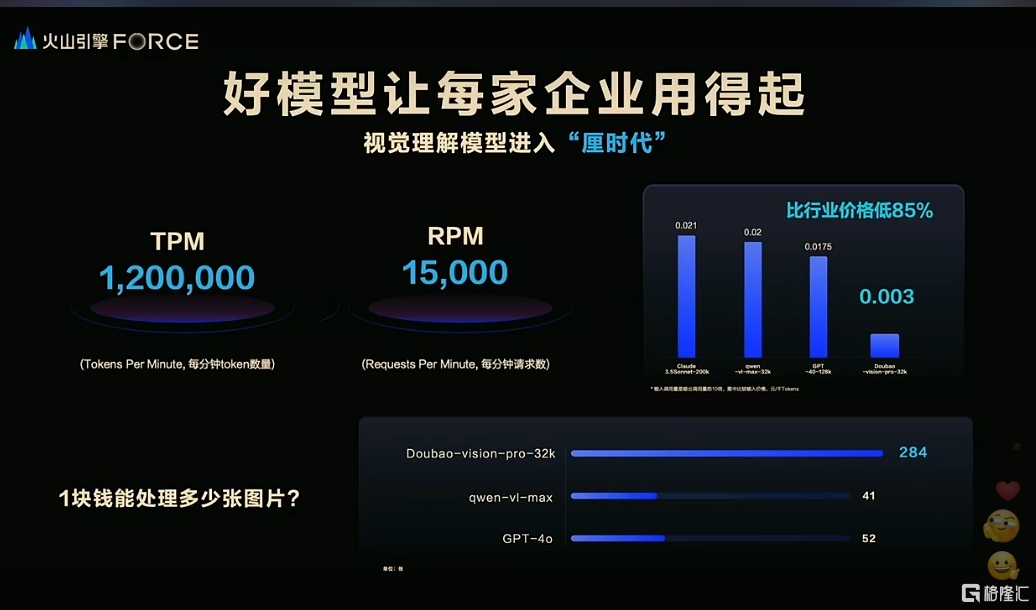

火山引擎总裁谭待表示,豆包视觉推理大模型进入“厘时代”,该模型的千tokens输入价格仅为0.003元,一元钱可以处理284张720P图片,比行业价格便宜85%。这一价格的降低,使得AI技术更加普惠,加速了大模型在各行各业的应用落地。

豆包视觉理解模型的能力不仅限于识别视觉内容,它还具备出色的理解和推理能力。这意味着模型能够根据图像信息进行复杂的逻辑计算,完成分析图表、处理代码、解答学科问题等任务。

这种能力的提升,使得豆包大模型在多模态交互上补齐了短板,为AI硬件产品的发展提供了更多可能性。例如,智能体耳机、智能玩偶、台灯等AI硬件产品,将能够实现更高层次的交互,不再局限于语音层面。

视觉能力是大模型能力的核心,因为视觉输入占据了人类交互信息的绝大多数。在下一代AI硬件终端中,如AI玩具或AI眼镜,视觉SoC有望成为标配,这也将新增对NAND存储芯片的需求。

豆包大模型的升级,也带来了算力需求的增长。随着模型从文字到视觉理解模型和视频生成模型的扩展,字节跳动的算力需求或许又要再上一个台阶。

据分析师测算,以ChatGPT MAU(月活用户)为6亿来看,推理需求约需35万个A100显卡,训练需求需12万个A100显卡。视频大模型对算力的需求势必更高,例如即梦AI的视频生成模型Magic Video v2若MAU达到1亿,且每天有生成10分钟视频的需求,则需28万个英伟达H100 GPU,MAU达到2亿时,对H100的需求将达到55万个。

这一算力需求的增长,对于A股中字节跳动算力硬件相关公司来说,是一个巨大的机遇。民生证券指出,豆包用户数的快速增长带来的将是算力中心的扩建,进而带动AI服务器需求提升;同时,算力中心扩建带来的不仅是基础建设需求,更多的是热管理的需求,字节AI端液冷有望拉动广阔市场空间。

大模型应用加速落地

豆包大模型的应用正在快速扩展至多个行业。根据最新数据,截至12月中旬,豆包通用模型的日均tokens使用量已突破4万亿,相较于七个月前首次亮相时增长了33倍。

目前,豆包大模型已经与80%的主要汽车品牌建立了合作关系,并成功集成到众多手机、PC等智能设备中,覆盖的终端设备数量达到了3亿台,智能终端对豆包大模型的调用次数在半年内增长了100倍,其中赛力斯汽车的模型调用量提升1400倍。

据不完全统计字节今年发布的 AI 应用就有接近 20 款,基本覆盖了图像、语音、音乐、视频、3D 等主流的模态和场景,还推出了 AI 耳机 Ola Friend 等硬件产品。

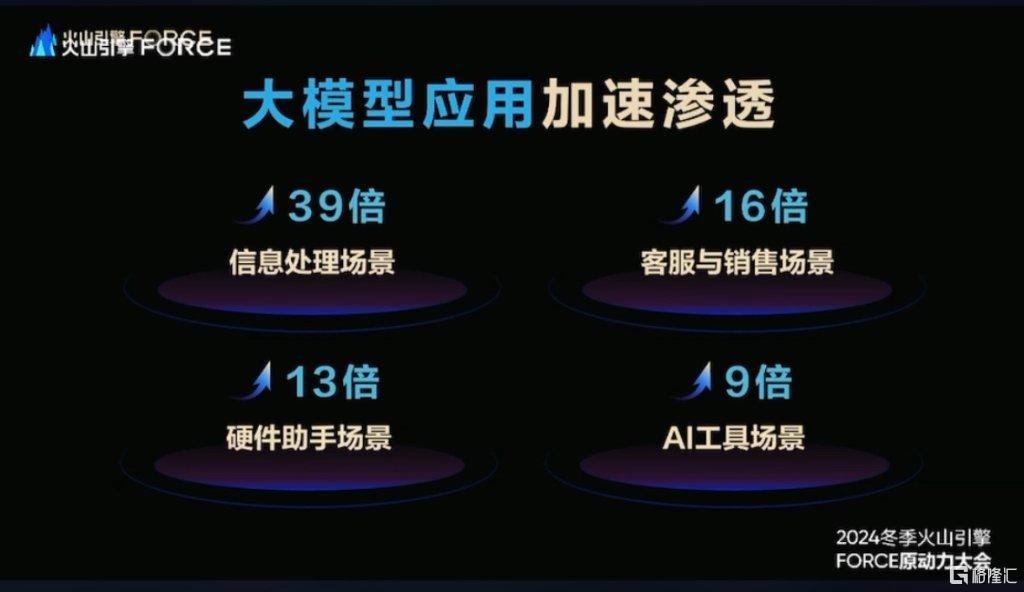

在企业提升生产力方面,豆包大模型赢得了众多企业用户的支持。在过去三个月中,豆包大模型在信息处理领域的调用次数增长了39倍,客户服务和销售场景增长了16倍,硬件终端场景增长了13倍,AI工具场景增长了9倍,教育学习等领域也实现了显著增长。

豆包大模型的升级也带动了多款产品的更新换代。豆包通用模型pro已经与GPT-4o保持同步,但其使用成本仅为后者的1/8;音乐模型从生成60秒的简单旋律升级到能够创作3分钟的完整曲目;文生图模型2.1版本在业界首次实现了精确生成汉字和一句话P图的商业化能力,该模型已经集成到即梦AI和豆包App中。

预计在2025年春季,豆包视频生成模型1.5版将发布,它将具备更长视频的生成能力。同时,豆包端到端实时语音模型也即将推出,这将带来多角色演绎、方言转换等新功能。此外,随着对热管理需求的增加,字节AI端液冷技术有望开拓更广阔的市场空间。

精彩评论